Cuando te dedicas al SEO descubres que no todas las actividades te resultan igual de atractivas.

Por ejemplo, yo disfruto mucho haciendo un Keyword Research, pero me gusta más bien poco la gestión del Link Building.

Pero además hay ciertas tareas que requieren una buena dosis de conocimientos técnicos y no están al alcance de cualquiera.

Hasta ahora.

JetOctopus es una potente herramienta que consigue hacer mucho más sencillas gran parte de las labores que se enmarcan dentro del denominado SEO técnico.

He tenido la oportunidad de probarla a fondo y por eso te traigo el que quizá sea el tutorial más completo sobre JetOctopus que puedes encontrar hoy en día en Internet.

Te invito a revisar conmigo todo lo que esta gran herramienta te puede ofrecer.

¿Qué es JetOctopus?

JetOctopus es una herramienta online que te ayuda a realizar un análisis de tu web desde el punto de vista del SEO técnico.

Para ello, este software cuenta con dos funcionalidades principales: un crawler, que recorrerá todas la URL de tu web en busca de posibles problemas, y un analizador de los ficheros de log de tu propio servidor.

Como te he comentado, se trata de una herramienta online. Esta característica, que hoy en día puede pasar inadvertida, en este caso supone un aspecto diferencial respecto a otras herramientas SEO.

Tanto el rastreo de una web, como el análisis de miles de líneas de logs, implican un trabajo computacional muy elevado.

Algunas aplicaciones de este estilo, como el conocidísimo Screaming Frog, se ejecutan directamente en tu PC, con las limitaciones que esto supone.

JetOctopus, en cambio, realiza todas las operaciones en sus propios servidores. De este modo, los recursos que utiliza no están condicionados por las características de tu equipo, es mucho más rápido y te permite seguir realizando otras tareas mientras acaba.

Pero JetOctopus no es sólo un crawler y un analizador de log. Es mucho más.

Y lo vas a poder descubrir a lo largo de esta guía completa de JetOctopus.

Entendiendo el SEO técnico

Imagina que tienes 12 años y vas a un parque de atracciones. ¿Te pasarías toda la tarde en el tiovivo que hay a la entrada?

Seguramente no. Lo más probable es que recorras el parque de atracción en atracción y aproveches cada minuto que pases allí.

- Quizá te subas una vez a la noria. Dos a los autos de choque.

- En el túnel del terror te prohíben la entrada porque no tienes la edad recomendada.

- En la rana hay demasiada fila, así que te cansas de esperar.

- El barco pirata está averiado y no puedes probarlo.

- Y al tiovivo sólo le echas un vistazo al pasar.

Por lo tanto, cuanto más fácil se lo pongas, mayor será el partido que puedes sacar de esa visita.

- Muéstrale el camino a las páginas más importantes de tu web, a través de una correcta estructura web y un buen enlazado interno.

- Indícale dónde debe y no debe entrar, mediante un uso correcto de las etiquetas index y follow.

- No le pongas trabas con demasiadas redirecciones, tiempos de carga excesivos, ni páginas erróneas.

- En definitiva, consigue que la visita del robot de Google sea lo más productiva posible.

¿Qué ofrece JetOctopus?

El SEO técnico tiene una gran importancia a la hora de posicionar tu web.

Sin embargo, en demasiadas ocasiones no se le presta la atención que se debería.

Y creo que el término “técnico” tiene gran parte de culpa de esto.

Muchos SEOs no provienen del campo de la informática, por lo que hay ciertas tareas que pueden provocarles bastante respeto, al menos inicialmente.

Revisar los logs de un servidor, analizar códigos de respuesta HTTP, medir los tiempos de carga de las páginas o estudiar el comportamiento de diferentes bots de Internet, son tareas que pueden resultar complejas al tratarse de SEO avanzado.

Y JetOctopus es una de ellas.

Este software recopila una gran cantidad de datos sobre la estructura y el comportamiento de tu sitio web y te los muestra de una manera muy amigable y sencilla de comprender.

Su filosofía es ir de menos a más. Con una navegación muy intuitiva que te permite analizar cada detalle. Desde la visión más general al aspecto más concreto.

Y para ello, basa su funcionamiento en tres patas principales (¿o debería decir tentáculos?).

- Dos de ellas ya te las he comentado: su crawler y el análisis de logs.

- La otra es la integración con Google Search Console.

Vamos a verlo un poco más en detalle.

Crawler de páginas de un sitio web

Las primeras versiones de JetOctopus únicamente incluían el módulo de Crawler.

Por eso, quizá sea una de las funcionalidades más pulida y más valorada por los usuarios de la aplicación.

Y no es para menos.

JetOctopus es una de las herramientas de crawling más rápidas del mercado. Si no, la que más.

Es capaz de recorrer hasta 250 páginas por segundo, siempre y cuando tu servidor soporte ese ritmo de peticiones. Si no, tienes la posibilidad de ajustarlo en la configuración.

Dado que todo el proceso se lleva a cabo en el servidor, no hace falta que estés delante de la pantalla esperando a que termine. JetOctopus te enviará un email cuando haya acabado.

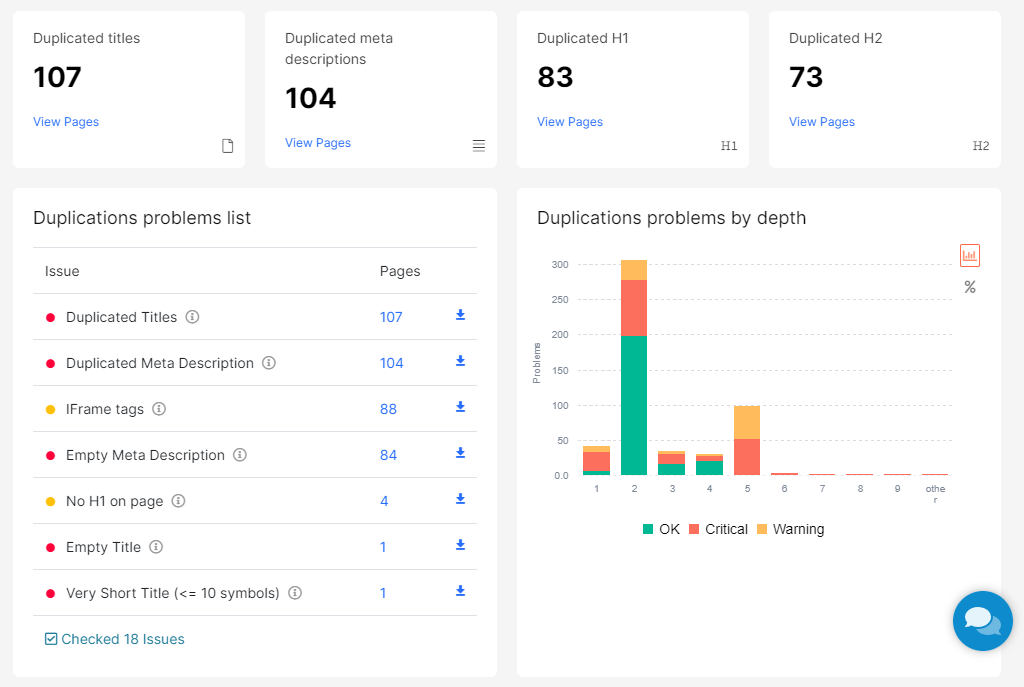

Gracias al crawler podrás identificar fácilmente qué problemas tiene tu web relacionados con aspectos tan relevantes como la indexación, tiempos de carga, respuestas de error, elementos duplicados o gestión del enlazado interno, entre otros.

Además, JetOctopus tiene la opción de interpretar el JavaScript de las páginas de tu web, al tiempo que identifica posibles problemas que pueden afectar a su indexación y comprensión por parte de los buscadores.

Más adelante te explico cómo funciona el crawler de JetOctopus.

Análisis de logs

Quien ha trabajado alguna vez en la administración de sistemas informáticos o ha participado en el desarrollo de una aplicación software, sabe que los ficheros de log son uno de sus mejores aliados.

En los ficheros de log se registra toda la actividad importante que tiene lugar en un sistema operativo, servidor web o aplicación informática.

Y eso es de una ayuda enorme cuando se quieren identificar errores o comportamientos no deseados.

Como habrás adivinado, entre estos accesos, también están los robots de Google o de otros buscadores, por lo que podemos analizarlos y sacar conclusiones sobre los rastreros que hacen de nuestra web.

Pero hay un problema: estos ficheros pueden ser enormes y muy farragosos de interpretar.

Una vez más, JetOctopus nos facilita esta ardua tarea.

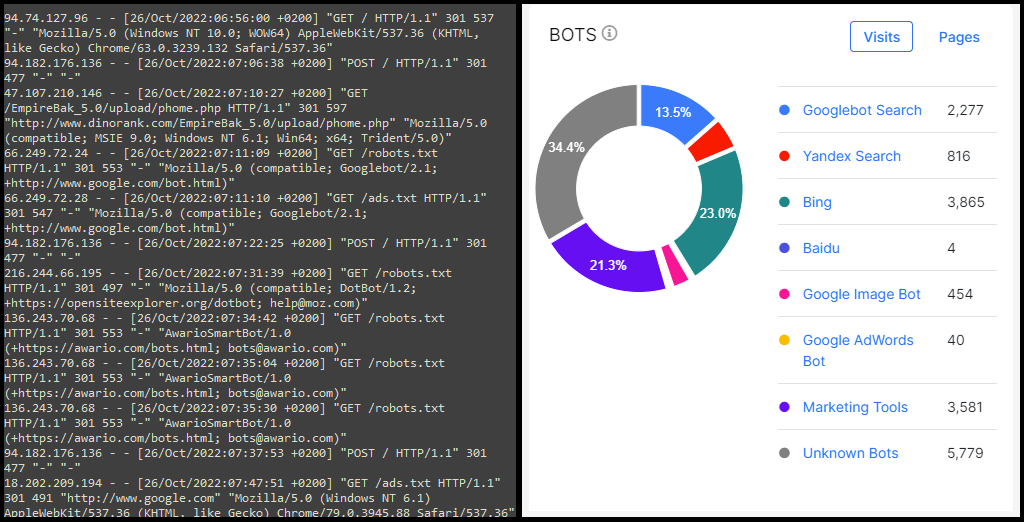

Pero, como una imagen vale más que mil palabras, simplemente echa un vistazo a la siguiente captura.

¿Qué lado de la imagen te resulta más sencillo de entender?

Yo lo tengo claro.

Así, gracias al módulo de análisis de logs de JetOctopus, podemos integrar los ficheros de nuestro servidor de varias maneras y visualizar la información de manera muy intuitiva.

Más adelante veremos en profundidad este módulo de análisis de logs.

Análisis de estadísticas de Google Search Console

Una de las primeras cosas que hacemos (o deberíamos hacer) cuando tenemos nuestra web creada es registrarla en Google Search Console.

Esta herramienta gratuita es fundamental para conocer cómo el propio Google indexa nuestro sitio web.

La información que obtenemos es enorme, pero hay que reconocer que la representación de la misma deja bastante que desear.

Si queremos explotar los datos de SEO de GSC y analizarlos en profundidad, la mayoría de las veces debemos recurrir a la exportación a Excel para manipularlos un poco mejor.

Con JetOctopus, todas estas tareas de análisis se simplifican al máximo.

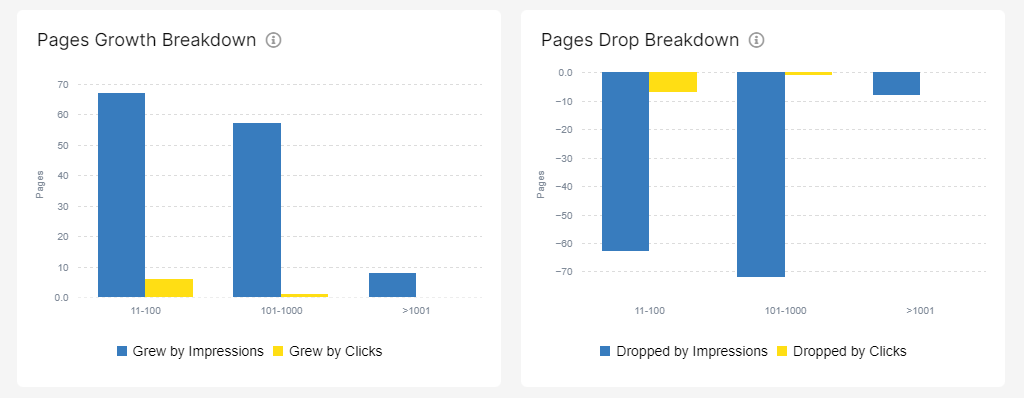

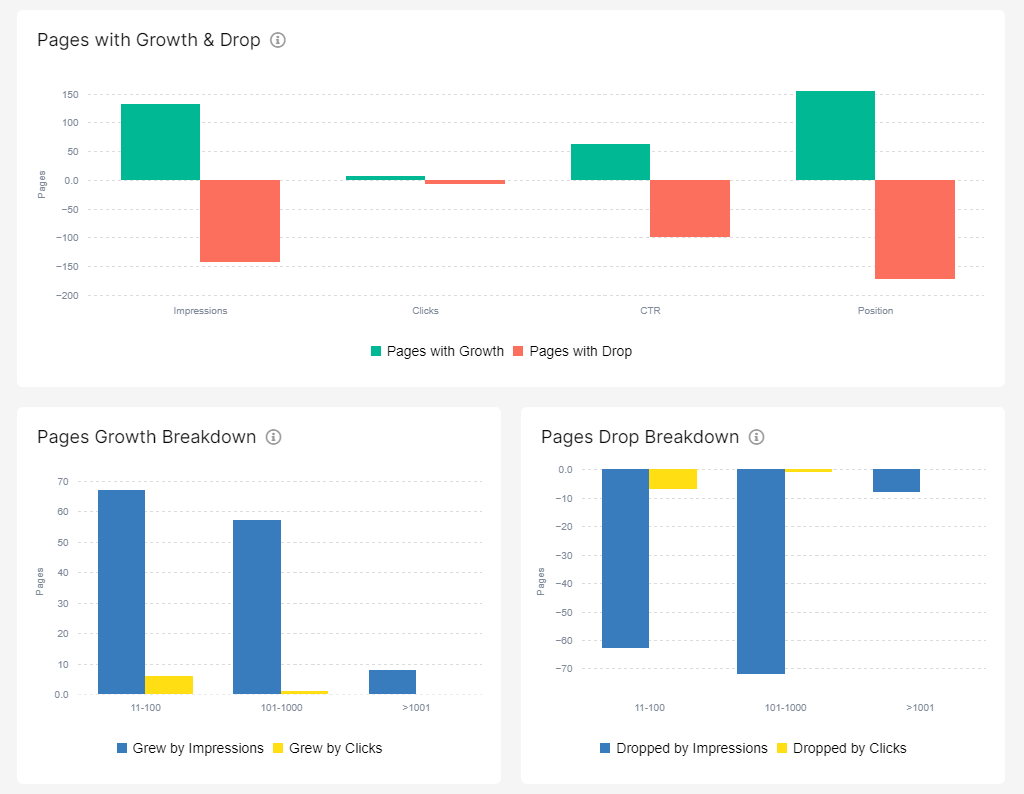

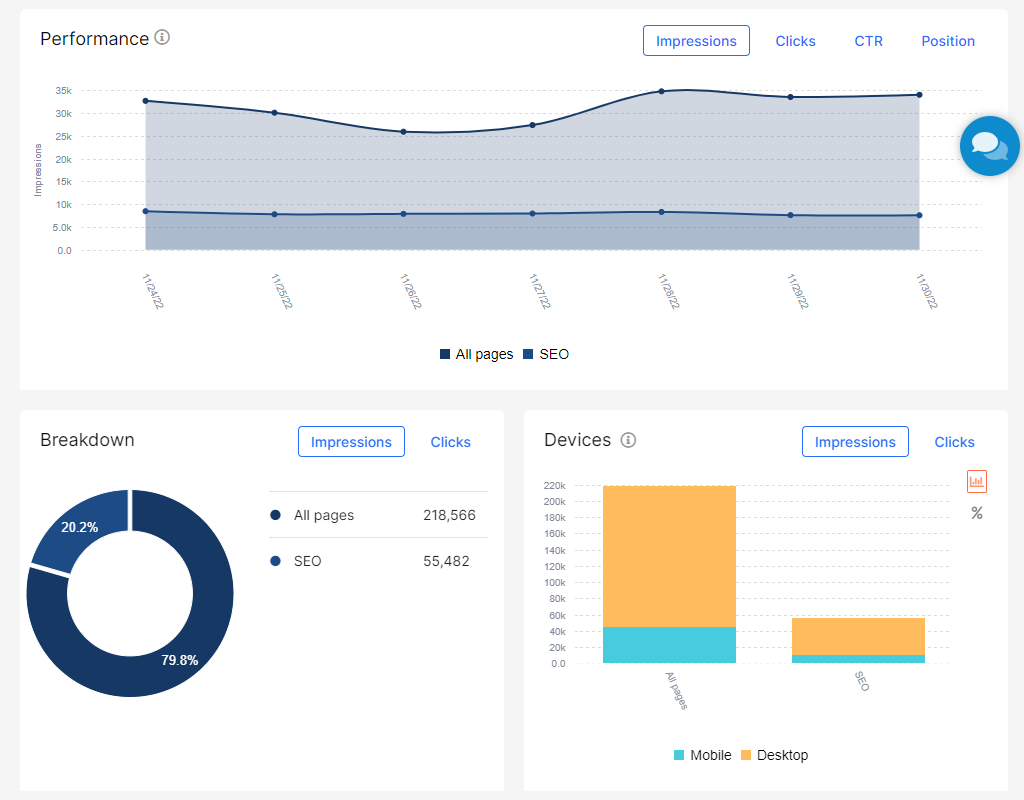

Cuando enlazamos nuestro GSC con la herramienta obtenemos varios gráficos como los de la siguiente pantalla.

De un rápido vistazo podemos conocer fácilmente datos como la tendencia de impresiones y clics, las páginas que suben y bajan, las palabras clave por las que posicionan nuestras páginas y sus variaciones, los países y dispositivos desde los que se consulta nuestra web, o qué páginas se están canibalizando entre sí y para qué keywords.

Si quieres conocer más en detalle todo lo que te ofrece este módulo, puedes ir directamente aquí.

¿Quién usa JetOctopus?

JetOctopus es una herramienta de gran utilidad para todo aquel profesional que quiere mejorar la visibilidad en los buscadores de su sitio web.

Ahora bien, no se trata de una solución para todos los bolsillos.

Sus planes mensuales empiezan en los 160 € y, aunque ofrecen una versatilidad que puede ser más que suficiente para la mayoría de usuarios, se trata de un precio que hay que pensarse dos veces antes de asumirlo.

En los siguientes apartados voy a hacer un recorrido completo por toda la herramienta. Así podrás decidir por ti mismo si JetOctopus encaja o no dentro de tu estrategia para controlar el SEO de tus webs.

Primeros pasos: configura tu proyecto

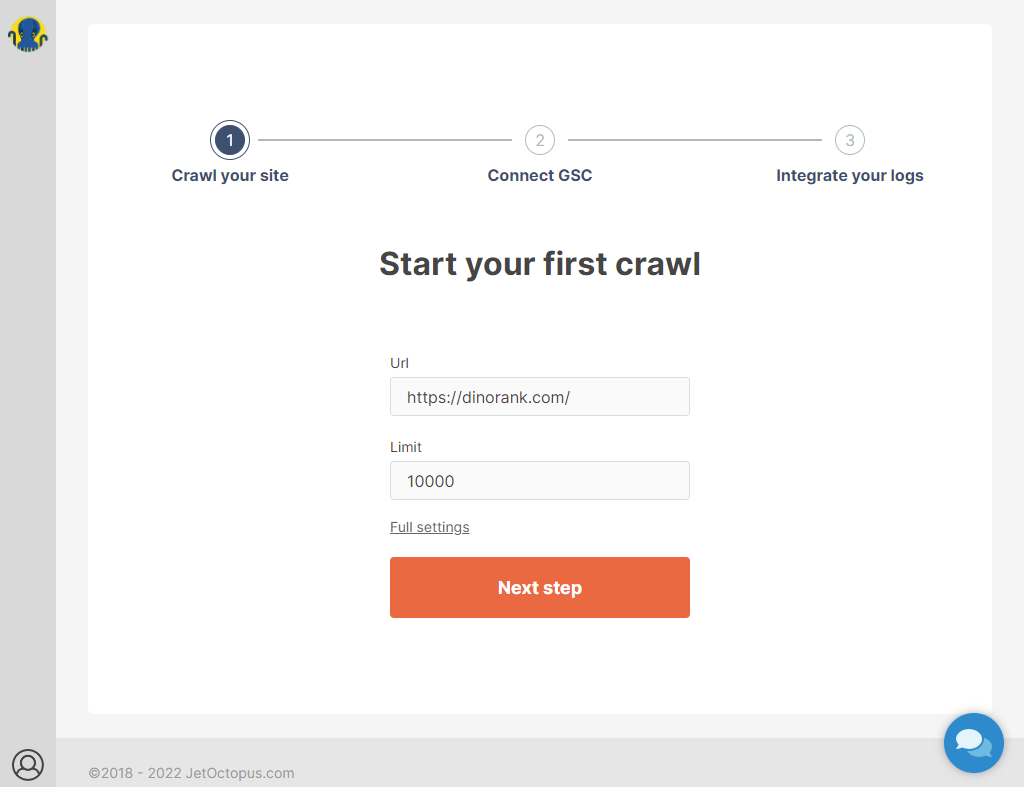

Nada más crear tu cuenta en JetOctopus e iniciar sesión por primera vez verás la pantalla de bienvenida, donde se te invita a crear un nuevo proyecto.

Para mostrar las funcionalidades de esta herramienta voy a configurar un proyecto con la web de DinoRANK.

Como ves, el asistente de configuración es muy sencillo. En la primera pantalla sólo tiene dos campos para completar con tus datos:

- Url: se trata de la URL de tu sitio web. El crawler tomará esa ruta como página inicial e irá siguiendo todos los enlaces que encuentre hasta encontrar todas las páginas de tu web.

- Limit: es el número de páginas que recopilará como máximo el crawler. Ten en cuenta que, en función de tu plan, JetOctopus tiene un límite de URLs con las que trabajar al mes. Es muy alto, pero mejor no sobrepasarlo. Con este parámetro puedes mantener tu cuota bajo control.

Con tan solo esta información, ya puedes tener tu crawler configurado.

Pero, como yo no soy muy amigo de las opciones por defecto y prefiero controlar todos los aspectos de la aplicación, siempre me voy a la configuración avanzada (Full settings, justo encima del botón para pasar al siguiente paso).

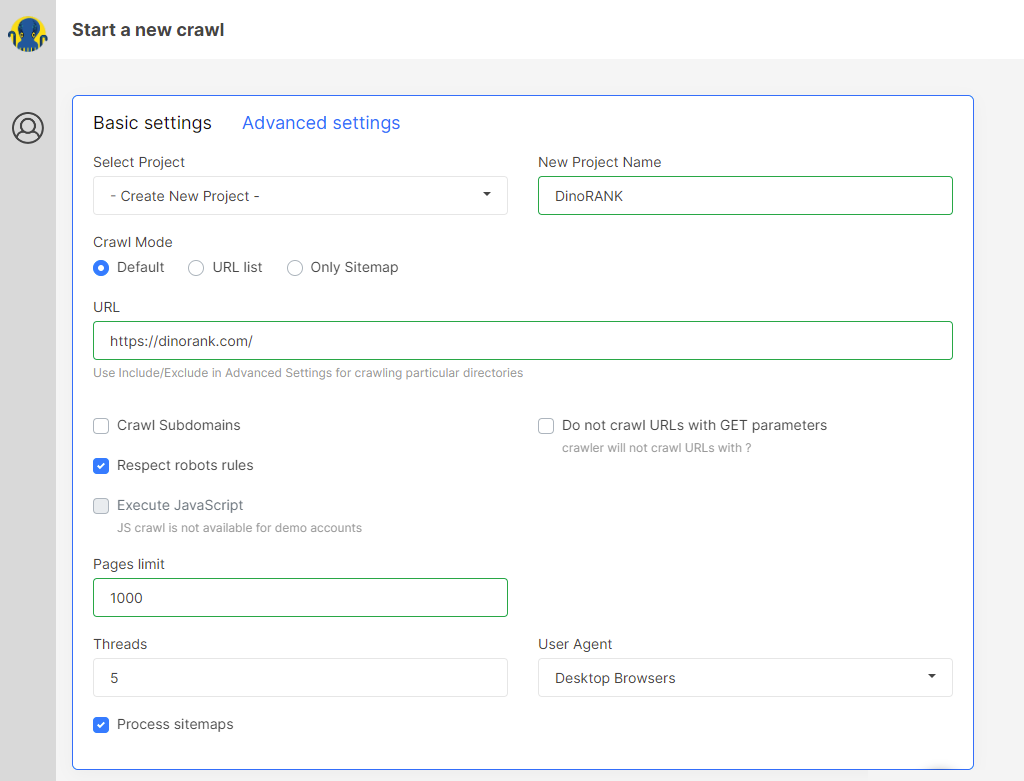

La primera parte de la pantalla, además de permitirnos configurar aspectos básicos de nuestro crawler, tales como el nombre del proyecto, la URL o el límite de páginas, nos ofrece las siguientes opciones:

- Crawl Mode: aquí podemos indicar si queremos que el funcionamiento del crawler sea el que tiene por defecto, si únicamente deseamos que recorra una lista de URLs o si sólo debe procesar las páginas del sitemap.

- Crawl subdomains: si nuestro sitio web tiene subdominios y queremos que el crawler los procese, debemos marcar esta opción.

- Respect robot rules: el crawler se comportará igual que un robot de búsqueda. Por ejemplo, no seguirá los enlaces nofollow y tendrá en cuenta las directivas del fichero robots.txt.

- Execute JavaScript: con esta opción le indicamos al crawler que interprete el JavaScript de las páginas.

- Do not crawl URLs with GET parameters: los enlaces a páginas con parámetros GET (por ejemplo, los resultados de la búsqueda en WordPress) serán ignorados.

- Threads: es el número de peticiones simultáneas que JetOctopus puede realizar. Cuanto mayor sea esta cifra, más rápido será el proceso de rastreo. Pero ten cuidado, ya que también puedes sobrecargar tu servidor. Por eso, salvo que tengas una web de varios miles de URL y un servidor potente, no te recomiendo poner aquí una cifra muy elevada.

- User Agent: este parámetro indica cómo se va a identificar el crawler frente a nuestro servidor. En función del tipo de identificación, nuestro servidor puede responder de una manera u otra, incluso denegarle el acceso. Puedes elegir entre hacerlo como si fueras un navegador de escritorio, un navegador de móvil, el propio GoogleBot o el robot de JetOctopus.

- Process sitemaps: si esta opción está marcada, el crawler, una vez procesado todo el sitio, recorrerá las URL declaradas en los sitemap.

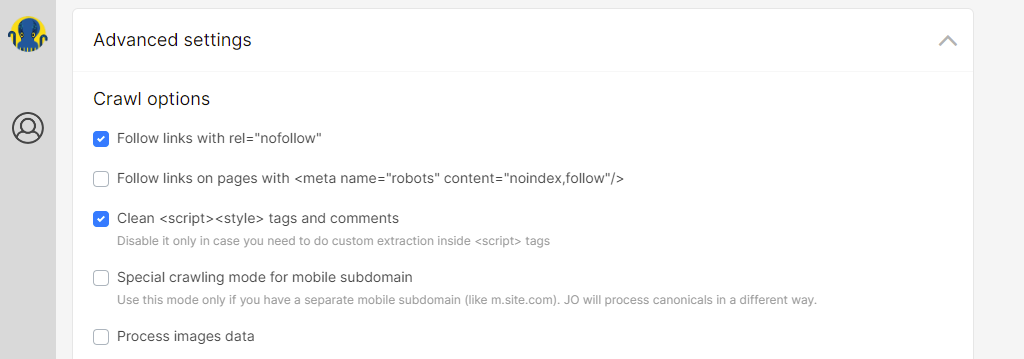

La segunda parte de la página contiene las opciones de configuración avanzada, donde puedes indicar si deseas que el crawler siga los enlaces nofollow, los enlaces contenidos en páginas noindex, que no considere determinados elementos de tu html, que dé un tratamiento especial a los subdominios de la versión móvil o que procese las imágenes.

Además, te permite controlar el comportamientos del crawler mediante las siguientes secciones:

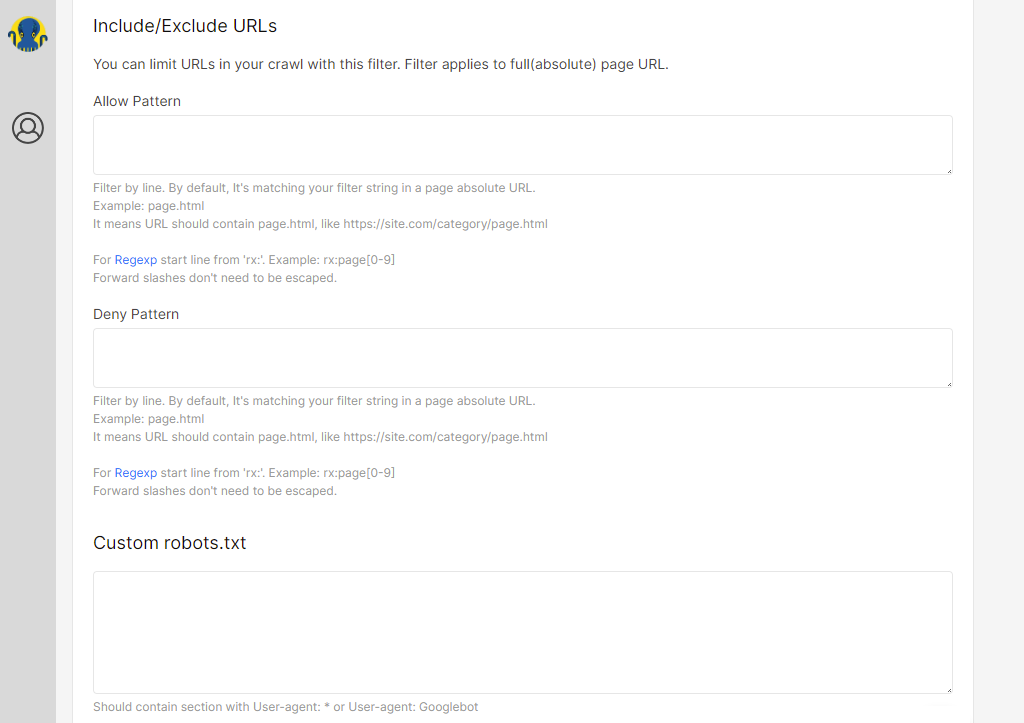

- Include/Exclude URL: puedes utilizar expresiones regulares para definir patrones que deberán cumplir tus URL para que sean procesadas por el crawler o para evitar que lo sean.

- Custom robots.txt: te permite definir el contenido de un fichero robots.txt diferente al de tu servidor.

- Strip GET params: muchas veces los parámetros GET de una URL no implican que la página muestre un resultado diferente. Sin embargo, el crawler podría considerarlas como dos URL distintas. Para evitarlo, en esta sección podemos enumerar la lista de parámetros que deben ser eliminados durante el proceso de rastreo.

- Sitemaps: para especificar la lista de sitemaps de nuestro sitio web.

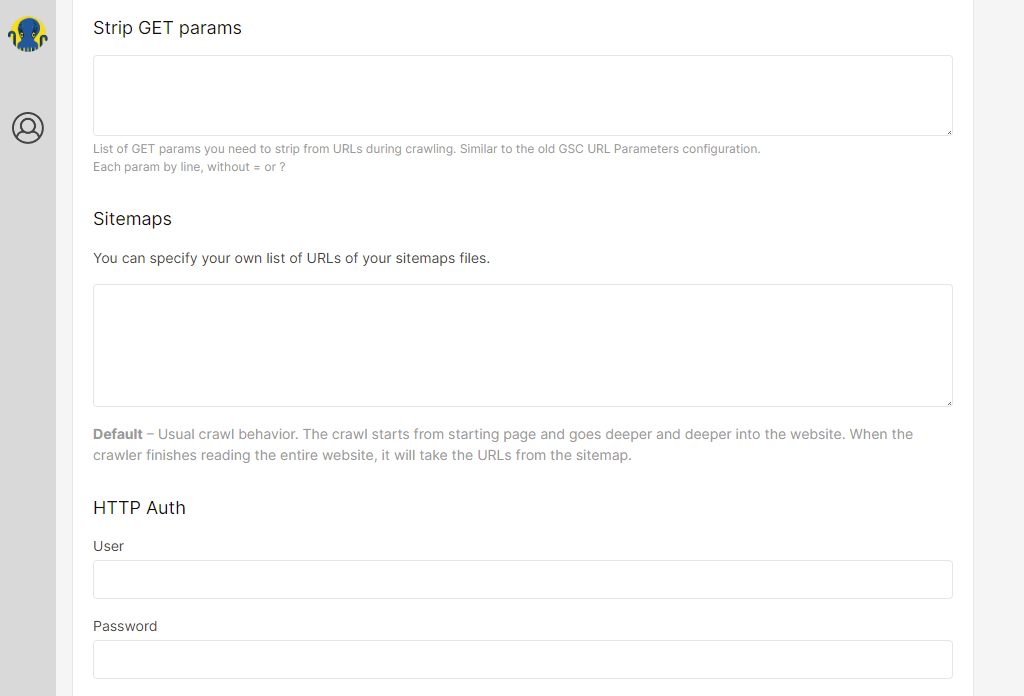

- HTTP Auth: si tu web es privada y necesita autenticación, aquí podemos configurarlo.

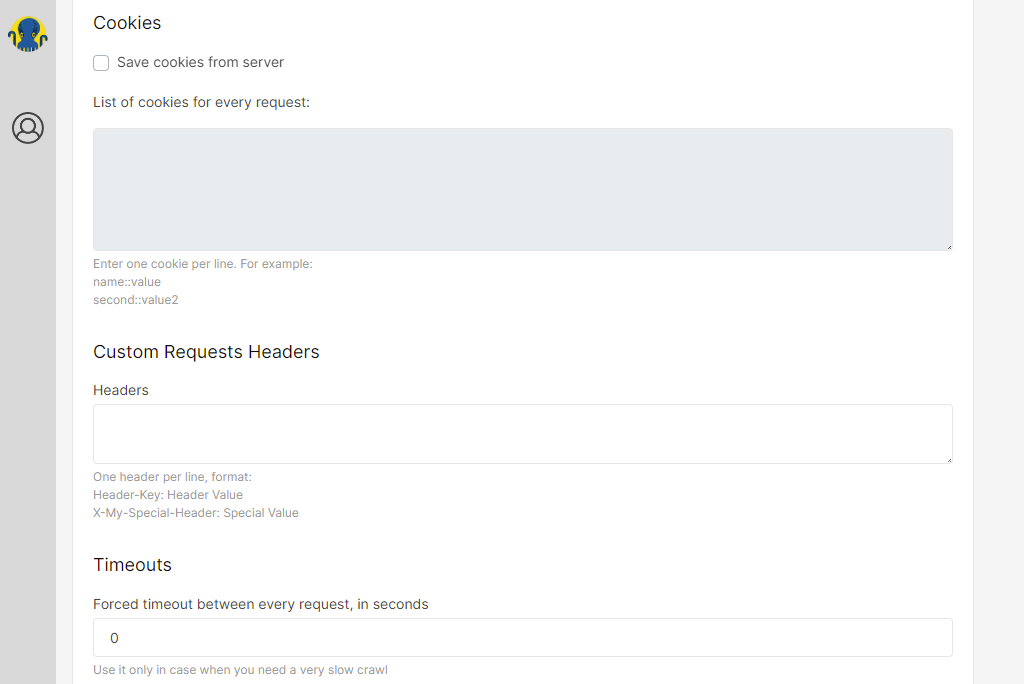

- Cookies: el crawler por defecto no almacena cookies. Si nuestra web tiene algún comportamiento especial que exige el uso de cookies, podemos listarlas mediante esta opción.

- Custom Request Header: a veces los administradores de los sitios web exigen ciertas configuraciones en las cabeceras de la peticiones HTTP para permitir el acceso. Con esta opción podemos darle forma.

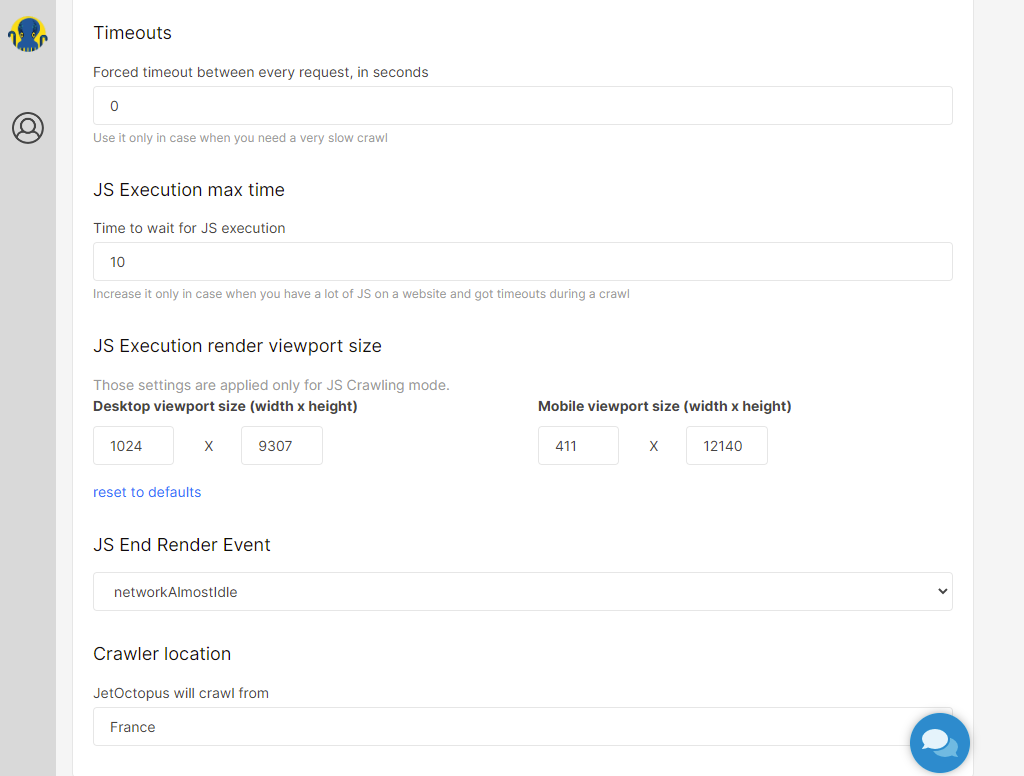

- Timeouts: si tu servidor tiene problemas para atender el volumen de solicitudes del crawler, con este parámetro podemos configurar el retraso entre una petición y otra.

- JS Settings: bajo esta opción tenemos varios parámetros acerca del procesamiento JavaScript de las páginas: tiempo máximo de espera para la ejecución del JavaScript, tamaño de ventana gráfica para escritorio/móvil y el evento que indica que una página en JavaScript ha terminado de renderizarse.

- Crawler location: este campo te permite elegir el país de origen de las peticiones del crawler. Por ejemplo, para comprobar el funcionamiento de sitios multilingües.

A continuación, si lo deseamos, podemos enlazar nuestra cuenta de Google Search Console.

La última sección también es opcional, pero muy interesante.

Te ofrece la posibilidad de definir campos personalizados, que el crawler extraerá de las páginas de tu web.

Resulta muy útil, por ejemplo, si tenemos un e-commerce y queremos obtener datos básicos de las fichas de cada producto, como el precio, la marca o la disponibilidad.

De este modo, podremos posteriormente combinar estos datos con el resto de información recopilada por JetOctopus y realizar así análisis más detallados. Por ejemplo, para mejorar la visibilidad de los productos más importantes o reducir el stock de los menos relevantes.

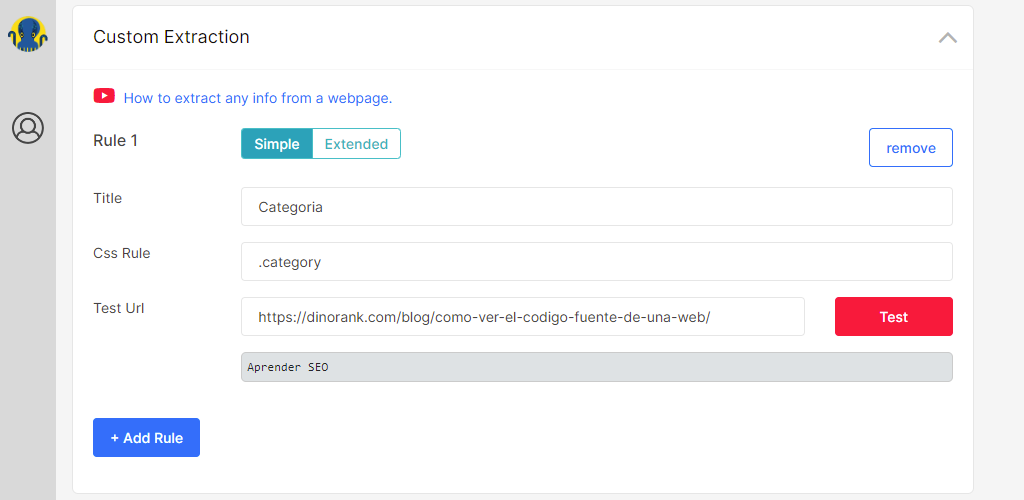

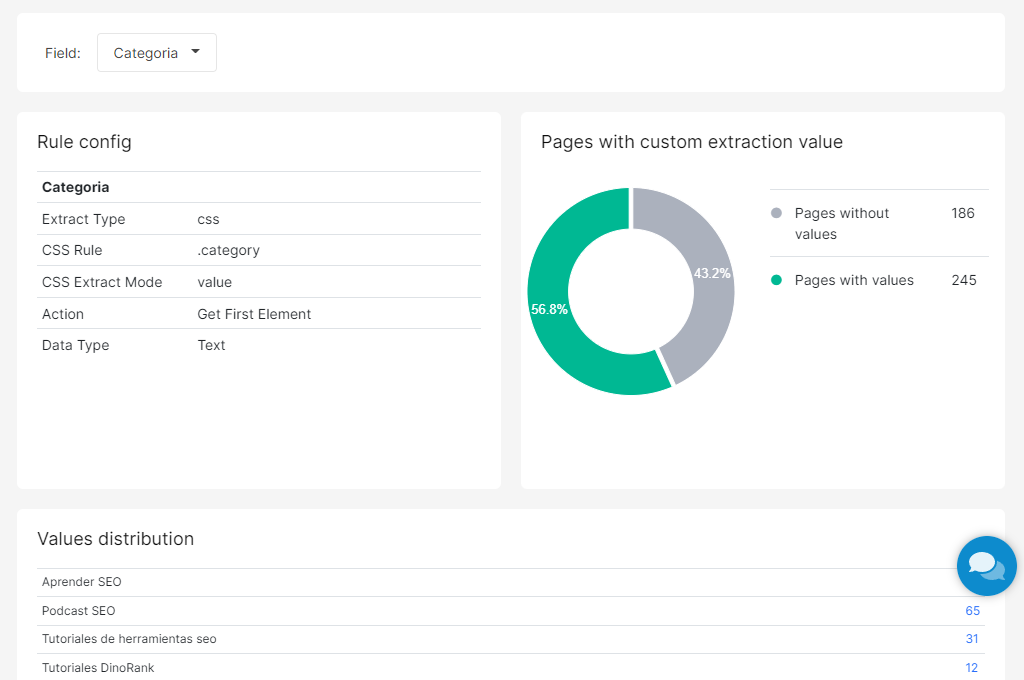

En el caso de DinoRANK voy a crear dos campos personalizados.

El primero se trata de la categoría de las páginas del blog.

La configuración, como se muestra en la siguiente imagen, es sencilla. Basta con indicarle que seleccione el valor de una clase CSS.

Para comprobar que funciona, podemos introducir una URL de nuestra web, pulsar el botón de Test y observar el resultado.

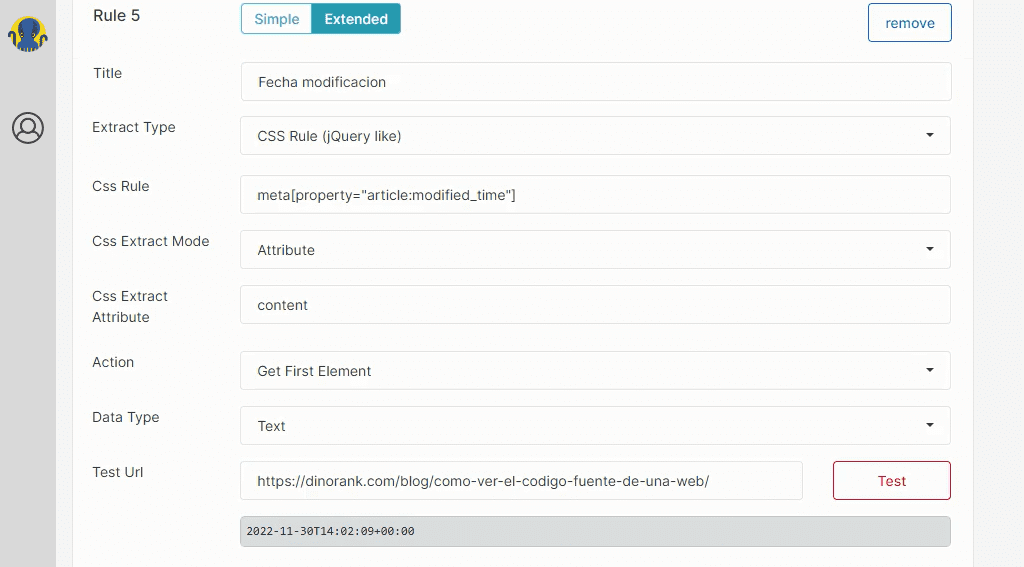

El segundo campo personalizado que quiero extraer es la fecha de modificación de las páginas.

En este caso, la regla es más avanzada y hay que desplegar las opciones extendidas para completarla. Quedará del siguiente modo:

Una vez configurado todo, sólo nos queda dar un título a nuestro crawler y pulsar el botón Start Crawl.

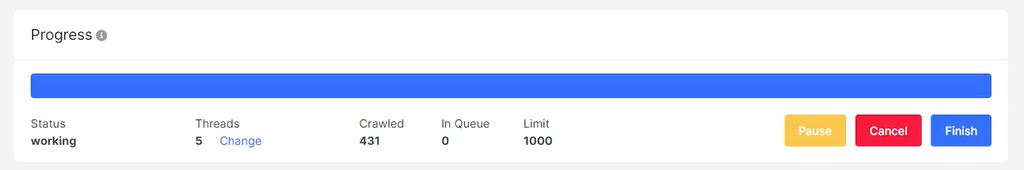

En ese momento, empezará el proceso de rastreo.

Si tu web es pequeña, no tendrás que esperar mucho a que termine.

Para que te hagas una idea, la web de DinoRANK, que tiene unas 450 páginas, la procesó en menos de 1 minuto.

Ahora bien, si tu web es muy grande, o no quieres esperar, puedes cambiar de tarea. JetOctopus te enviará un email cuando haya terminado.

De esta manera, habrás realizado el primer crawling de tu web y ya puedes empezar a analizar los resultados.

A continuación te mostraré toda la información que tienes a tu disposición.

Pero antes, vamos a dedicar unas líneas a ver cómo está estructurada la herramienta, para que te resulte más sencillo encontrar todo lo que necesitas.

Un vistazo a la interfaz de JetOctopus

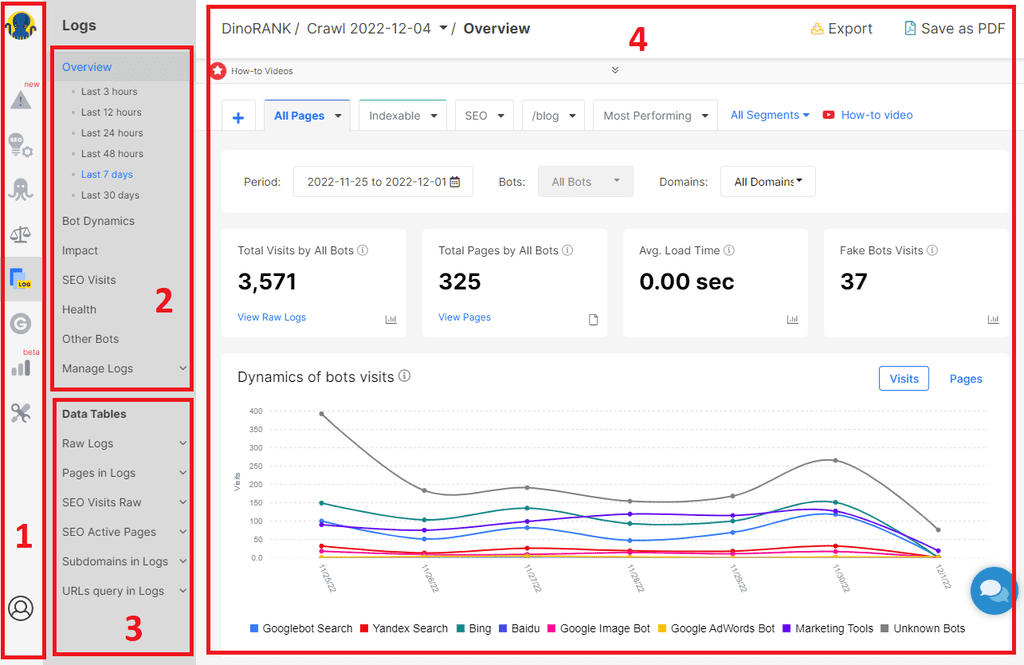

Cuando abres tu primer proyecto en JetOctopus, es posible que la cantidad de información que encuentras te parezca abrumadora.

No te preocupes. Como verás a continuación, todo está perfectamente organizado y, una vez te acostumbras a la disposición de sus elementos, te resultará muy sencillo localizar cualquier dato que necesites.

Pero, para ello, lo primero es entender cómo se estructuran exactamente las secciones de la herramienta.

En la siguiente captura puedes ver marcadas las cuatro zonas principales en las que se pueden dividir la mayoría de páginas en JetOctopus.

La primera zona es la barra de módulos. Aquí puedes encontrar cada una de las utilidades principales de la aplicación. Estos módulos los explicaré en detalle más adelante.

La sección marcada con el número 2 es una zona de menú que permite acceder a los informes visuales de cada uno de los módulos.

Cada módulo tiene una serie de apartados en los que se realiza un análisis de los datos recopilados, bajo una perspectiva determinada.

Aquí encontrarás gráficas, listados de problemas, comparativas y mucho más.

Justo debajo, en el mismo menú lateral, está la zona etiquetada con el número 3.

Los elementos de esta zona del menú dan acceso a las tablas con todos los datos recolectados.

Por último, el espacio más importante y que ocupa la mayor parte de la pantalla, es el identificado con el número 4. Aquí podrás ver todos los informes gráficos y tablas que selecciones a través de los menús anteriores.

Trabajando con segmentos

Si alguna vez te has enfrentado a una tarea compleja sabrás que no suele ser buena idea abordarla de una sola vez.

Estarás de acuerdo conmigo en que es mucho más sencillo y productivo dividir el problema en subtareas más pequeñas y poner el foco en resolver cada una de ellas por separado.

Los desarrolladores de JetOctopus tienen claro que éste es el camino correcto e introducen un concepto que te ayudará a centrarte en aquellas partes de tu web que pueden tener más interés.

Son los segmentos.

Imagina que tienes una web con miles de URLs.

¿Todas tienen la misma importancia?

Seguramente no.

Gracias a los segmentos, puedes definir cuáles son las páginas con una mayor relevancia y analizarlas conjuntamente. Así conseguirás centrarte en arreglar en primer lugar cualquier problema relacionado con ellas antes de pasar a analizar otras URLs.

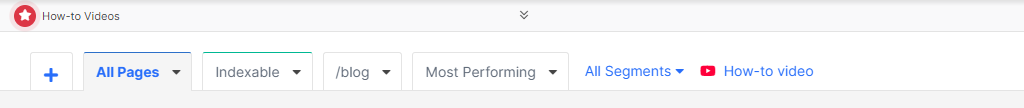

Los segmentos en JetOctopus se muestran en pestañas en la parte superior.

Tienes unos segmentos preconfigurados por defecto (todas las páginas, sólo las indexables, las de mayor rendimiento en GSC, las del blog, etc), pero también puedes crear los tuyos propios.

Los criterios para crear un nuevo segmento pueden ser muy simples o muy complejos.Todo depende de cuáles sean tus necesidades.

Más adelante te comento un poco más en detalle cómo puedes hacer para añadir nuevos segmentos a tu panel.

Una vez explicada la organización de JetOctopus es hora de ver uno a uno todos los módulos de la herramienta.

Empezamos por el más importante: el crawler.

Módulo Crawler

Ya te he comentado todo lo que debes considerar a la hora de configurar tu crawler en JetOctopus.

Ahora vamos a ver los resultados.

A continuación te mostraré todas las secciones de este completo módulo.

Visión general

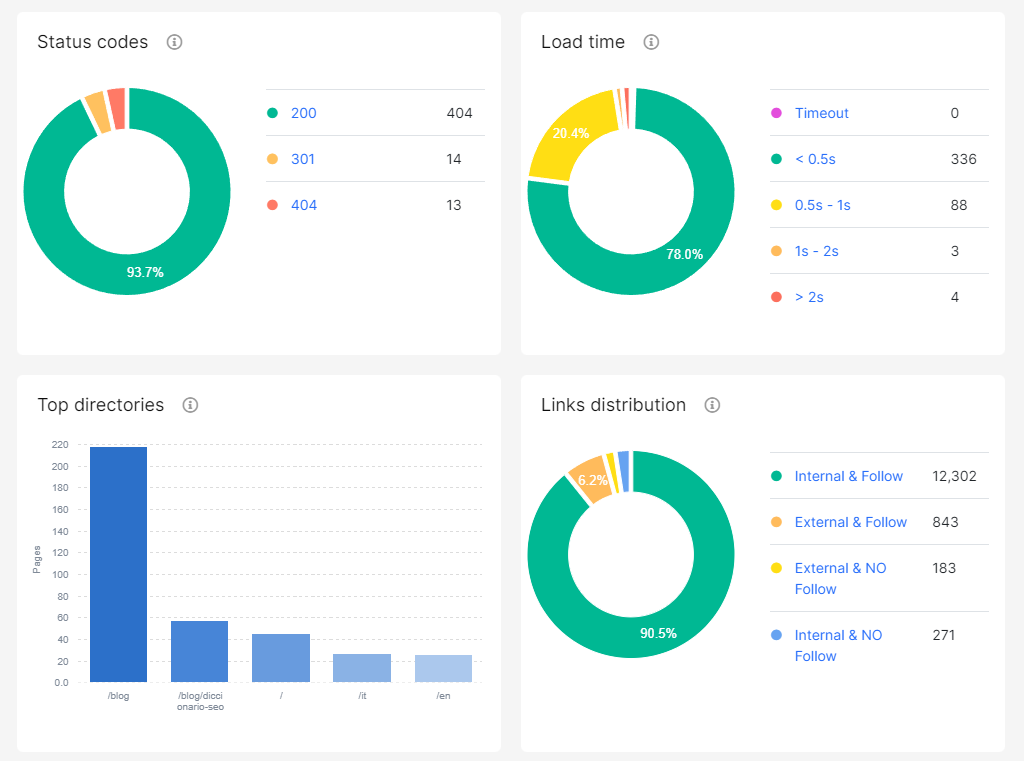

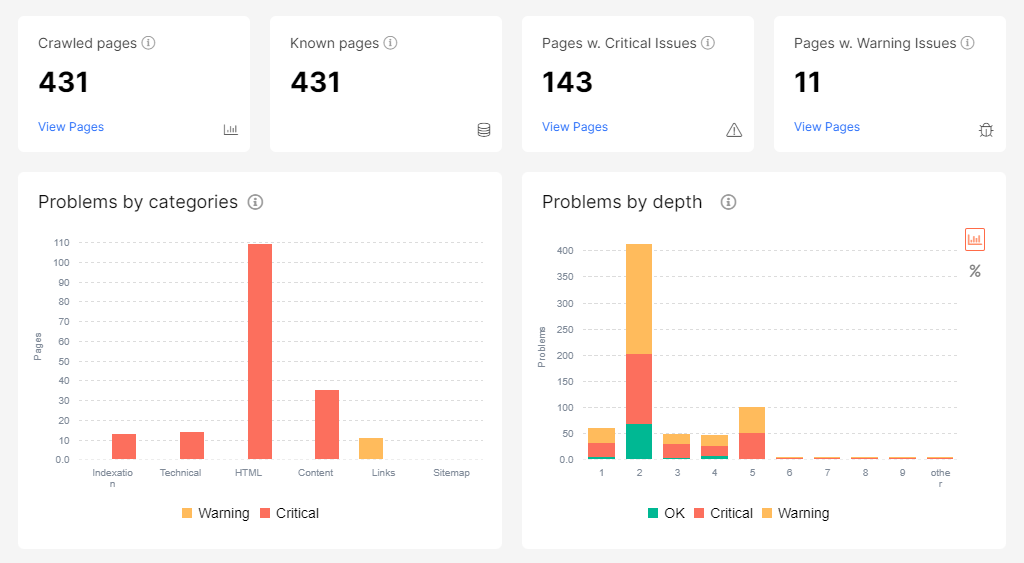

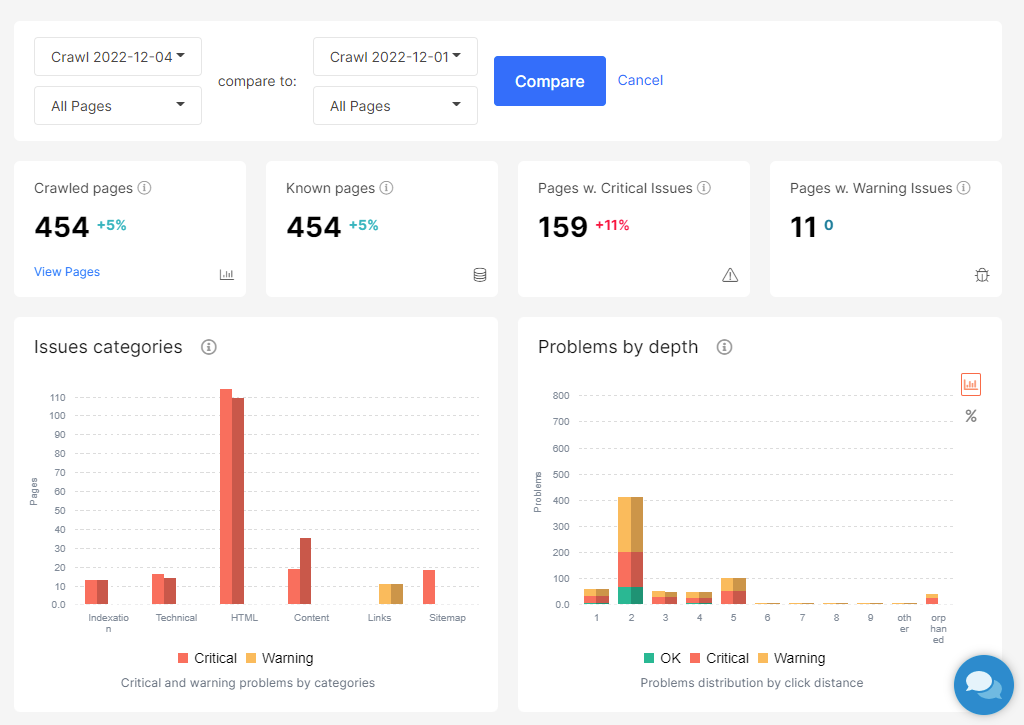

La página Overview te ofrece un resumen de todos los datos recopilados por el crawler.

Con un rápido vistazo, ya puedes hacerte una idea de la salud de tu sitio web.

En la parte superior puedes ver las principales estadísticas, en forma de cantidad de páginas recolectadas, páginas conocidas, número de páginas con errores y número de páginas con avisos.

Debajo de las estadísticas tienes un conjunto de gráficas que te muestran:

- Clasificación de los problemas por categorías.

- Proporción de páginas marcadas como Index frente a noIndex.

- Códigos de respuesta del servidor. Presta especial atención a los errores 404.

- Tiempos de carga.

- Distribución de las páginas en directorios. Si tienes muchas páginas dentro del blog no supone ningún problema. Ahora bien, si tienes un directorio por idioma y en alguno de ellos hay más páginas que en otros, te podría estar indicando que se te ha olvidado algo.

- Links: Ten especial cuidado con los enlaces internos marcados como nofollow.

La mayor parte de los gráficos son navegables y te llevan a las tablas de datos correspondientes, para que puedas ver la información de manera más detallada.

Verás que para muchas estadísticas, JetOctopus muestra una gráfica con el nivel de profundidad.

Se trata de la distancia a la que una página se encuentra de la URL definida como raíz (Distance from Index, DFI), en base al número de enlaces que debe recorrer para llegar a ella.

Se supone que cuanto más importante es una página más cerca debe estar de la raíz.

Esta representación de los datos nos permite analizar mejor los problemas de nuestra web y focalizarnos en las páginas más relevantes.

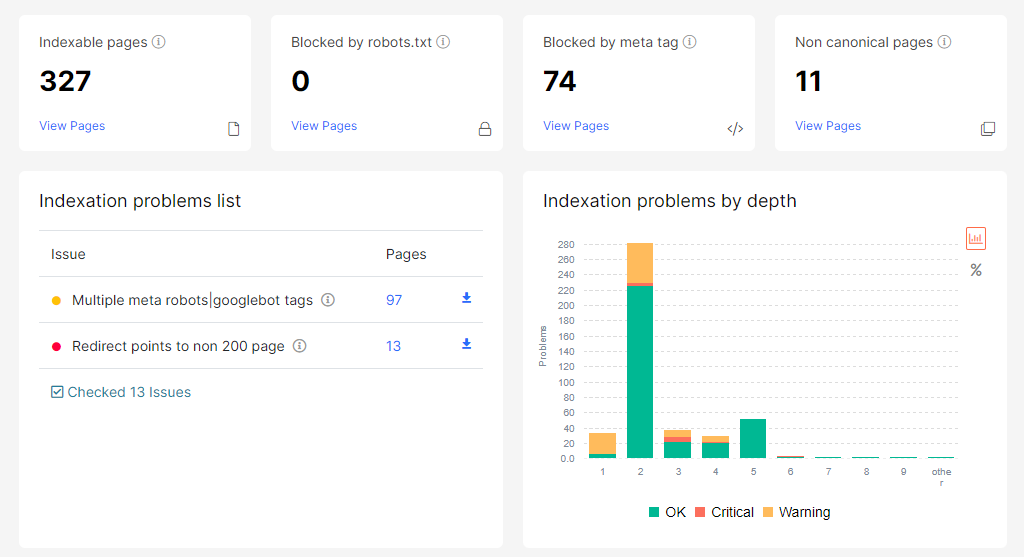

Indexación

En esta sección puedes observar todos los errores que JetOctopus ha identificado relacionados con la indexación de nuestra web.

Además se muestran las siguientes gráficas:

- Páginas indexables o bloqueadas por algún motivo.

- Distribución de etiquetas follow y etiquetas index.

- Uso de etiquetas especiales de meta-robots (nosnippet, noarchive, notranslate, noimageindex).

- Páginas canónicas, con multi-idioma, con paginación y con versión alternativa para dispositivos móviles.

Rendimiento de JavaScript

Si en la configuración del crawler has marcado la opción para ejecutar el JavaScript de las páginas, entonces podrás analizar los resultados a través de este panel.

La sección de rendimiento del JS muestra en la parte superior un resumen con las métricas principales:

- First Paint: tiempo medio que ha costado mostrar el primer píxel en pantalla del conjunto de las peticiones.

- First Contentful Paint: tiempo medio que transcurre hasta recuperar un elemento completo (bloques de texto, imagen, etc) en el conjunto de las solicitudes del crawler.

- Page Loaded: tiempo medio que cuesta que todos los elementos de la página estén visibles.

- All Requests Completed: tiempo medio que cuesta cargar la página. Es decir, puede que la página sea visible para el usuario y pueda interactuar con ella (Page Loaded), pero todavía haya algún proceso JavaScript en ejecución.

Justo debajo, aparecen dos gráficas:

- Una agrupación de las páginas de la web en función de sus tiempos de carga de las páginas.

- Una distribución de la duración de los principales eventos de JavaScript.

Por último, tenemos un informe con los errores de JavaScript que ha recibido el crawler, junto con las páginas que los han provocado. De este modo, podemos depurar todos los comportamientos no deseados.

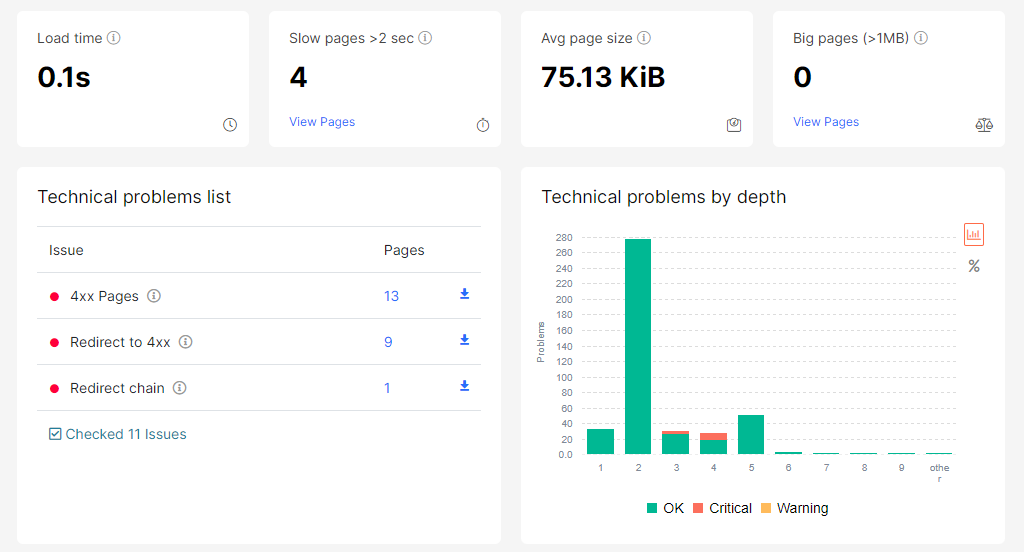

Análisis de aspectos técnicos

La sección de aspectos técnicos del crawler se divide a su vez en dos subsecciones: tiempos de carga y estados de respuesta.

En el panel de los tiempos de carga se nos muestran los errores detectados en nuestra web.

Gracias a este listado de errores, podemos ver que en la web de DinoRANK hay enlaces a páginas que no existen, enlaces a páginas que redireccionan a otras que no existen o cadenas de redirecciones (A lleva B, B lleva a C, y así varias veces).

Además de la enumeración de problemas detectados, la herramienta nos muestra un conjunto de gráficas, donde podemos ver:

- Tiempos de carga.

- Tiempos de carga agrupados por códigos de respuesta.

- Tiempos de carga agrupados por idiomas de las páginas.

- Distribución de tamaños de páginas

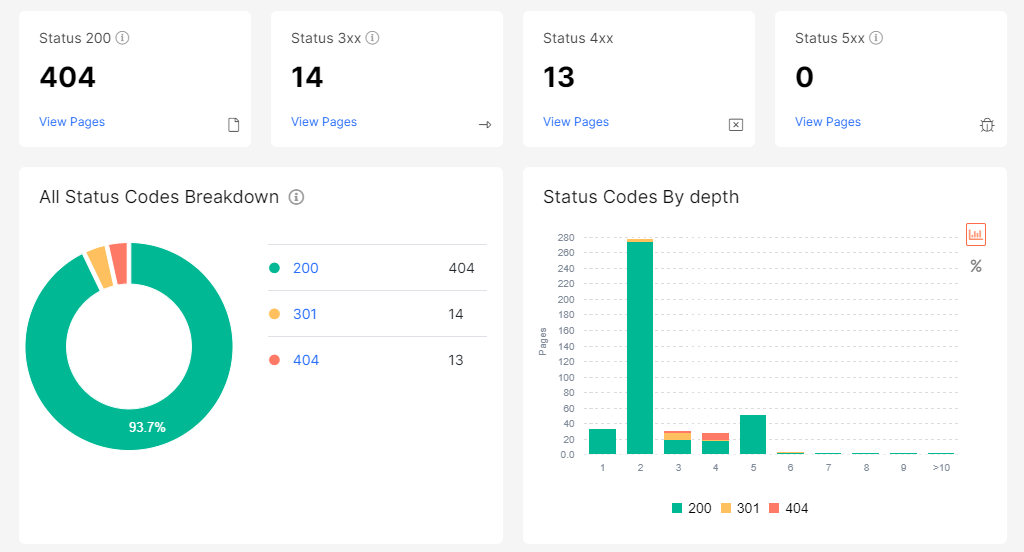

En cuanto al panel de los estados de respuesta, nos muestra la distribución de los diferentes códigos y nos permite acceder al listado concreto de páginas por cada estado recibido.

Análisis de duplicados

Si nuestro objetivo es que los motores de búsqueda concedan a nuestras páginas la relevancia que merecen, no podemos quedarnos sólo en analizar aspectos técnicos. Tenemos que cuidar su contenido.

El crawler de JetOctopus nos ayuda a realizar parte de este trabajo, gracias a la identificación de elementos duplicados, que pueden estar restando importancia a nuestras URLs.

Ojo, no todos los elementos duplicados tienen por qué estar mal.

Lo que sí es importante es conocer cuáles son y decidir si se ajustan o no a la estrategia de nuestra web.

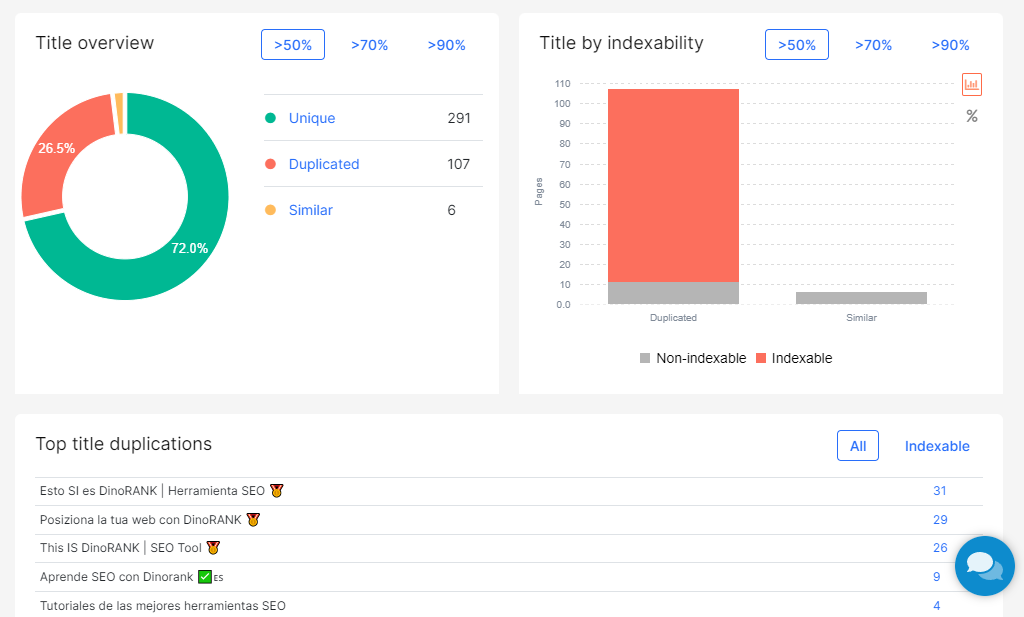

La sección de análisis de duplicados tiene un panel general (Overview) y paneles específicos para cada uno de los elementos anteriores.

En el primero de los paneles podemos ver un resumen de estadísticas sobre elementos duplicados, un listado de problemas y gráficas con la visión sintetizada de las duplicidades encontradas.

En los paneles específicos de cada elemento veremos:

- Agrupaciones de las URLs en función de la similitud de contenidos.

- Distribución en base a la indexabilidad de las páginas con duplicados.

- Listado con las principales duplicidades.

Análisis del contenido

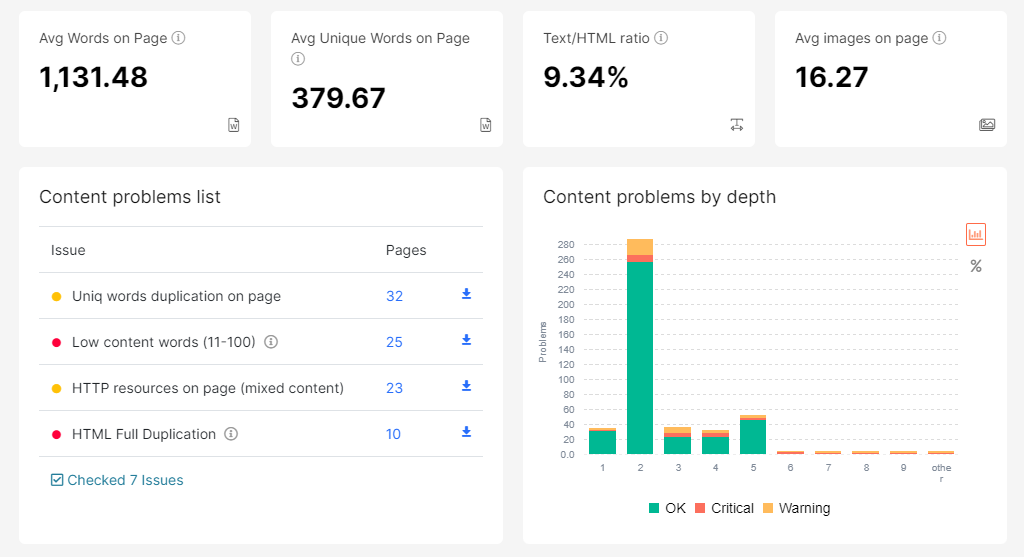

Seguimos con el análisis de contenido.

Una vez revisados los duplicados, el crawler hace una revisión de los elementos que encuentra en la página, en cuanto a su cantidad y diversidad.

No obstante, tener a mano ciertas métricas te pueden ayudar a definirlo y evaluarlo.

La sección de análisis de contenido nos da acceso a 3 informes diferentes.

El primero de ellos (Content) es el más general de todos. Nos ofrece un listado de problemas detectados y gráficas donde podemos ver las páginas agrupadas por número de palabras, la proporción entre texto y resto de elementos HTML o la cantidad de URLs que referencian a recursos HTTP (no seguros).

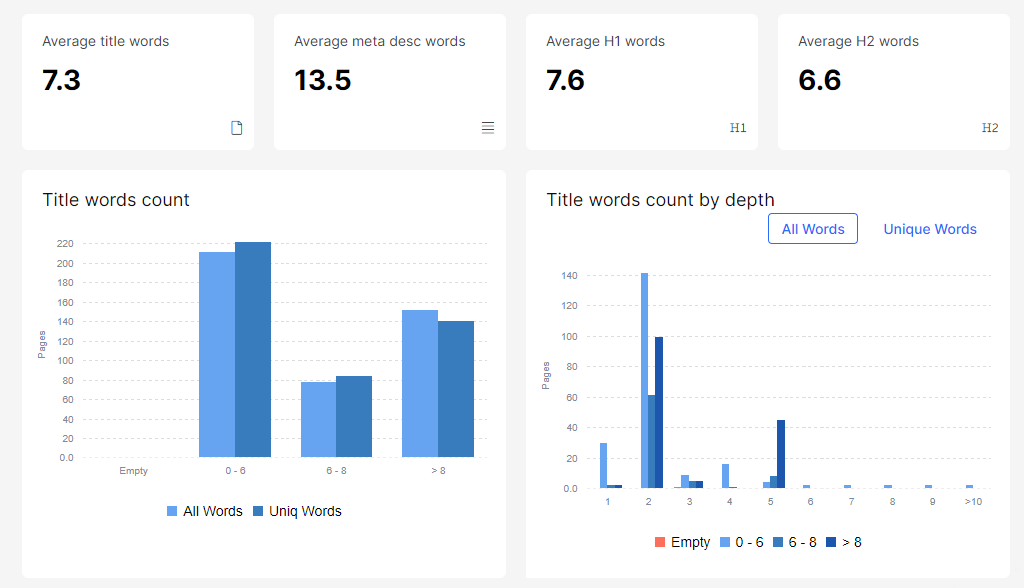

El segundo informe (Words) nos permite observar de forma muy gráfica la cantidad de palabras que podemos encontrar en títulos, meta-descripciones o elementos H1 y H2.

El último informe sólo estará disponible si has marcado la opción para ejecutar JavaScript durante la configuración del crawler.

El panel JS vs HTML muestra las diferencias existentes en las páginas si se leen sólo como HTML o se ejecuta el JavaScript contenido en ellas.

Diferencias muy grandes son fuente de problemas para la indexación, ya que los robots de búsqueda podrían considerar que se está aplicando alguna técnica poco lícita en la web.

Además, JetOctopus te ofrece informes separados con aquellas páginas de tu web en las que, al ejecutar el JS, se modifican aspectos tan relevantes como etiquetas index, títulos o meta-descripciones.

Enlazado interno y externo

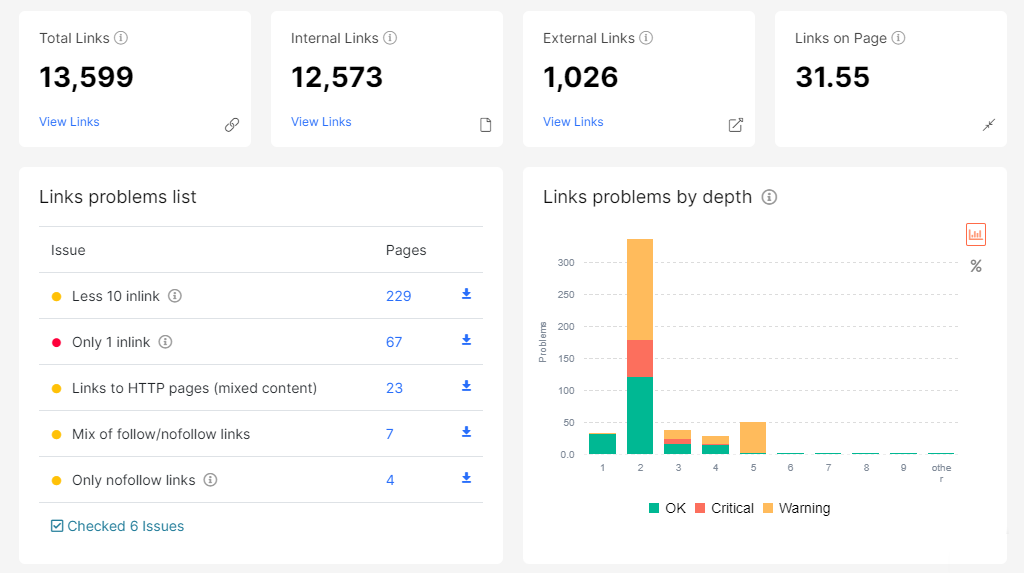

La detección y análisis de los enlaces de una web es un factor al que JetOctopus da mucha importancia.

Un buen enlazado interno es fundamental para ayudar a los robots de búsqueda a recorrer todas las páginas importantes de tu sitio web y a darles pistas sobre su contenido.

Dentro del módulo Crawler tenemos cuatro secciones dedicadas al enlazado, aunque en este post he decidido agruparlas dentro de este apartado porque están muy relacionadas entre sí.

Vamos a verlas.

Links Overview

En este panel encontramos un resumen general del enlazado de la web junto con un listado de problemas que ha identificado el crawler.

Entre los aspectos analizados, me parece muy útil conocer las páginas que sólo tienen un enlace en toda la web. Si se trata de páginas que queremos posicionar, simplemente con incrementar los enlaces internos hacia ella podría tener un efecto muy positivo.

Además, en esta sección podemos ver una serie de gráficas interesantes:

- Agrupación de páginas por número de links internos que apuntan hacia ellas.

- Media de los links que tienen las páginas en función de su profundidad.

- Media de los links internos que apuntan hacia las páginas en función de su profundidad.

- Distribución de links dentro de la web (internos, externos, social).

Internal Links

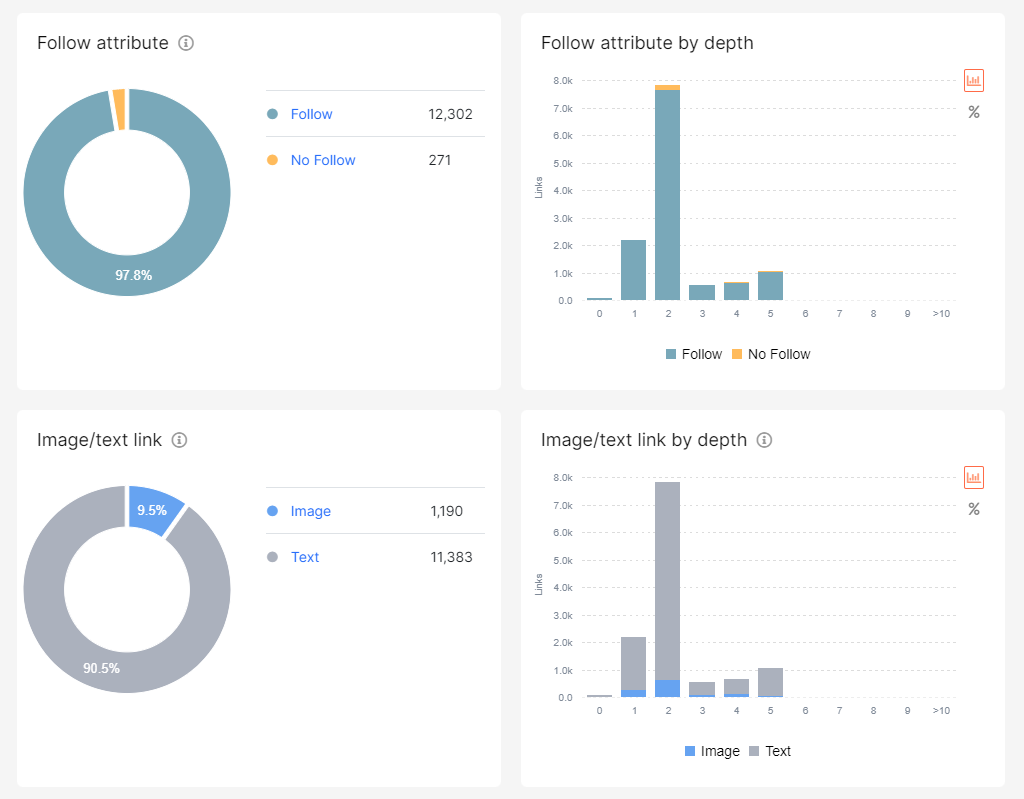

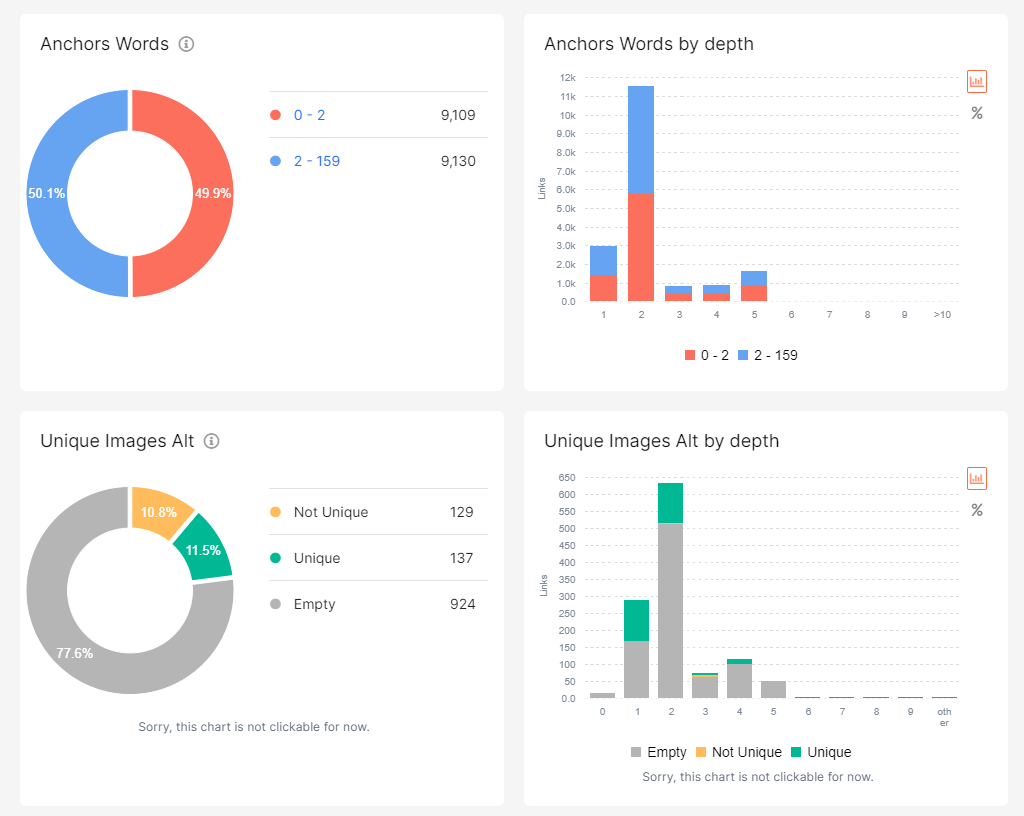

En este informe podemos ver un buen número de gráficas con la distribución de enlaces internos en función de diferentes criterios de agrupación: index o noindex, follow o nofollow, de tipo texto o imagen, etc.

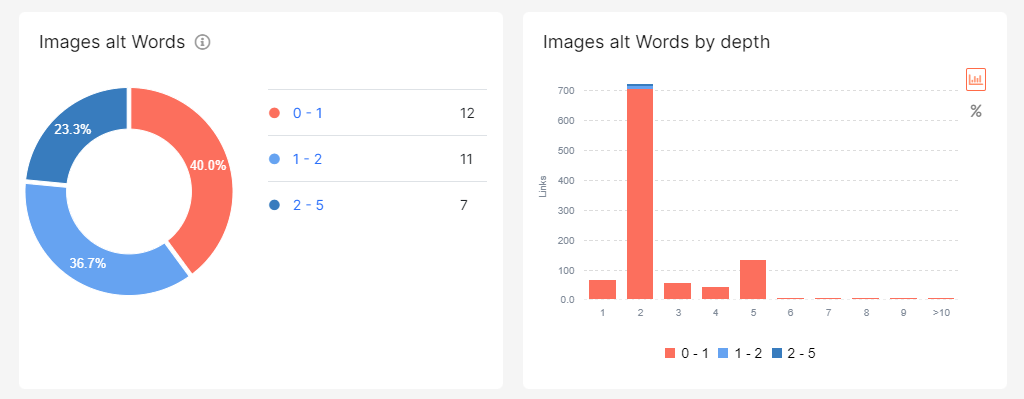

Además, esta misma sección nos ofrece otro informe con el análisis de los anchor text utilizados en los enlaces y los textos empleados en los atributos Alt de las imágenes.

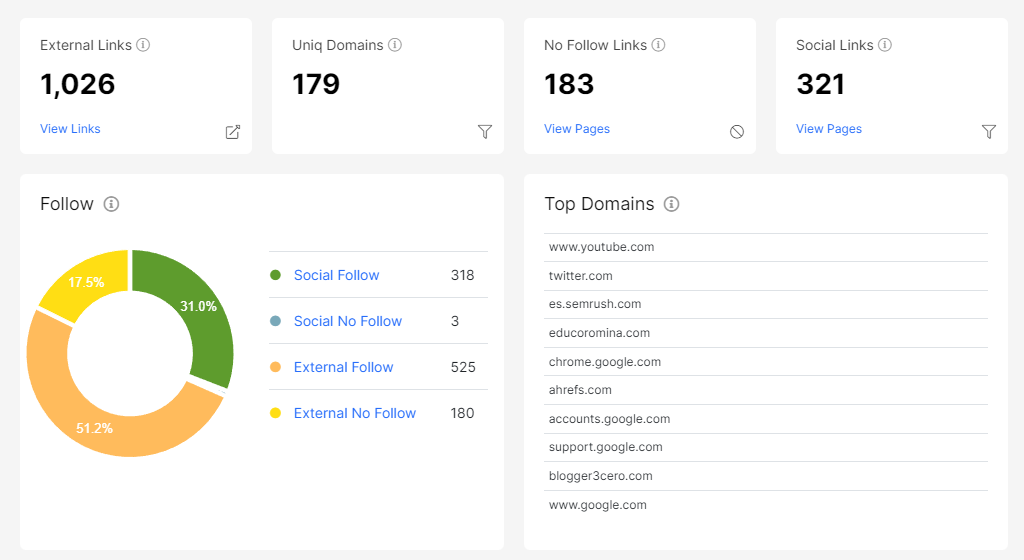

External Links

La sección relativa al enlazado externo nos permite identificar posibles problemas en los enlaces salientes de nuestra web.

Tal y como ocurre en el panel del enlazado interno, tenemos dos informes a nuestra disposición.

En el primer informe podemos observar los aspectos más técnicos de estos enlaces: uso de follow/nofollow, enlaces de tipo texto o imagen, protocolo del enlace (http, https), así como si se abren en una nueva pestaña.

En el segundo informe podremos analizar los textos utilizados en los enlaces mediantes diferentes gráficas y listados.

Revisión de ficheros sitemap

Esta sección nos ofrece información acerca de los problemas detectados al analizar las URLs de los ficheros sitemap de la web.

Entre los aspectos analizados, la herramienta resalta especialmente la existencia de páginas huérfanas (páginas que no están enlazadas desde otras páginas) y con códigos de respuesta erróneos.

Campos personalizados

Si al configurar el crawler definiste tus propios campos personalizados, en esta sección puedes encontrar toda la información que ha podido procesar.

Para cada campo tienes un panel que te muestra la regla que estableciste para su extracción, el listado de valores encontrados y las páginas que presentan dichos campos.

Opciones

El panel de opciones es bien sencillo. Simplemente te muestra la configuración que marcaste para el crawler (no se puede modificar) e incluye un botón para volver a lanzarlo si deseas.

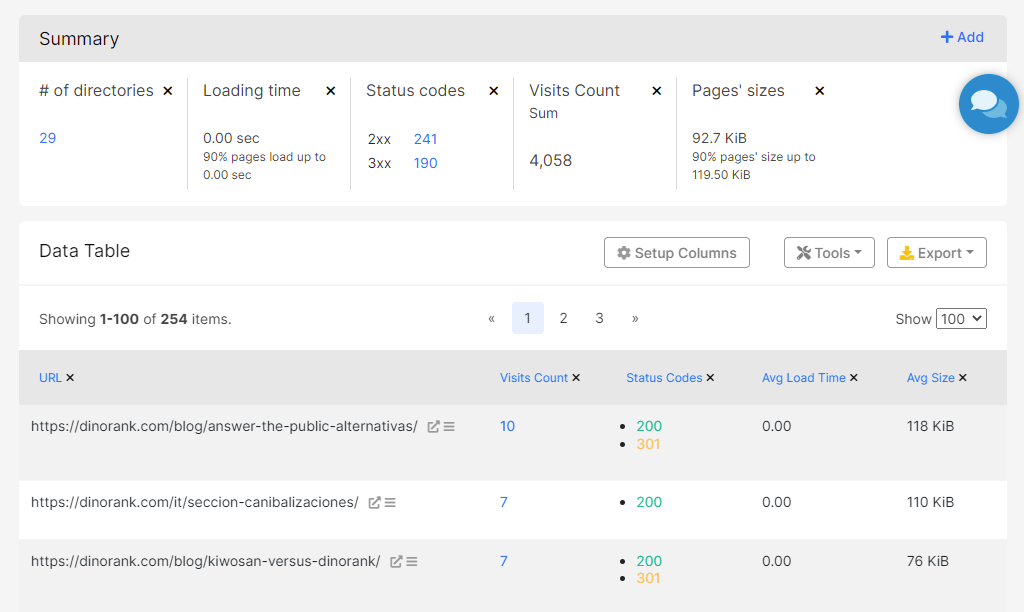

Tablas de datos

Una vez revisados todos los informes gráficos que JetOctopus ofrece en el módulo Crawler, toca hablar de la información más pura: los datos.

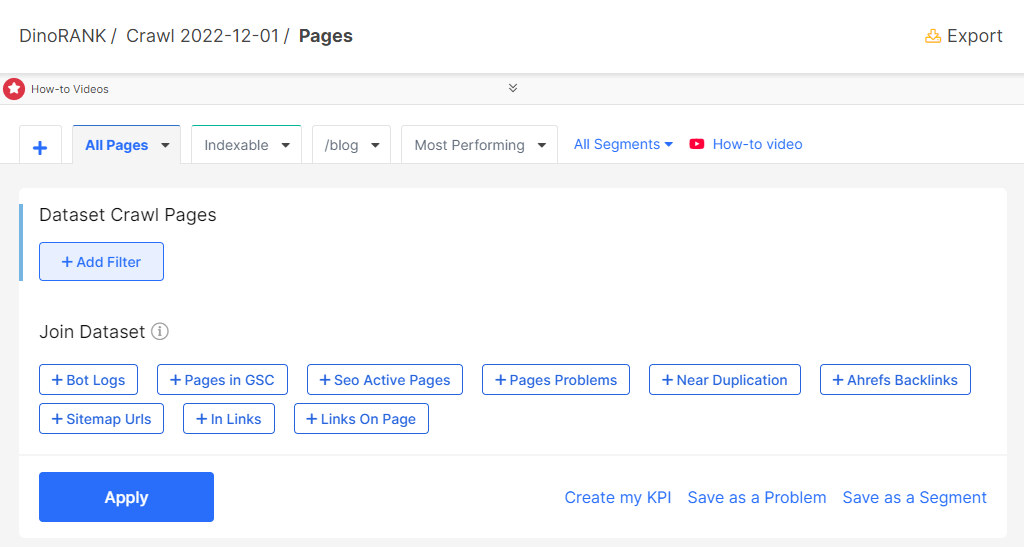

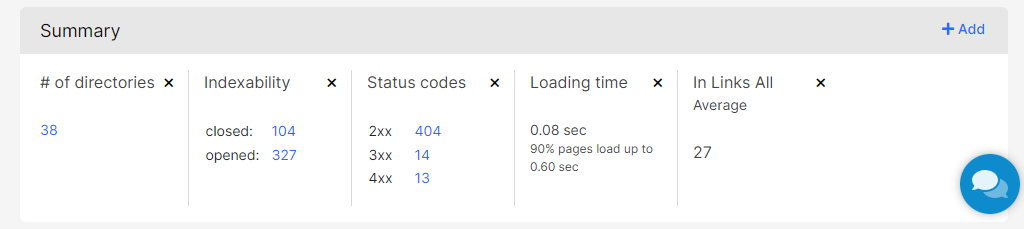

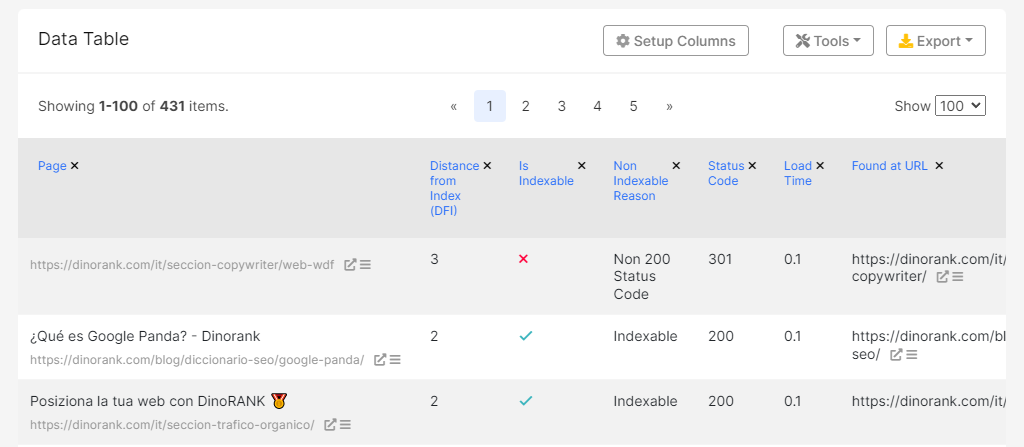

Todas las secciones de la herramienta que muestran tablas de datos tienen al menos 3 partes.

La primera parte permite definir filtros sobre los campos del conjunto de datos, para ajustar la precisión de los valores que se mostrarán en la tabla.

La segunda parte es un resumen de estadísticas relacionadas con los datos que se están visualizando.

Si quieres, puedes eliminar aquellas estadísticas que no te aporten nada. También es posible añadir otras nuevas pulsando el botón Add que está arriba a la derecha.

Por último, se encuentra la tabla de datos propiamente dicha.

Tienes la opción de añadir y quitar columnas, ordenar los valores o modificar el número de filas que se muestran por cada página.

También puedes exportar la tabla y ejecutar ciertas utilidades sobre los elementos que contiene (por ejemplo, lanzar el análisis de Core Web Vitals para todas las URL de la tabla).

Finalmente, te enumero los conjuntos de datos que incluye el módulo Crawler, para que puedas hacerte una idea de todo su potencial:

- Todas las páginas recolectadas.

- Duplicados.

- Enlaces internos.

- URLs con parámetros GET.

- Dominios enlazados.

- Imágenes (sólo si se ha marcado la opción de procesar imágenes en la configuración del crawler).

- Ficheros sitemap procesados.

- URLs en ficheros sitemap.

Módulo Log Analyzer

El módulo Crawler, que te he comentado en el anterior apartado, nos permite obtener una gran cantidad de datos acerca de cómo puede ser rastreada nuestra web.

Pero la verdadera información la tenemos en nuestro propio servidor, almacenada en un lugar al que muchas veces no prestamos demasiada atención: los ficheros de log.

JetOctopus te da la posibilidad de realizar un análisis completo de estos registros de una manera muy visual y sencilla.

Vamos a ver qué te ofrece este módulo tan particular de la herramienta.

Gestión de Logs

Aunque esta sección no está situada al comienzo del menú, creo que es conveniente hablarte de ella en primer lugar.

Desde esta opción podrás configurar el modo en el que quieres que JetOctopus recupere tus ficheros de logs.

Existen varias maneras para integrar tus registros y la elección de una u otra dependerá de cómo sea la infraestructura de tu servidor.

Así, los métodos que tienes disponibles son:

- Integración de sitios pertenecientes a Amazon Web Services.

- Lectura en tiempo real de logs en servidores con Nginx.

- Recuperación de logs de un FTP o un contenedor S3.

- Integración con CloudFlare.

- Carga manual de ficheros de log (para formatos de Apache y Nginx).

Si vas a utilizar JetOctopus de manera profesional, seguramente te merezca la pena automatizar el proceso de lectura de tus logs mediante alguna de las cuatro primeras opciones.

No obstante, en el caso de la web de DinoRANK, he decidido utilizar el último de los mecanismos, ya que lo considero más sencillo.

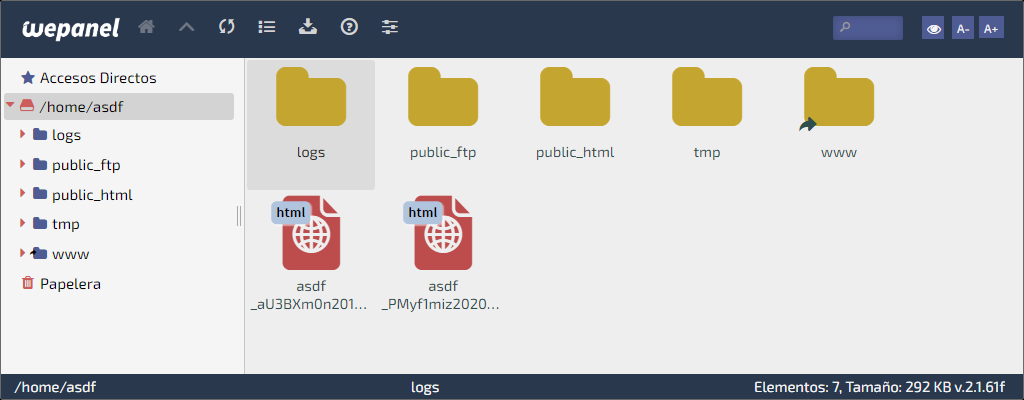

De este modo, para poder subir los ficheros a JetOctopus, lo primero es descargarlos de tu servidor.

Si tienes un hosting basado en CPanel el proceso es muy sencillo. Basta con abrir el administrador de archivos y dirigirte a la carpeta “logs” que se encuentra en la raíz.

Los ficheros suelen estar almacenados por meses y comprimidos en formato gzip. Por lo tanto, selecciona aquellos que quieras procesar, descárgalos y luego descomprímelos.

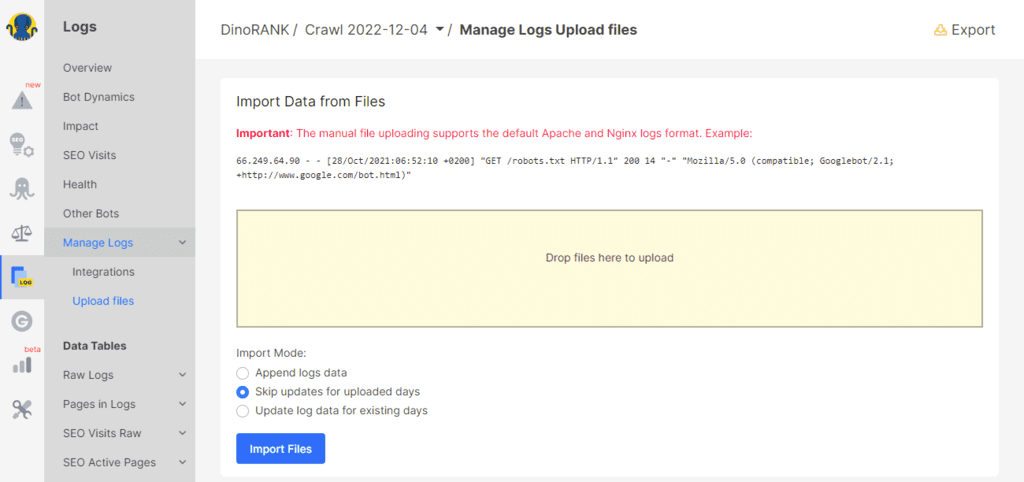

Una vez tienes los ficheros en tu poder, sólo te queda subirlos a JetOctopus.

Arrastra los logs al área de texto y selecciona el método de importación de entre los siguientes:

- Añadir la información de los ficheros a la que ya exista en JetOctopus.

- Ignorar la información de aquellos días que ya tienen información en JetOctopus.

- Actualizar la información de los días que ya tienen datos en JetOctopus.

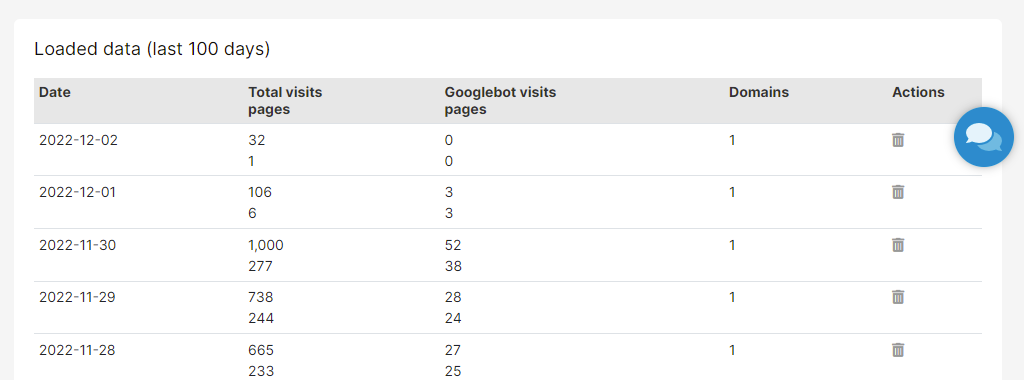

Finalmente, la herramienta procesará los ficheros y mostrará un resumen de los datos recuperados en la tabla de la parte inferior.

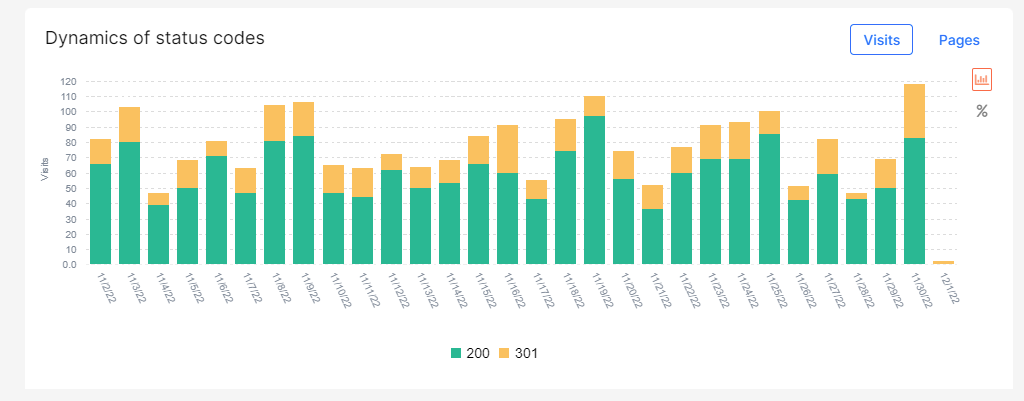

Visión general

Ahora que ya tenemos nuestros logs cargados, vamos a lo interesante.

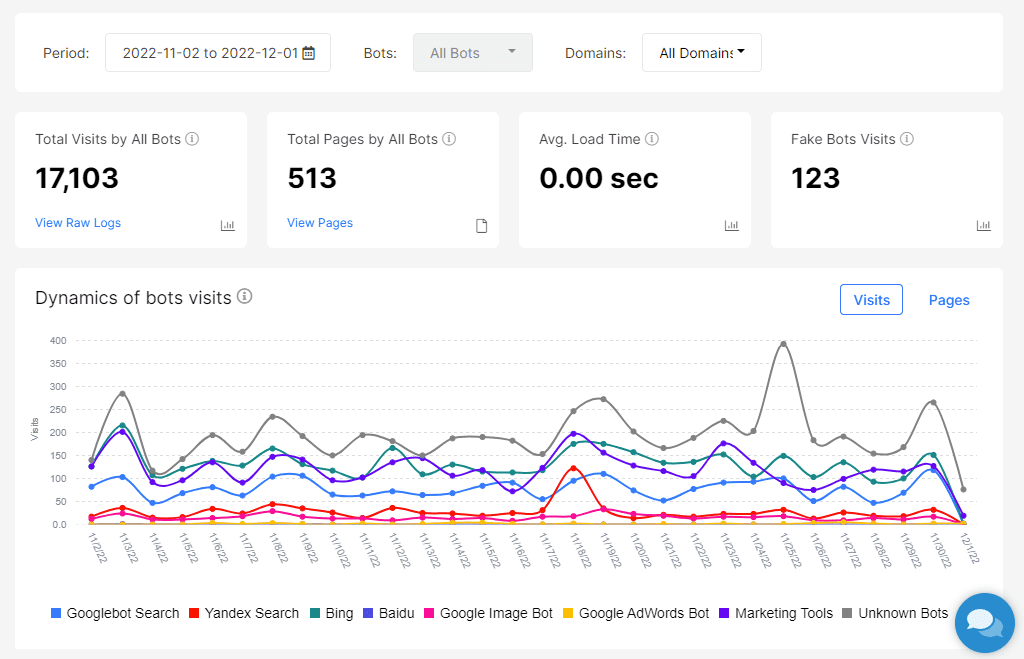

En la pestaña Overview, podemos ver el panorama general de visitas recibidas en nuestro sitio web por parte de los robots de Internet.

En la parte superior, puedes seleccionar el período que quieres analizar y, justo debajo, se ofrece un resumen con el total de visitas y páginas visitadas por robots, el tiempo medio de respuesta y posibles robots falsos.

A continuación, tenemos una gráfica que nos muestra las visitas diarias (en cantidad y en número de páginas) de los principales bots.

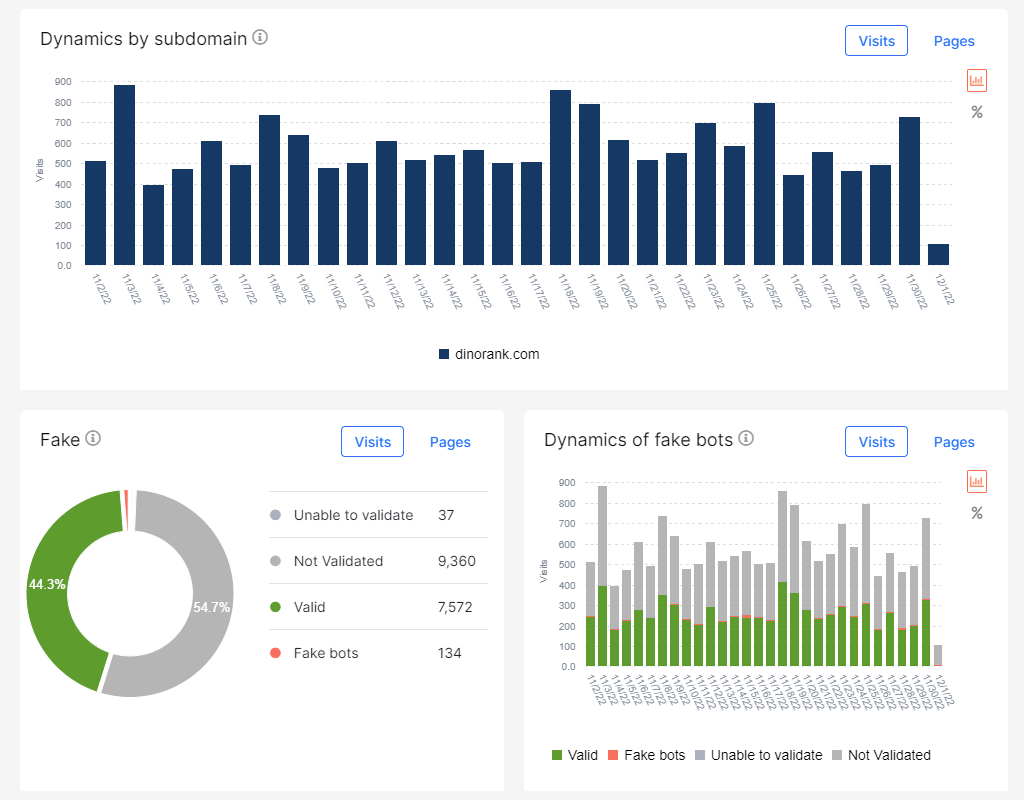

Además de esta gráfica tan ilustrativa, la pestaña Overview contempla otros 3 diagramas más, con las estadísticas de cada subdominio y las visitas de robots reconocidos y falsos.

Visión detallada de Bots

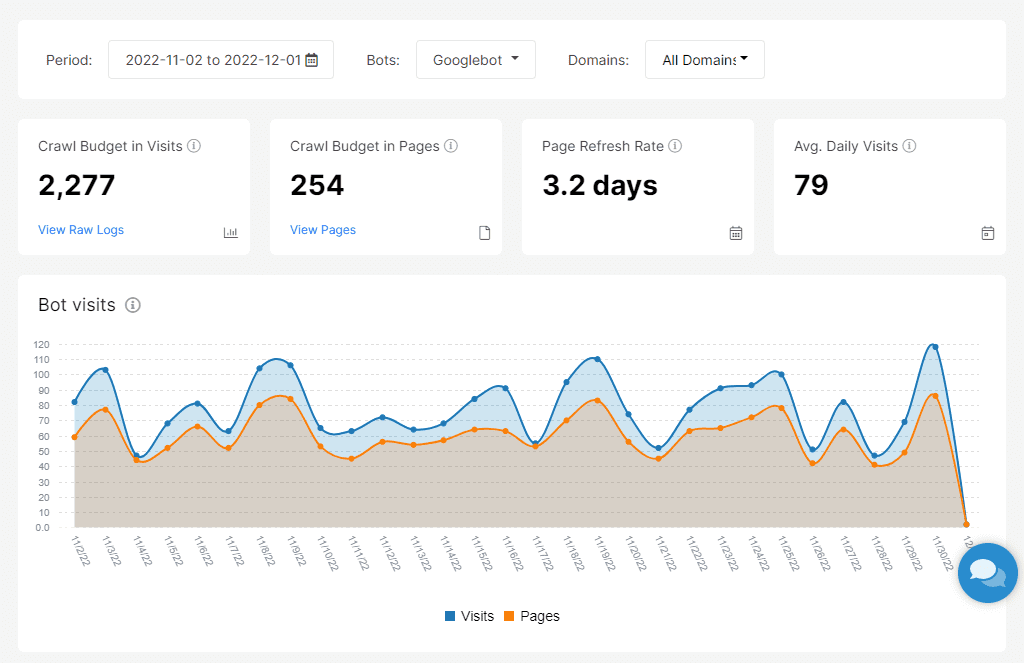

En la sección Bot Dynamics, podrás acceder a información más detallada acerca de las visitas recibidas por los robots de los buscadores.

Puedes ver todos los bots agregados o separar por tipo de bot (Google, Bing, Yandex).

En la parte superior, como siempre, se muestra el resumen de estadísticas sobre las visitas de cada robot.

Ahora bien, te habrás fijado que el nombre que utiliza JetOctopus para indicar el número de visitas o páginas visitadas va precedido por el término “Crawl Budget in…”.

De esta manera, JetOctopus nos está indicando que el número de visitas recibidas por robots y las páginas a las que han accedido no es algo que haya que tomar a la ligera.

Un ejercicio que deberías realizar es acceder al detalle mediante los enlaces View Raw Logs y View Pages, para ver si las páginas más visitadas son relevantes o no para tu sitio web.

Con estos datos podrías, por ejemplo, mejorar tu enlazado interno eliminando enlaces hacia las páginas menos importantes o añadiendo enlaces en las páginas más visitadas hacia otras más relevantes.

Además de la información anterior, en esta sección tienes también las siguientes gráficas:

- Visitas recibidas por bots y páginas diferentes visitadas.

- Códigos de respuesta.

- Tiempos de respuesta.

- Visitas desde dispositivos (hay que seleccionar un bot concreto).

- Versión del Bot de Google (sólo para tipo GoogleBot).

- Descargas del sitemap.

De nuevo, el análisis de estos datos te puede ayudar a no desperdiciar tu presupuesto de rastreo. Por ejemplo, si el robot de Google accede a muchas páginas con códigos de respuesta diferentes de 200 o, si la respuesta es muy lenta, deberías intentar corregirlo.

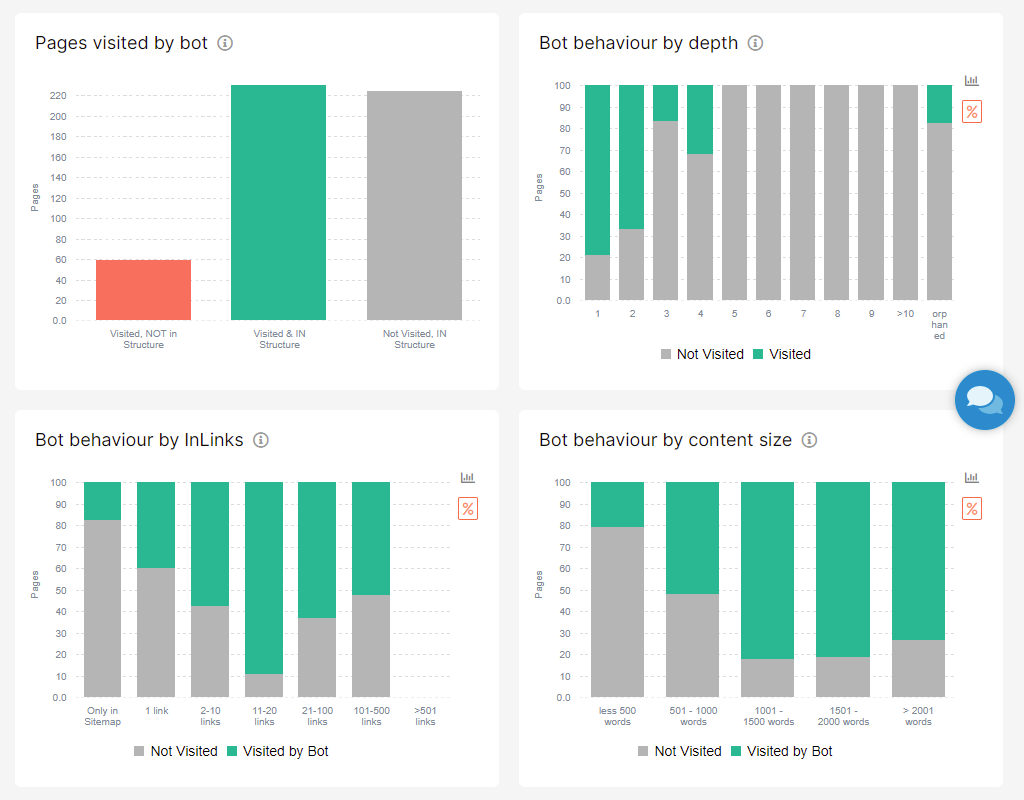

Impacto

Seguimos con el análisis de las visitas realizadas por robots.

En este caso, la sección Impact se centra en la relación que hay entre dichas visitas y la estructura de nuestra web o el contenido de las páginas.

Las primeras cuatro gráficas son muy representativas.

La primera nos advierte de aquellas páginas que no forman parte de la estructura básica de nuestra web pero, aun así reciben visitas de robots.

También de las que, a pesar de formar parte de la estructura web, no reciben ninguna visita.

Las otras 3 gráficas nos indican la relación que existe entre las visitas y la profundidad a la que se encuentra la página, el número de enlaces internos recibidos o la extensión de su contenido.

Finalmente, esta sección tiene otras 3 gráficas más con el impacto que supone el contenido duplicado, las etiquetas que bloquean la indexación y el número de visitas por página.

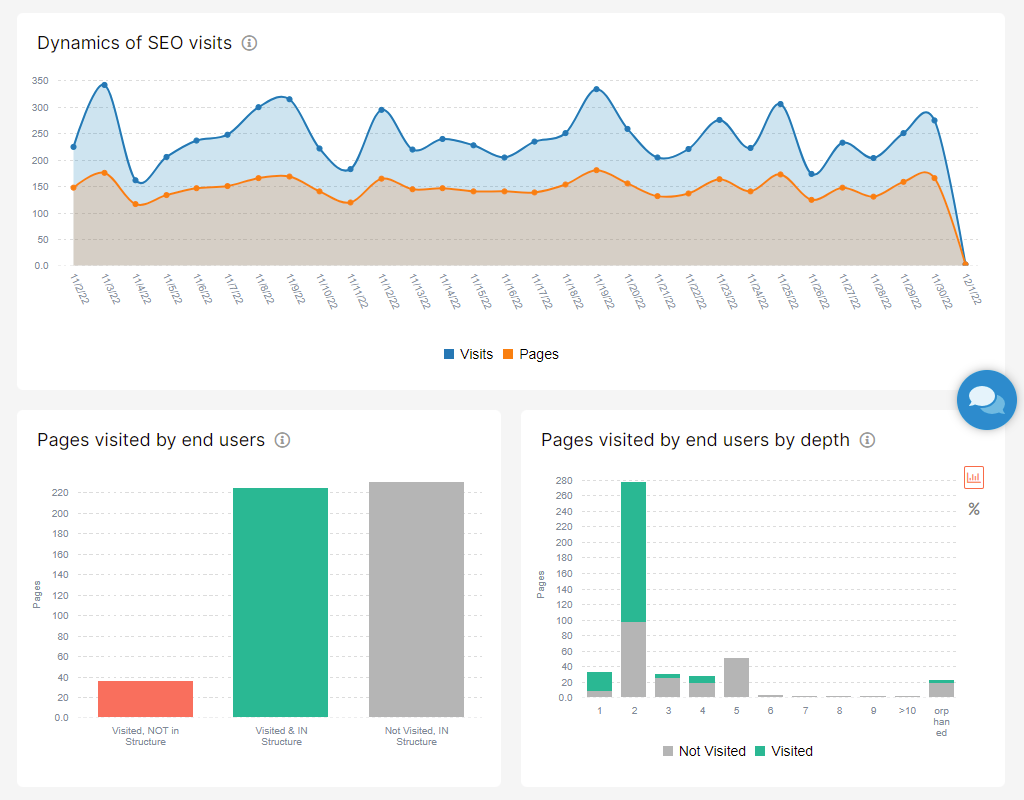

Visitas SEO

Los ficheros de log no se limitan exclusivamente a registrar la actividad de los robots.

También almacenan los accesos de los usuarios.

En esta sección tienes varias gráficas con estadísticas sobre los usuarios que llegan a tu web de manera orgánica. En concreto:

- Visitas realizadas por usuarios y número de páginas.

- Relación entre las visitas y la presencia o no de las páginas en la estructura web.

- Visitas recibidas en función de la profundidad de la página.

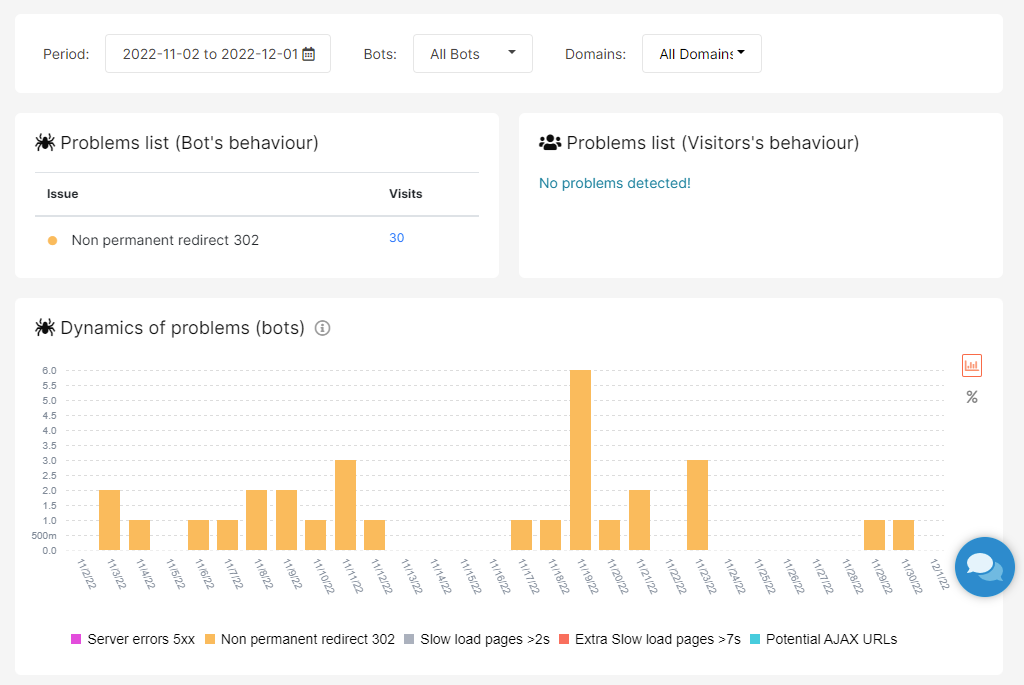

Salud del sitio

En este informe podrás ver un listado de potenciales problemas relativos a las visitas de los bots o de los usuarios.

Los problemas que se comprueban son los siguientes:

- Errores del servidor de tipo 5xx

- Redirecciones no permanentes 302.

- Páginas de carga lenta (más de 2 segundos).

- Páginas de carga muy lenta (más de 7 segundos).

- Posibles URLs con AJAX

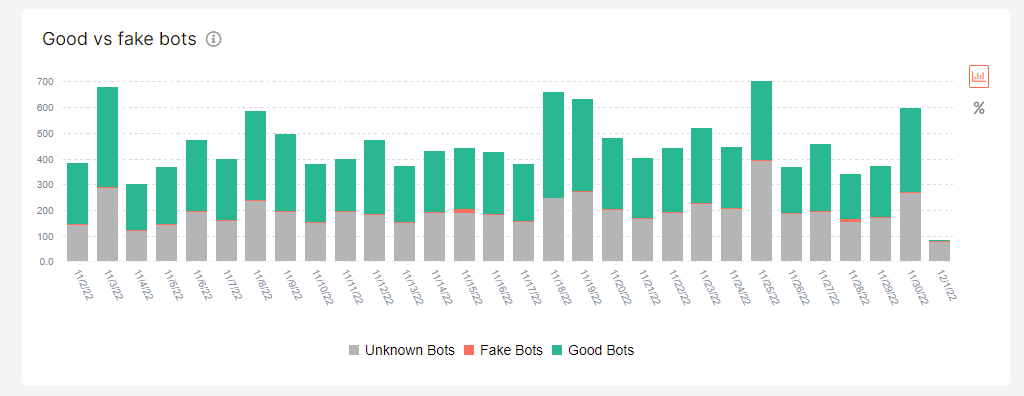

Otros Bots

¿Quién más está rastreando tu web?

En este apartado puedes ver la información de visitas realizadas por bots reales, bots falsos o que, simplemente, JetOctopus no reconoce.

Tablas de datos

Finalmente tenemos la sección de datos.

Para el módulo Log Analyzer, JetOctopus dispone de las siguientes tablas:

- Logs en bruto. Contiene toda la información de los logs, pero con un formato más amigable.

- Páginas presentes en los ficheros de logs.

- Visitas orgánicas recibidas.

- Páginas con visitas orgánicas.

- Subdominios.

- URLs con peticiones GET.

Además de estas tablas básicas, podemos acceder a información filtrada para conocer, por ejemplo, las peticiones con código de respuesta diferentes al 200, las solicitudes lentas, páginas con una sola visita, páginas más pesadas, y muchas cosas más.

Módulo GSC Keywords

Gracias a los dos módulos anteriores tenemos una visión sobre cómo de rastreable es nuestro sitio web y qué grado de interacción tiene con los robots de los diferentes buscadores.

Pero, de entre todos los sistemas que van a pasearse por nuestra web, hay uno que nos importa especialmente. Me refiero, cómo no, a Google.

Por suerte, gracias a Google Search Console, podemos conocer con facilidad la información más relevante sobre cómo este buscador está tratando nuestro sitio web.

El módulo GSC de JetOctopus es un complemento ideal a los otros dos módulos que ya hemos visto.

Te invito entonces a repasar conmigo todas las funcionalidades de este módulo tan útil.

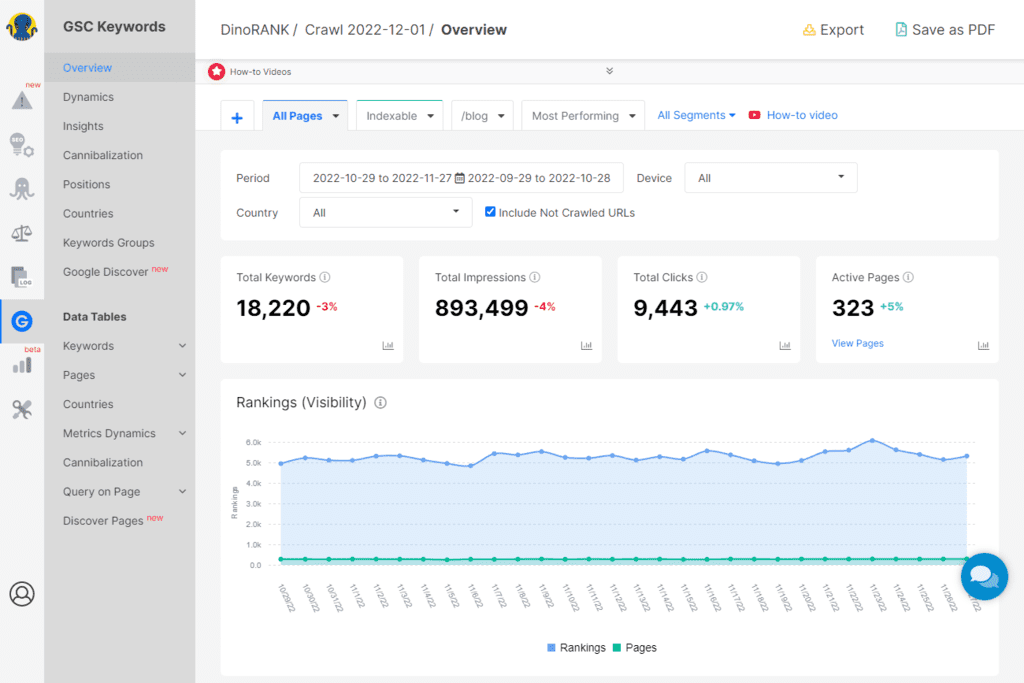

Visión general

El apartado Overview del módulo GSC de JetOctopus nos ofrece en primer lugar un resumen con las cifras de palabras clave posicionadas, impresiones totales, clics recibidos y páginas que han aparecido alguna vez en las SERP.

A continuación tenemos una gráfica con la visibilidad de nuestra web, expresada mediante dos medidas diferentes:

- Número de páginas únicas que son mostradas cada día en los resultados de búsqueda.

- Número de consultas únicas para las que se ha mostrado diariamente una página de la web dentro de los resultados de búsqueda. Es lo que, en JetOctopus, denominan Rankings.

Keywords es la consulta en sí (la palabra clave). Por ejemplo, “mejor herramienta SEO”.

Rankings tiene en cuenta la página mostrada. Si para una misma consulta (“mejor herramienta SEO”) se muestran 2 páginas diferentes en las SERP (página de inicio de DinoRANK y un artículo del blog), se contabilizan dos Rankings y 1 Keyword.

Además de la gráfica anterior, tenemos otras 3 más:

- Impresiones, clics y CTR.

- Estadísticas por tipo de dispositivo.

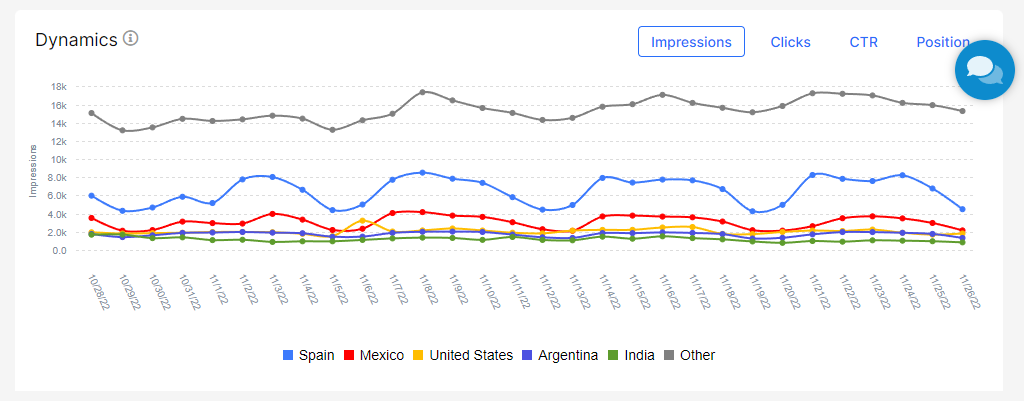

- Estadísticas por país.

Dinámica de impresiones y visitas

La sección Dynamics es una de las más interesantes de este módulo, ya que nos ofrece una información que no muestra Google Search Console.

En concreto, nos permite conocer qué páginas están mejorando su comportamiento y cuáles están empeorando, con respecto a un período anterior.

Perspectivas (Insights)

Esta utilidad nos permite poner en contraste varias métricas diferentes.

Cuenta con las siguientes gráficas:

- Clics y CTR en función de la posición de las páginas en las SERP.

- Rankings y CTR en función de la posición de las páginas.

- Consultas (Keywords) y CTR agrupadas por el número de palabras de la consulta.

- Impresiones y CTR en función del número de palabras de la consulta.

- Páginas agrupadas por el número de visitas.

Además, nos ofrece un listado con las consultas para las que nuestra web recibe más clics.

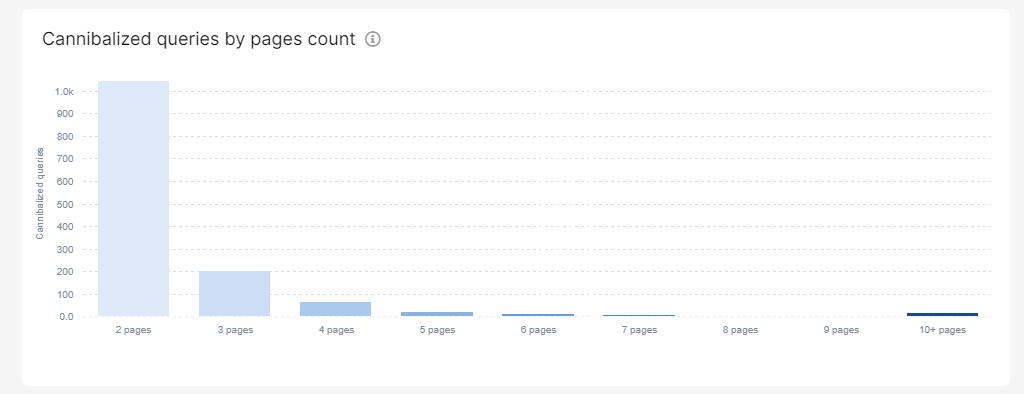

Canibalización de contenidos

Otro de los informes más útiles de este módulo es el de la canibalización de contenidos.

En Google Search Console podrías obtener esta información haciendo clic en cada una de las consultas y verificando si hay más de una página que posiciona para ella.

Es un trabajo manual bastante tedioso.

Con JetOctopus es mucho más fácil.

Esta sección muestra las siguientes estadísticas iniciales:

- Porcentaje de consultas que son canibalizadas (tienen más de 1 página en las SERP).

- Porcentaje de impresiones que suponen dichas consultas.

- Porcentaje de clics que suponen dichas consultas.

También incluye estas dos gráficas:

- Visión gráfica de las consultas canibalizadas, por impresiones y clics

- Agrupación de las canibalizaciones en función del número de páginas que se muestran en las SERP para cada consulta.

Por supuesto, desde cada vista podrás navegar a las tablas de datos correspondientes para conocer el detalle de cada canibalización.

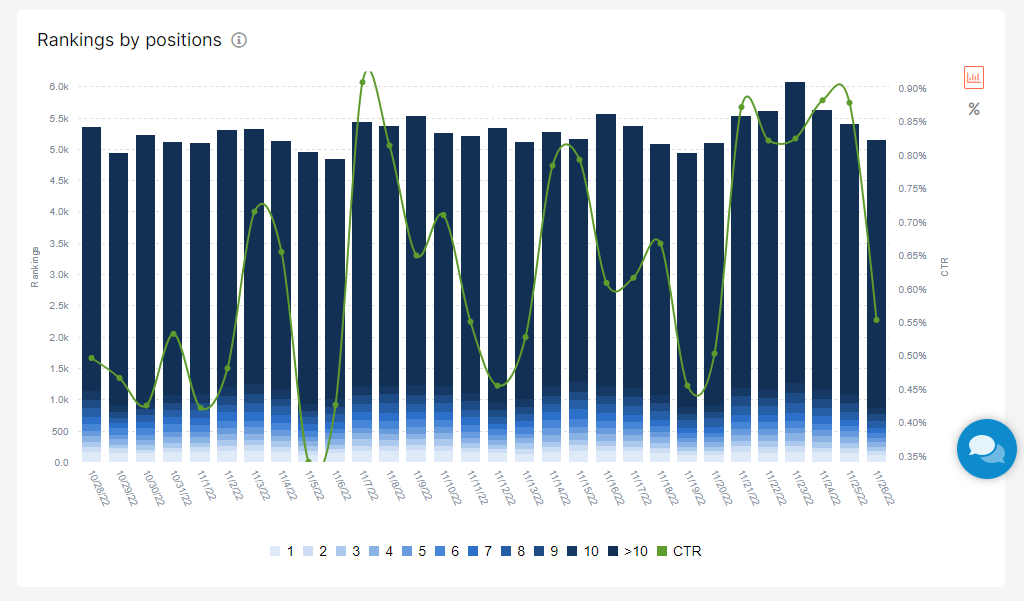

Posiciones

Este informe es bastante corto, pero no por ello menos interesante.

Nos muestra una gráfica en la que se identifica, mediante una escala de colores, la cantidad de páginas de la web que hay en cada posición de las SERP.

Países

En este resumen podrás analizar, gracias a diferentes estadísticas, la relevancia que tiene tu web en distintos países.

Agrupaciones de Keywords

Este apartado muestra el rendimiento de diferentes grupos de palabras clave.

Por defecto, sólo verás un grupo: el de todas las keywords. Pero puedes crear todas las agrupaciones que necesites.

Para crear una nueva agrupación de palabras clave, deberás especificar las keywords que componen dicha agrupación (una keyword por línea) y, adicionalmente, las URL que quieres controlar.

Lo más interesante es que se pueden comparar unos grupos con otros.

En la siguiente captura se compara el grupo de todas las palabras clave con una agrupación que he creado, llamada SEO, que comprende las siguientes keywords: “dinorank”, “seo”, “herramientas”.

El informe ofrece gráficas de:

- Rankings, Impresiones, Clics, CTR y Posición media de cada grupo de keywords.

- Distribución de las impresiones y clics por cada grupo de keywords.

- Impresiones y clics por dispositivo.

Tablas de datos

La sección de datos del módulo GSC de JetOctopus nos proporciona las siguientes tablas:

- Keywords.

- Páginas.

- Países.

- Metrics Dynamics.

- Canibalizaciones.

- Relación entre las keywords y los elementos de la página (títulos, descripciones, H1).

- Páginas en Google Discover.

Muchas de estas tablas principales tienen otras versiones más específicas que permiten centrarte en algún aspecto concreto. Por ejemplo, nuevas páginas en las SERP, palabras clave para las que la web ya no posiciona o páginas que regresan al Top 10.

Todas las tablas son útiles pero, por su comportamiento especial, merece la pena pararnos un momento en las que se muestran bajo Metrics Dynamics.

Estas tablas nos ofrecen información sobre número de impresiones, clics, CTR, posiciones, rankings, consultas y páginas. Estos datos están ordenados por fechas y marcados con diferentes colores para que podamos ver rápidamente qué métricas están mejorando y cuáles no.

Además, disponemos de filtros que nos permiten agrupar estas métricas por diferentes parámetros, como por URL o por país.

Módulo SEO

Si has seguido los pasos que te he comentado hasta aquí, deberías tener ya una buena colección de datos de tu web desde 3 perspectivas diferentes: rastreo, logs y Google Search Console.

Es el momento de verlo todo en conjunto y obtener así un panorama más general.

A continuación te mostraré todo lo que puedes extraer del mismo.

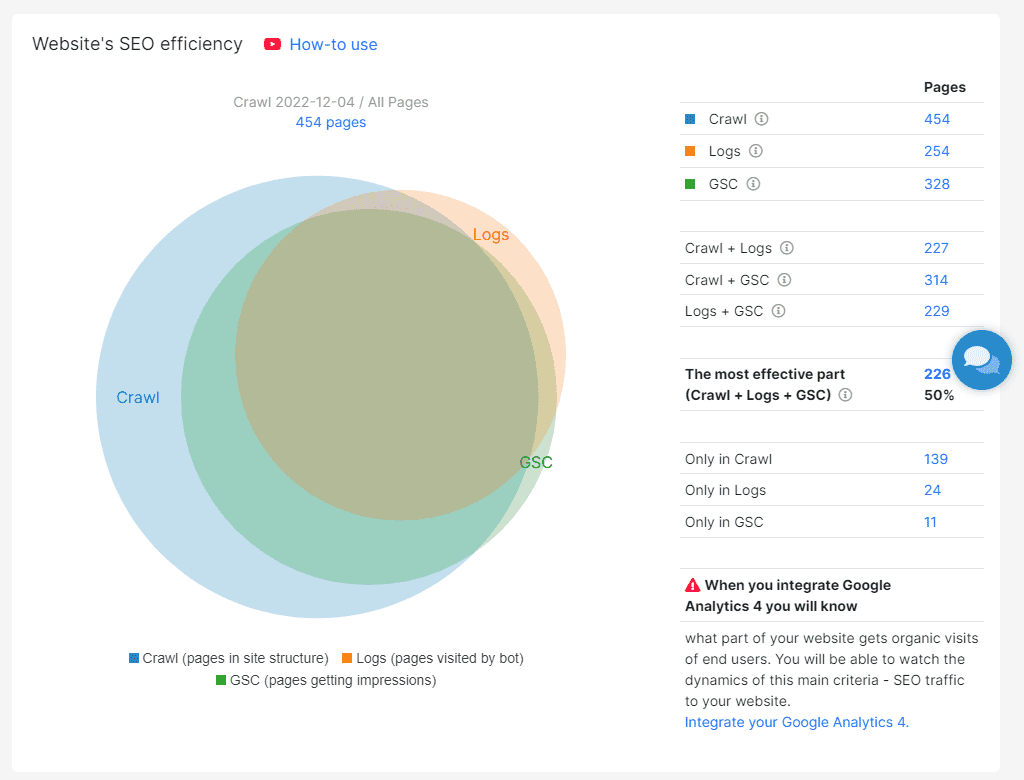

Eficiencia SEO

Esta sección debería ser la página principal de todo tu cuadro de mandos.

Ofrece una visión muy ilustrativa sobre el estado de tu web

La parte más interesante es la que presenta las intersecciones entre los conjuntos de datos del resto de los módulos.

De manera muy ágil puedes observar qué partes de tu web son más visibles y cuáles no.

Este informe te permite también comparar dos periodos de tiempo entre sí, para analizar el impacto de los cambios que hagas motivados por tu estrategia SEO.

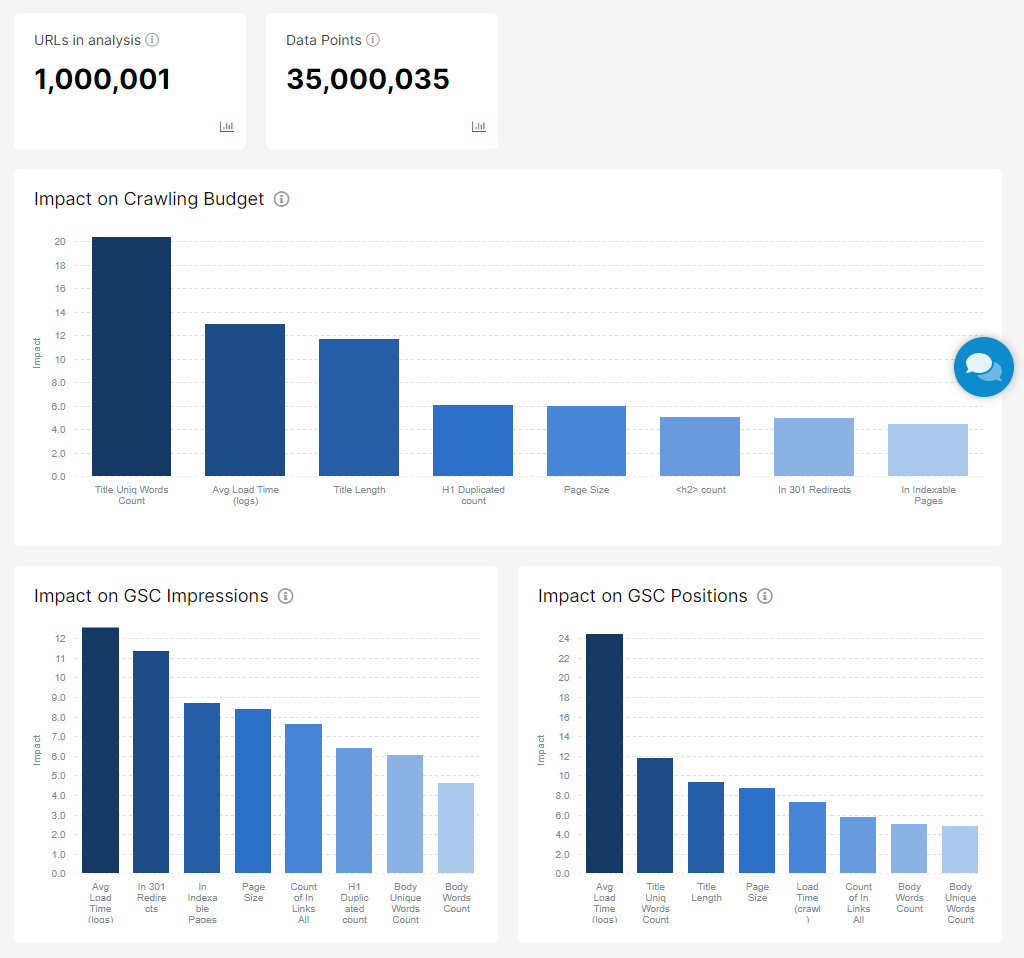

Impacto en profundidad

Este apartado sólo estará disponible si has rastreado un mínimo de 50.000 páginas y tus logs tienen, al menos, 100.000 líneas.

Debido a estos requisitos, no lo he podido probar para DinoRANK, pero sí te puedo mostrar la captura de un proyecto de ejemplo que viene con JetOCtopus.

Básicamente, las gráficas muestran los resultados obtenidos tras aplicar un algoritmo sobre los datos que intenta establecer la relación entre diferentes parámetros y el impacto que tienen en los resultados de cada uno de los módulos.

Eficiencia de la estructura de la web

Mediante este informe, en forma de tabla navegable, podemos observar el rendimiento de las diferentes URLs de nuestra web.

La tabla de datos sigue una organización por directorios.

Primero muestra una fila por cada URL de primer nivel. Haciendo clic en cada una de ellas se accede a sus URL hijas y así sucesivamente.

Las columnas son configurables, por lo que puedes mostrar y ocultar aquellas métricas que desees.

Además, se utiliza una escala de colores en muchos de los valores que nos permite ver fácilmente qué elementos deberíamos mejorar.

Problemas, oportunidades SEO y KPI

El módulo SEO tiene tres últimas secciones con listados de:

- Problemas identificados en los diferentes módulos.

- Oportunidades de mejora.

- KPI.

En JetOctopus hay unos KPI preconfigurados, pero puedes definir los tuyos propios y así evaluar tu web conforme a los parámetros que más te interesen.

Combinación de datos: el verdadero potencial de JetOctopus

En este punto ya habrás podido comprobar que la cantidad de datos que recopila JetOcopus sobre tu web es abrumadora.

No sólo tienes a tu disposición un buen puñado de informes gráficos, sino que puedes navegar entre tablas y más tablas con abundante información.

Todos estos datos, por sí solos, ya tienen mucho valor.

Ahora bien, si los combinas entre sí las posibilidades son enormes.

Y JetOctopus te da la posibilidad de hacer estas combinaciones de una manera bastante intuitiva.

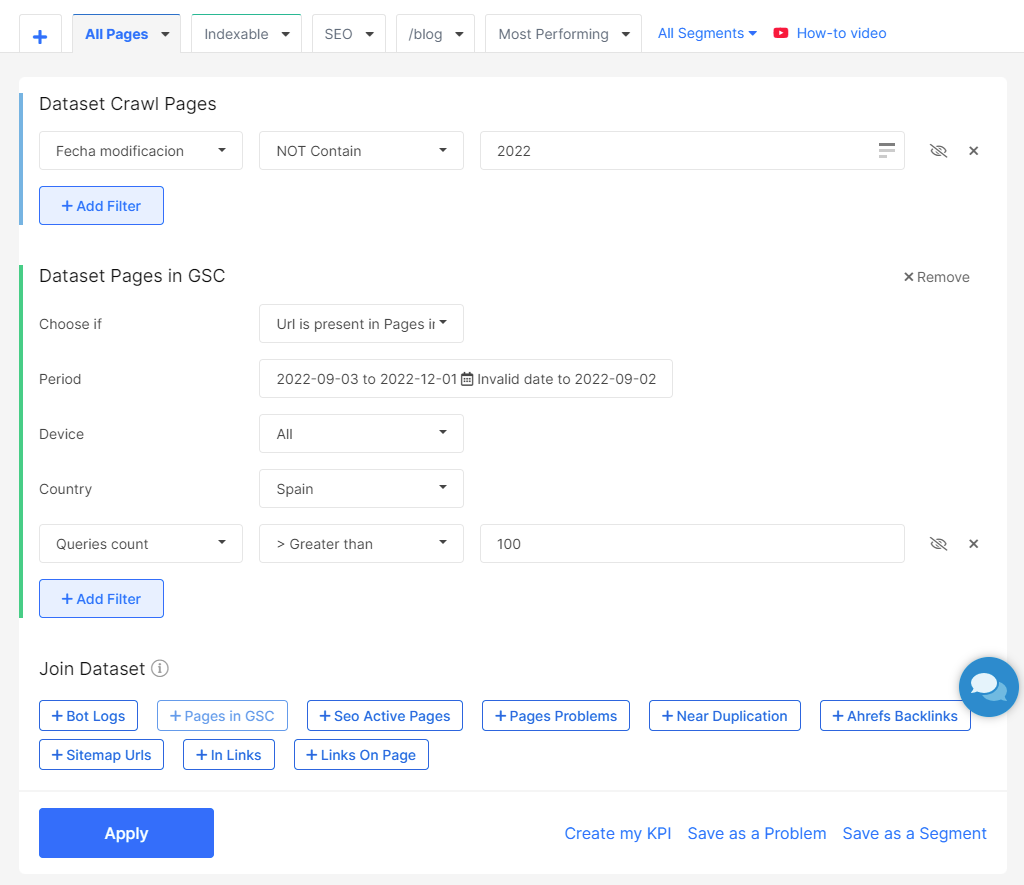

¿Recuerdas la sección de filtros que hay en la parte superior de cada tabla?

Ahí puedes jugar con los campos de cada conjunto de datos, para especificar con más detalle la información que quieres mostrar.

Pero es justo después de los filtros donde surge la magia.

Bajo el título Join Dataset se muestran los conjuntos de datos con los que puedes combinar la información que ya has filtrado.

Te lo muestro con un ejemplo.

Ya vimos cómo, durante la configuración del crawler, creé un campo personalizado para extraer la fecha de modificación de los posts.

Este campo, que parecía tener poco interés, lo voy ahora a combinar con los datos de GSC.

El filtro queda del siguiente modo:

¿Y qué consigo con esto?

Muy sencillo. Gracias a esta combinación de datos puedo saber qué páginas de mi web están apareciendo actualmente en las SERP de España a pesar de no haberlas tocado en todo el año.

¿Qué ocurriría entonces si refresco su contenido?

Si Google ya les daba relevancia es muy probable que, si detecta alguna actualización reciente, todavía las valore mejor y suban alguna posición en las SERP.

Y esto es sólo un ejemplo sencillo.

Seguro que a ti se te ocurren cientos de combinaciones de utilidad para tu web.

Por cierto, estos filtros y combinaciones de datos no los pierdes al cerrar JetOctopus. Puedes salvarlos como un KPI, como un problema o como un segmento que tengas siempre accesible en tus informes.

El resto de módulos de JetOctopus

Hasta aquí las utilidades que considero más importantes de JetOctopus.

Pero esta herramienta te ofrece mucho más.

Te lo resumo a continuación..

Comparación de Crawlers

Es evidente que el crawler es uno de los puntos fuertes de JetOctopus, quizá el mayor de ellos.

Por eso, dedica un módulo completo a comparar los resultados de diferentes ejecuciones del crawler entre sí.

En este apartado encontrarás la mayoría de los informes que ya vimos en el módulo Crawler, donde podrás poner en contraposición las métricas de dos rastreos diferentes.

Integración con Google Analytics

¿Qué sería de nuestras webs sin Google Analytics?

Los datos que nos proporcionan las analíticas de Google son cruciales hoy en día para la toma de decisiones estratégicas de nuestros proyectos.

JetOctopus no ignora esta realidad y ha incorporado la posibilidad de vincular tu cuenta de GA e integrar los datos de dicha plataforma.

Pero, aunque estos informes están muy bien, el valor de la integración no reside en ellos.

El mayor provecho lo obtendrás cuando empieces a combinar la información de GA con el resto de datos de JetOctopus.

Inspección de URLs a través de Google Search Console

Gracias a esta sencilla utilidad podemos comprobar si una URL (o conjunto de URLs que definamos) está indexada por GSC o no.

El informe muestra diferentes gráficas:

- Páginas que Google puede encontrar e indexar.

- Páginas que bloquean o no la indexación.

- Páginas que Google puede o no recuperar de nuestro servidor.

- URLs canónicas.

- Resultados enriquecidos.

- Usabilidad móvil.

- Verificación de robots.txt.

- Cantidad total de páginas desde el último rastreo.

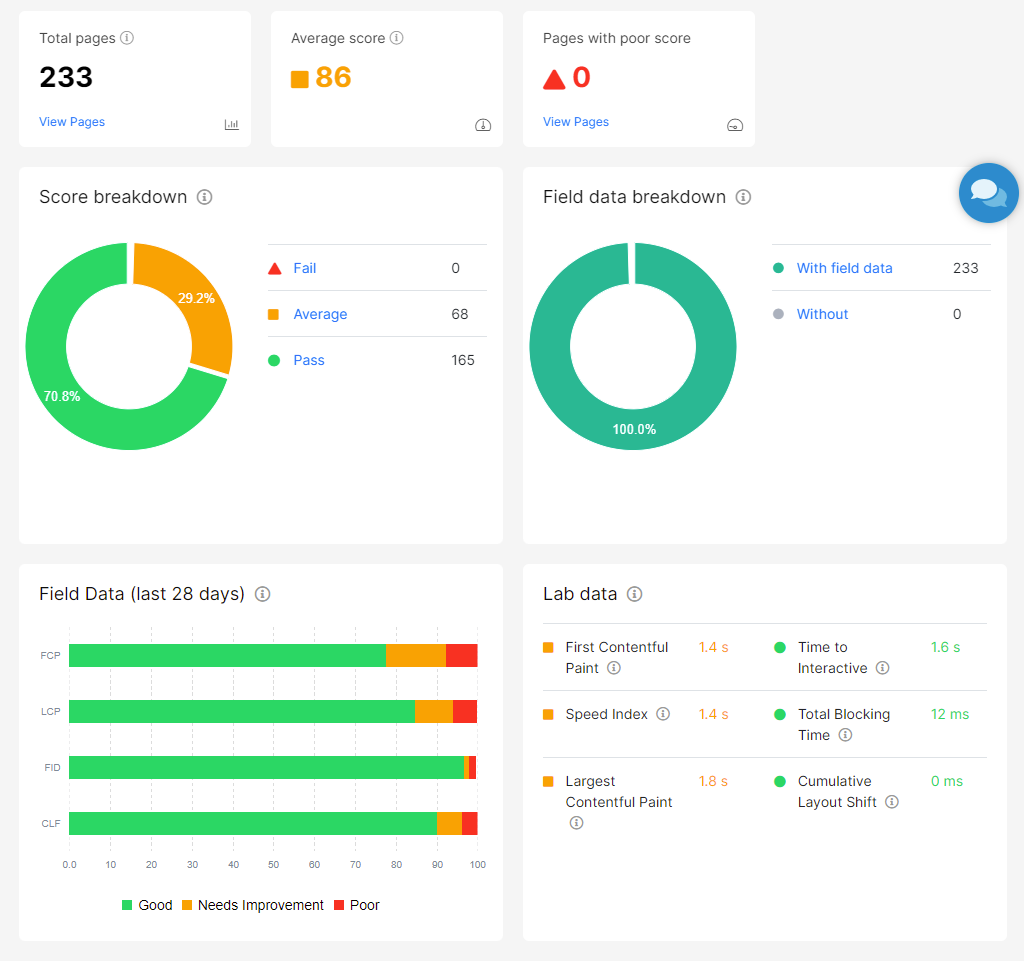

Análisis de Core Web Vitals

Los Core Web Vitals son las métricas que utiliza Google para valorar la velocidad de carga de una página web y la experiencia de usuario.

Por lo tanto, si Google tiene en cuenta estos parámetros, nosotros deberíamos considerarlos también.

Además, el propio Google nos facilita herramientas para medirlos, como la web PageSpeed Insights o una sección dentro de Google Search Console.

Pero estas herramientas son algo limitadas.

La primera te obliga a comprobar las páginas de tu web una a una y la segunda no ofrece demasiada información.

JetOctopus nos da una alternativa realmente práctica, que nos permite analizar los Core Web Vitals de varias URLs de nuestra web de forma simultánea.

Además, la utilidad de JetOctopus para medir estas métricas lo hace desde dos puntos de vista diferentes:

- A través de los datos históricos de usuarios reales recopilados por Google en los informes de experiencia de usuario de Chrome.

- Calculadas en un entorno controlado por medio de la API de Google.

La diferencia entre una medida y otra reside en que en la primera los datos están condicionados por las características particulares de los ordenadores de los usuarios y en la segunda no.

Por lo tanto, esta última podría considerarse más exacta.

Por otro lado, es la única manera de medir aquellas páginas que, por no tener suficientes visitas procedentes del tráfico de búsqueda orgánica, no disponen de información histórica.

Finalmente, tienes a tu disposición todos los valores en formato de tabla, para que puedas consultar el detalle de cada una de las URL de tu web.

Integración con Ahrefs

Si tienes una cuenta activa de Ahrefs puedes vincularla con JetOctopus.

De este modo, obtendrás un nuevo conjunto de datos con información sobre los enlaces externos.

Podrás combinar tus tablas con la información obtenida de Ahrefs y saber, por ejemplo, cuántos backlinks tienen cada una de tus URLs, cuántos dominios entrantes, salientes o el tipo enlaces que apuntan hacia ellas.

Integración con Data Studio

Si dispones de Data Studio, también puedes integrarlo con JetOctopus.

Gracias a la unión entre ambas herramientas, podrás generar en tu Data Studio una gran cantidad de informes a partir de los datos recopilados por JetOctopus.

Alertas

Una de las cosas que más nos preocupan como SEOs es enterarnos de cuándo algo está fallando.

Muchas herramientas nos facilitan mucho el trabajo de análisis y nos permiten comprobar el rendimiento de nuestra web a lo largo del tiempo.

Sin embargo, ¿qué ocurre cuando de repente hay un error en la web? ¿Qué pasa si Google empieza a valorarnos peor? ¿Cuánto tardamos en darnos cuenta?

Hay una serie de alarmas predefinidas, pero también puedes crear las tuyas propias.

Y cuando algo ocurra puedes recibir un aviso por correo electrónico, por SMS o a través de tu cuenta de Slack.

Así de fácil, puedes tener tu web bajo control en todo momento.

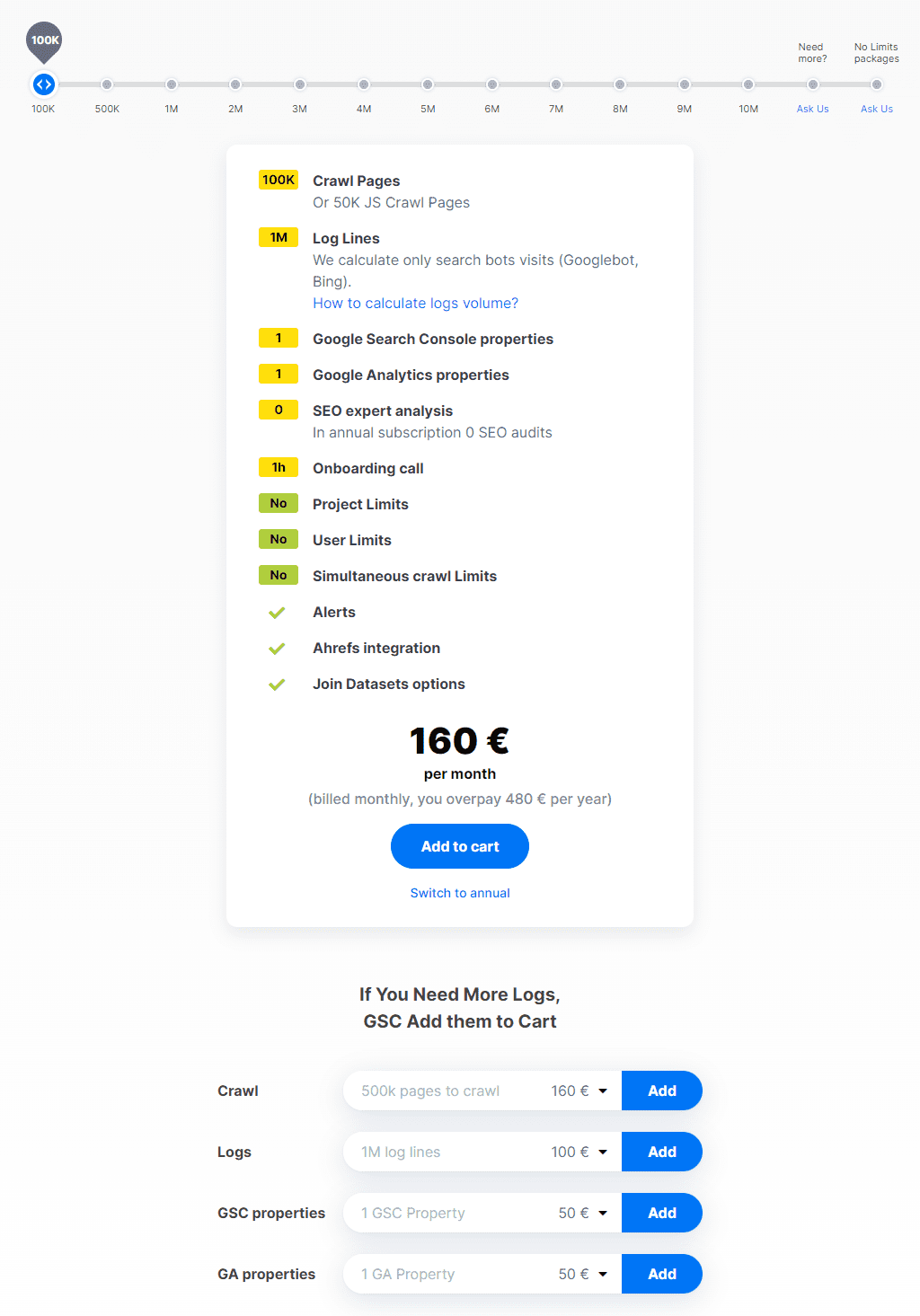

¿Y todo esto cuánto cuesta? El precio de JetOctopus

JetOctopus dispone de varios planes de suscripción, cuyo importe varía en función de los límites que vayas a necesitar.

¿Cuáles son esos límites?

Básicamente se ajustan a 3 parámetros:

- Número de URLs que puede recolectar el crawler.

- Número de líneas de logs que contienen información sobre robots.

- Número de propiedades de GSC.

Teniendo en cuenta estos requisitos, el plan más económico que puedes suscribir es de 160 € mensuales, aunque te sale algo más barato si contratas todo un año de golpe.

El plan básico incluye:

- 100.000 páginas mensuales para el crawler

- 1 millón de líneas de log al mes.

- 1 propiedad de GSC.

Si necesitas más potencia, puedes subir a un plan mayor o contratar ampliaciones de los módulos individualmente.

Como ves, son importes elevados, por lo que es conveniente analizar muy bien si JetOctopus encaja o no en tu trabajo como SEO antes de lanzarte a contratarlo.

Y para hacer esta evaluación, nada mejor que probarlo antes.

Si quieres, puedes solicitar una prueba gratuita de 7 días y revisar a fondo todas sus funcionalidades.

Eso sí, la prueba tiene los siguientes límites:

- 10.000 URLs para el crawler.

- Únicamente se recuperan datos en GSC de los 3 últimos meses.

- Los informes tienen un máximo de 500 filas.

Se trata de unas restricciones bastante razonables, que no te impedirán probar todas las ventajas que te ofrece JetOctopus.

DinoRANK como alternativa a JetOctopus

No sé si lo habrás notado pero, conforme avanzaba en el análisis de JetOctopus, veía muchos paralelismos con varias de las funciones de DinoRANK.

Por eso, creo que es bueno poner a estas dos herramientas frente a frente, de modo que puedas valorar cuál de las dos opciones es mejor para ti.

¿Y por qué digo esto?

Porque, como has visto, los planes de JetOctopus no son especialmente baratos y pueden suponer una buena mordida a tu presupuesto.

En cambio, DinoRANK tiene planes mucho más accesibles, desde 25 € al mes, por lo que, si tiene la funcionalidad que necesitas, quizá sea una mejor solución para ti.

Estas son las funciones de DinoRANK que comparte con JetOctopus:

- Rastreo de tu web y detección de problemas SEO.

- Análisis del enlazado interno.

- Análisis del tráfico orgánico (integración con Google Search Console y Google Analytics).

- Detección de canibalizaciones.

- Detección de Thin Content.

Por otro lado, DinoRANK te ofrece utilidades que no tienes disponible con JetOctopus:

- Tracking de posiciones

- Keyword research

- Análisis del Pagerank interno

- Análisis TF*IDF

- Análisis de la competencia

- Gestión de enlazado externo

- Análisis de Link Building (solo en planes Pro y Business).

Como ves, gran parte de la funcionalidad de los módulos Crawler y GSC Keywords de JetOctopus la puedes obtener también con DinoRANK.

Ahora bien, si uno de los principales motivos por los que estás evaluando JetOctopus es su analizador de ficheros de logs, tengo que decirte que, por el momento, no podrás realizar esta función por medio de DinoRANK.

Por lo tanto, la elección entre una u otra herramienta depende de tus necesidades y también de tu bolsillo.

Y eso es algo que sólo tú puedes decidir.

Opiniones finales de JetOctopus

JetOctopus se convierte en una aplicación muy útil para quien quiera gestionar el SEO técnico de su web, gracias a su potencial para hacer accesible una información que puede ser tediosa de interpretar.

Es una herramienta muy versátil que te permite tener recopilados en un único lugar gran cantidad de datos sobre tus sitios web.

No así por su precio, que la convierte en una solución que únicamente merece la pena contratar si vas a poder exprimir todo su potencial.

¿Y cómo saber entonces si es para ti?

En mi opinión, JetOctopus ofrece un beneficio más elevado cuanto mayor sea el volumen de páginas que debes gestionar, ya sea porque tu web tiene muchas URL o porque llevas un gran número de sitios web.

Es ideal para agencias de SEO, ya que no tiene ningún límite en cuanto a los proyectos que se pueden manejar ni al número de usuarios.

En cambio, si tus webs tienen un tamaño pequeño o medio, es preferible buscar otras soluciones alternativas que, quizá no sean tan completas como JetOctopus, pero seguramente sí más asequibles.