¿Te imaginas hacer una consulta en ChatGPT y que en la respuesta aparezca tu marca?

Pues eso ya está pasando.

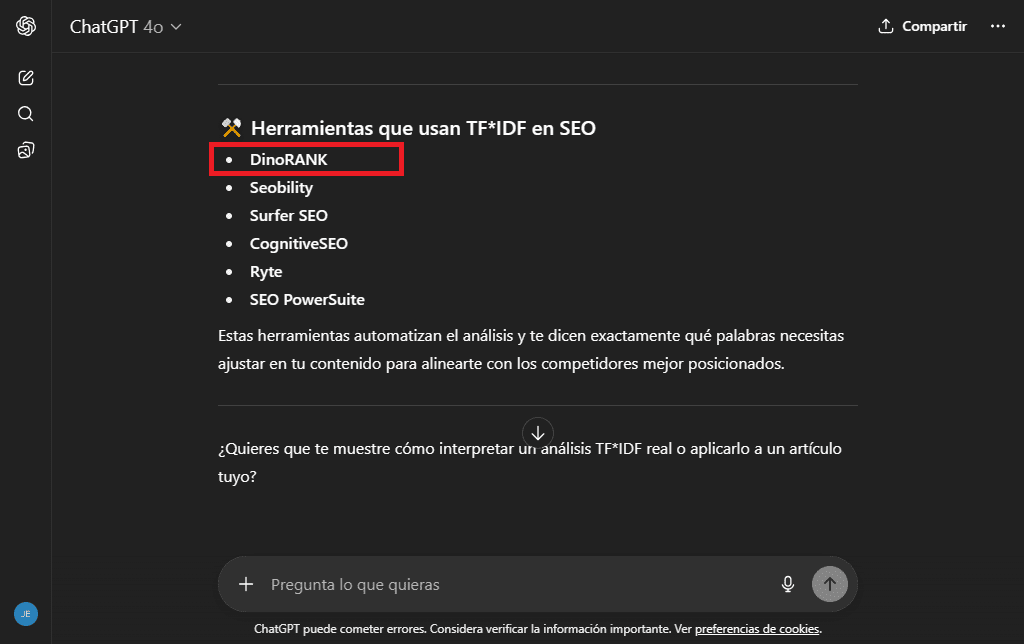

Fíjate en la siguiente imagen:

ChatGPT recomienda DinoRANK como herramienta SEO para realizar un análisis TF*IDF.

Te prometo que no le hemos pagado para que diga eso. De hecho, ni se puede.

El motivo de que mencione nuestra marca es porque forma parte de su base de conocimiento.

¿Te gustaría conseguir lo mismo con tu proyecto?

Entonces sigue leyendo, porque en este post te explico en qué consiste el LLMO, un concepto que está muy de moda por el auge de la IA, cómo puedes empezar a trabajarlo desde hoy mismo y cómo DinoRANK puede ser tu gran aliado en esta nueva forma de entender el SEO.

¡Empezamos!

Qué es un LLM y qué significa LLMO

LLMs significa Large Language Models (modelos de lenguaje grande o de gran tamaño) y es la tecnología que utilizan las herramientas de Inteligencia Artificial como ChatGPT, Gemini, Copilot o Claude para funcionar.

Estos modelos, basados en sistemas de aprendizaje profundo (deep learning) y redes neuronales, han sido alimentados con multitud de información de todo tipo: artículos científicos, libros, webs, foros, etc.

El objetivo no es otro que aprender cómo escribimos las personas, cómo preguntamos o cómo contestamos a diferentes cuestiones en contextos diversos.

De ese modo, cuando tú entras a ChatGPT y le pides algo, el LLM que hay por detrás es capaz de entender el lenguaje que utilizas y generarte una respuesta apropiada (un artículo, un resumen, un fragmento de código o lo que tú desees) como si fuera una persona.

¿Y sabes qué? En muchas de estas respuestas de la IA podría aparecer tu marca.

Es precisamente en este contexto donde surge el concepto de LLMO, que vendría a ser como el SEO pero para los modelos de lenguaje.

En concreto, la abreviatura LLMO significa “Large Language Model Optimization”. Consiste en optimizar tus contenidos para que sean comprendidos correctamente por los modelos de IA y, de esta manera, puedan aparecer como parte de las respuestas que generan.

¿Quieres saber cómo hacer que tu contenido no solo posicione en Google sino que también alimente a estos LLMs como ChatGPT?

Lo vamos a ver a continuación. Y comprobarás que no es tan complicado como parece.

Cómo hacer SEO para LLM con DinoRANK

Para hacer SEO en LLM con sentido hay una cosa que debes tener muy clara: no puedes ir a ciegas.

Es decir, existen varias técnicas para conseguir aumentar las probabilidades de que tu contenido sea citado en las respuestas generadas por IA (más adelante te hablaré de ellas en profundidad), pero de poco te sirven si no puedes analizar después los resultados.

Y precisamente es en este punto donde DinoRANK te puede echar una mano.

Porque si hasta ahora DinoRANK había sido una herramienta SEO muy útil para ayudarte a aumentar tu visibilidad en Google y en otros buscadores, en la era de la inteligencia artificial quiere seguir siéndolo.

Por eso, el equipo técnico de DinoRANK está dedicando un gran esfuerzo en comprender cómo funcionan las nuevas plataformas impulsadas por IA donde los usuarios formulan ahora sus preguntas, con el objetivo de incorporarlas a los análisis de la herramienta.

Fruto de ello es el módulo de SEO en LLMs, que te va a permitir estudiar las respuestas de modelos como ChatGPT o Gemini para comprobar si tu proyecto está siendo mencionado de algún modo por ellos.

Hasta ahora no son muchas las herramientas que te permiten monitorizar las apariciones de tu marca en la IA, por lo que una vez más es de agradecer la apuesta de DinoRANK por estar siempre al corriente de las tendencias más actuales el sector.

Te explico todos los detalles a continuación.

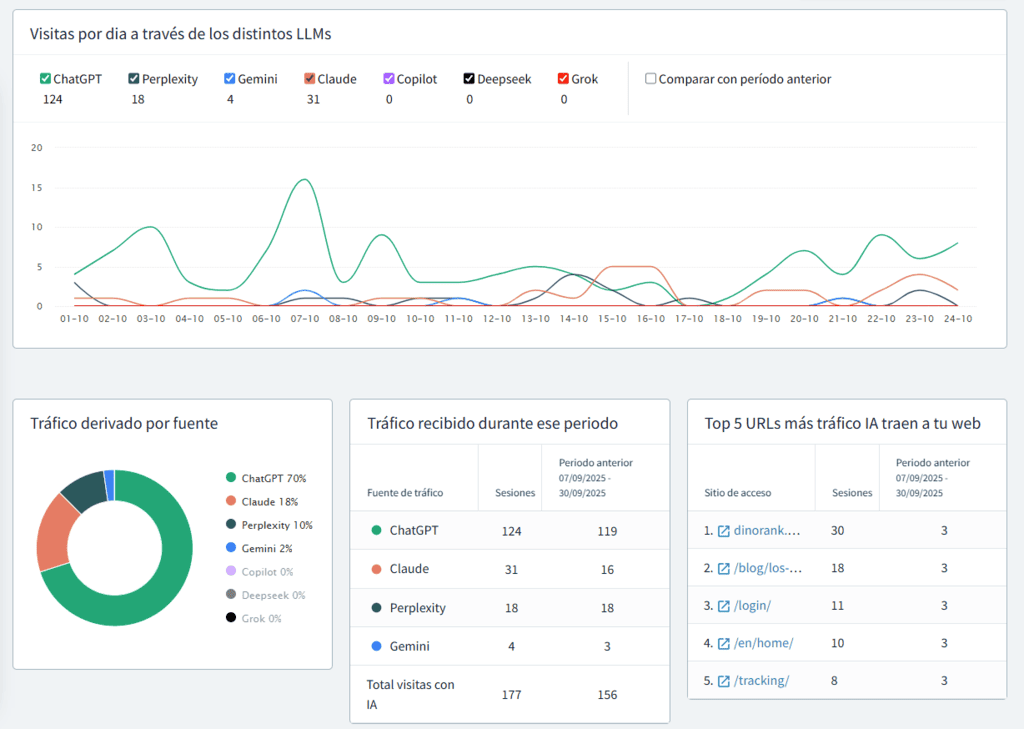

Conoce el tráfico que recibes desde los distintos LLMs

¿Sabrías decirme si tu sitio web está recibiendo visitas procedentes de la IA?

¿Y desde qué plataforma exactamente (ChatGPT, Gemini, Copilot, Perplexity,…)?

Vale, es cierto que esta información la puedes obtener con Google Analytics. Pero llegar hasta ella no es nada intuitivo y muchos usuarios no tienen nada claro cómo hacerlo.

Lo sé porque me han preguntado cientos de veces sobre ello.

Con DinoRANK conocer el tráfico que procede de los modelos de lenguaje como ChatGPT es muy fácil y visual.

Basta con conectar tu cuenta de Analytics e ir a la pestaña “Tráfico” dentro del módulo de SEO en LLMs.

De esta manera verás varias gráficas y tablas que te mostrarán:

Como ves, tienes a tu disposición una información muy valiosa que te permitirá evaluar el impacto que tiene la IA para tu proyecto.

👉 Si buscas una solución gratuita para saber el tráfico que recibes desde los modelos de IA, echa un vistazo a nuestra plantilla de Looker Studio.

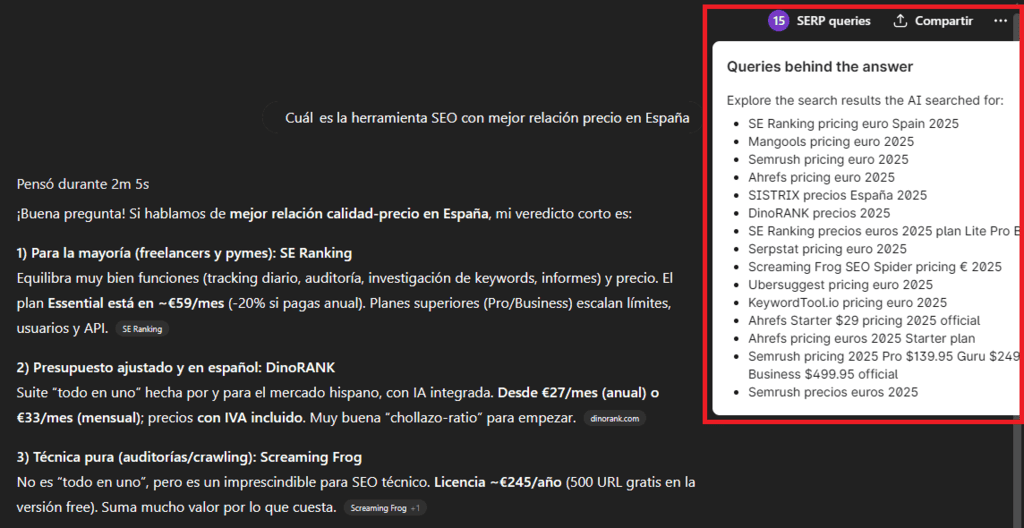

Monitoriza tus prompts en ChatGPT y otros modelos de lenguaje

Ahora bien, las estadísticas anteriores están genial, pero tienen un problema: no sabemos cómo estamos obteniendo este tráfico.

O, dicho de otro modo, cuáles son las preguntas de los usuarios que están haciendo que nuestro proyecto aparezca en las respuestas generadas por la IA.

Para dar solución a esta cuestión, en DinoRANK se ha añadido la función de Tracking en LLMs.

Si alguna vez has usado el tracker de keywords de DinoRANK, sabrás que es una utilidad muy potente. De hecho, es una de las más valoradas por los usuarios de la herramienta.

Pues bien, toda esta experiencia de monitorización de palabras clave se ha trasladado al módulo de SEO en LLMs para permitirte hacer un seguimiento de tus prompts en las principales plataformas de IA.

El funcionamiento es el siguiente:

En primer lugar tienes que configurar tu proyecto para indicar cómo puede aparecer mencionada tu marca por los modelos de lenguaje. Además, puedes añadir descripciones de tu proyecto a DinoRANK para darle todavía más contexto.

![]()

Hecho esto, es el momento de añadir tus prompts. Aquí puedes escribir aquellas preguntas que ya sepas que son relevantes para tu marca o pedirle a DinoRANK que te sugiera ideas.

![]()

Cuando tengas listo tu listado de prompts es el momento de configurarlos. Elige sobre qué plataformas quieres hacer el seguimiento (ChatGPT, Perplexity, Gemini, Claude, etc.) e indica los dominios de tus competidores, así como sus nombres de marca. Esto te permitirá saber si ellos también están siendo citados por la IA o no.

![]()

Adicionalmente, puedes agrupar todos tus prompts bajo una misma etiqueta, para que luego te resulte más sencillo analizarlos.

Por ejemplo, en el caso de DinoRANK, podríamos tener una etiqueta para englobar los prompts relacionados con “herramienta SEO”, otra para “máster de SEO”, otra para “SEO en IA”, etc.

Una vez hayas configurado tus prompts, la herramienta hará la consulta en los diferentes LLMs y mostrará una tabla como la siguiente.

![]()

En esta tabla podemos ver:

Además, si hacemos clic en cada una de las respuesta de la IA accederemos a su detalle, donde podremos indicar que nuestra marca aparezca resaltada, para ver cómo se está utilizando exactamente.

![]()

Cada 72 horas todos estos resultados se van renovando de manera automática. De este modo podremos llevar un seguimiento y saber si las acciones de LLMO que estamos realizando en nuestro proyecto están teniendo éxito o no.

¿Y qué acciones son esas? ¿Cómo podemos trabajar la optimización de modelos de lenguaje?

Ha llegado el momento de contártelo. Pero antes, es necesario que conozcas un poco de teoría sobre los LLMs.

Cómo funcionan los LLMs

Ahora toca ponerse un poco más técnico. Pero no te preocupes, intentaré no liarte con conceptos raros y contarte cómo funciona un LLM de la manera más sencilla de la que sea capaz.

Fase 1: entrenamiento

Para que un modelo de IA pueda responderte a todo aquello que le preguntes, antes debe ser alimentado con cantidades ingentes de datos: libros, artículos, hilos de Reddit, blogs de recetas, papers científicos y un montón de fuentes más.

Toda esa información, una vez procesada, forma lo que llamamos el corpus del LLM.

Esta fase se llama entrenamiento y es carísima. Dura semanas o meses y requiere unos ordenadores superpotentes.

Fase 2: inferencia

Una vez entrenado, el LLM ya está listo para responder preguntas, escribir textos, hacer sugerencias, etc. Esto se llama inferencia y es lo que ocurre cada vez que tú interactúas con la IA, dándole unas instrucciones, un contexto o corrigiéndole cuando no te gusta lo que te devuelve.

Ahora bien, para crear esta respuesta, el LLM debe procesar tu prompt.

El prompt es dividido en trozos más pequeños llamados tokens.

Estos tokens se emparejan con elementos del modelo, se calculan las relaciones semánticas y se van prediciendo nuevos tokens que compondrán la respuesta final.

Fase 3: búsqueda de información actual

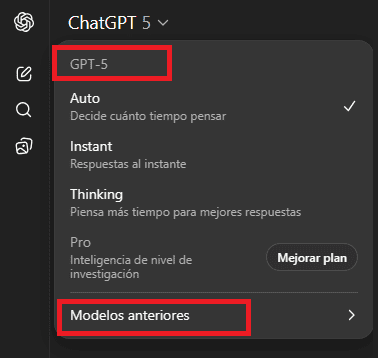

El LLM solo conoce lo que ha aprendido hasta su última actualización. Por ejemplo, en el caso de GPT-5, tiene información hasta junio de 2024.

¿Qué pasa entonces si le preguntas por algo reciente?

Supongo que ya sabes la respuesta: lo busca en Internet.

Esta técnica se conoce con el nombre de RAG (Retrieval-Augmented Generation) y no es sino el proceso que permite a los LLMs complementar la información de su corpus con los datos de una fuente externa.

De manera sencilla, lo que hace el RAG es esto:

- Detecta que tu pregunta necesita información nueva o específica.

- Descompone tu prompt y lo transforma en varias consultas, que lanza de manera simultánea a Internet. Es lo que se llama query fan-out.

- Recupera los textos más relevantes, los filtra, los resume y se los pasa al modelo.

- Y con eso, genera la respuesta final.

Así, aunque el modelo “base” esté entrenado hasta cierta fecha, puede actualizarse sobre la marcha si tiene acceso a fuentes externas.

Cómo optimizar para LLMs. Guía de LLMO con ejemplos prácticos

Llegados a este punto, quizá estés empezando a pensar que esto del LLMO es demasiado complejo. Modelos de lenguaje, redes neuronales, inteligencia artificial,.. Todo suena demasiado técnico y quizá por eso asuste un poco enfrentarse a ello.

Déjame tranquilizarte. Lo cierto es que la optimización SEO para LLMs se basa en una serie de pautas que casi todo el mundo puede aplicar en su sitio web.

No necesitas ser programador, ni tener una ingeniería para trabajar el LLMO. Si ya hacías SEO verás que muchas cosas son similares y que otras tan solo requieren un poquito de cuidado y sentido común.

Vamos a verlo.

1. Estructura tus contenidos de forma clara

Los LLMs necesitan procesar y comprender tus textos. Por eso, si utilizas una estructura lógica y jerárquica, junto con un formato escaneable, facilitarás mucho su trabajo.

- Usa encabezados (<h2>, <h3>,…) para dividir bien los bloques temáticos.

- Destaca palabras clave o ideas clave en negrita.

- Utiliza las listas con viñetas o números.

- Incluye tablas o comparativas si tienes varios elementos que contrastar.

- Evita los párrafos largos: 3 ó 4 líneas por bloque como máximo suele ser una buena aproximación.

Por otro lado, ¿te has fijado en los bullet points que solemos colocar al inicio de nuestros posts?

Son una buena práctica que no solo ayudan al lector a saber si le va a interesar o no el contenido, sino que también le dan al modelo una idea rápida de lo que puede encontrar y qué partes usar si tiene que citarte o resumirte.

2. Utiliza formatos de pregunta-respuesta

Si estructuras tus páginas en forma de preguntas y las contestas a continuación estarás ofreciendo a los modelos del lenguaje justo la información que necesitan para responder a los usuarios.

Si analizas los títulos de este mismo post verás que esto es precisamente lo que hemos intentado hacer.

Ten en cuenta que la interacción con la IA suele ser muy conversacional, por lo que cuanto más nos ajustemos a ese formato, más probable es que nuestros contenidos formen parte de los resultados que ofrece.

¿No se te ocurre qué preguntas puedes incluir en tus contenidos?

No me lo creo. Pero si es así, siempre puedes inspirarte en las preguntas frecuentes de Google.

3. Responde a la intención de búsqueda lo antes posible

No marees y ve al grano. No pongas contexto innecesario, ni te lies con historias que no vienen a cuento.

Porque si el lector humano se cansa rápido, el modelo seguramente considere que tu información es de poco valor si no le das lo que busca en las primeras líneas.

Intenta responder siempre en el primer párrafo, o mejor en la primera frase. Luego ya, si quieres, desarrollas, matizas o amplías la información. Pero la respuesta principal tiene que estar arriba.

Mira estos dos ejemplos para la pregunta “¿Qué es el SEO On-Page?”:

- El SEO On-Page es el conjunto de optimizaciones que se aplican dentro de una página web para mejorar su posicionamiento en buscadores.

- El SEO, o Search Engine Optimization, es una práctica cada vez más común en el marketing digital. Desde que los motores de búsqueda existen, los profesionales han buscado formas de mejorar su presencia online. Existen muchos tipos de estrategias SEO, bla, bla, bla …

¿Con cuál crees que se quedará la IA y cuál desechará?

4. Enriquece tus contenidos con entidades relacionadas

Para que un LLM entienda tus contenidos y pueda usarlos en sus respuestas, debes darle contexto semántico y, para ello, usar sinónimos, conceptos relacionados, ejemplos, etc.

En este punto, juegan un papel muy relevante las entidades, que ya eran utilizadas por Google, pero que ahora con los LLMs adquieren más importancia si cabe.

Las entidades son términos que tienen un significado claro y reconocido dentro de una base de conocimiento. Por ejemplo:

- “Google” es una entidad (empresa).

- “SEO” es una entidad (disciplina).

- “PageRank” es una entidad (algoritmo).

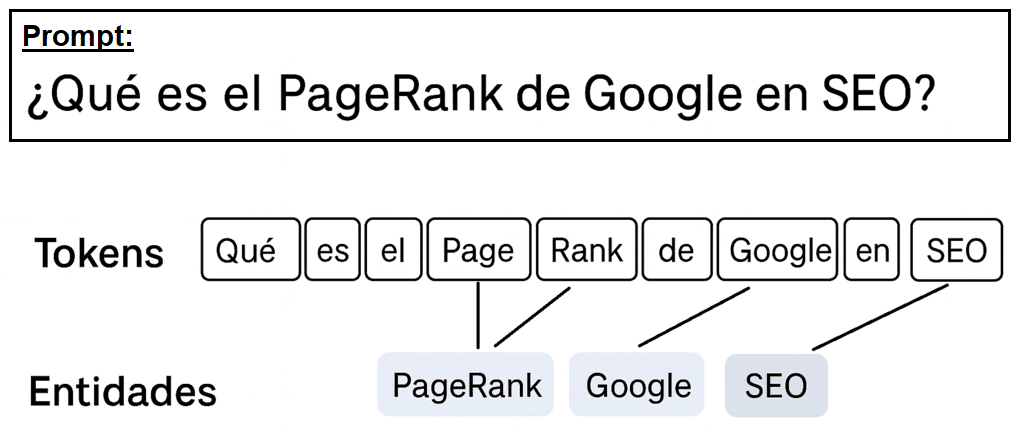

¿Recuerdas el tema de los tokens que comentamos antes?

Pues bien, la combinación de varios tokens puede dar lugar a entidades, que el modelo puede entender y relacionar entre sí. En la siguiente imagen creo que se ve bastante bien esta idea:

De este modo, cuantas más de estas entidades relevantes incluyas en tu contenido, más claro le queda al modelo de qué estás hablando.

5. Incluye citas, ejemplos y estadísticas

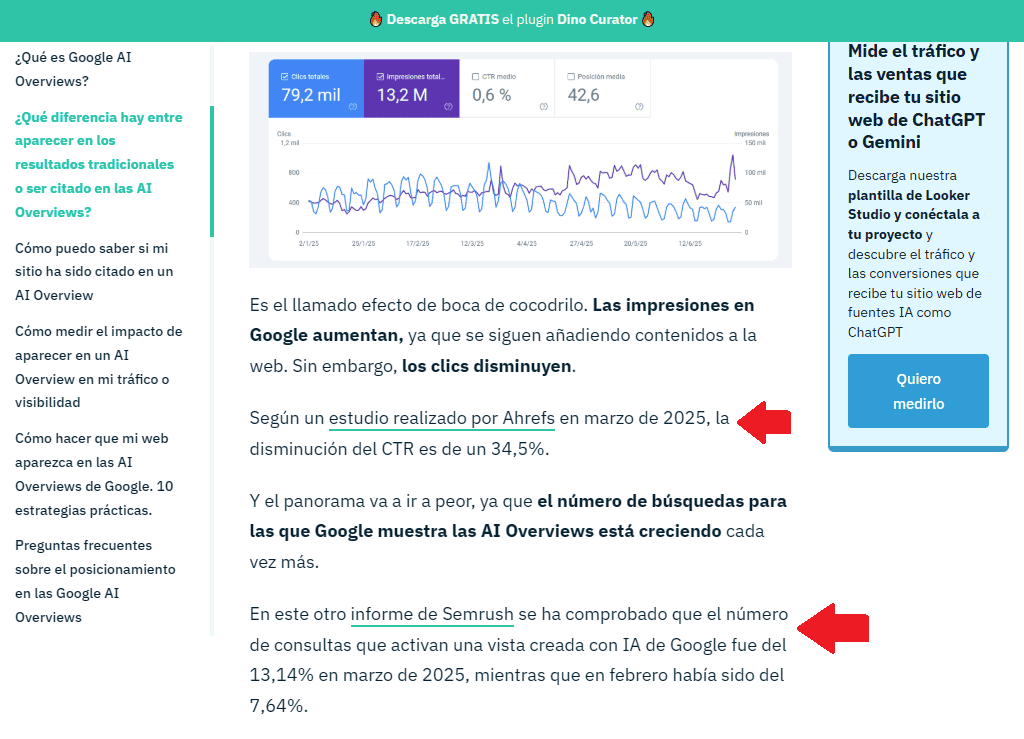

Si te apoyas en datos reales y concretos aumentas las probabilidades de que un LLM te considere una fuente fiable al generar sus respuestas.

Porque cuando el modelo escanea tu contenido, identifica que no estás divagando, sino que te apoyas en hechos, nombras entidades relevantes y sabes de los que hablas.

Y eso, a nivel práctico, se traduce en usar ejemplos claros, estadísticas relevantes o citas con fuentes. Mira, por ejemplo, este fragmento de nuestro post sobre cómo posicionar en las AI Overviews.

Además, si aportas tu experiencia personal con casos reales y demostrables, que apoyen lo que estás contando, estarás reforzando tu autoridad como experto en la materia y es muy probable que la IA te acabe citando en determinadas ocasiones.

6. Emplea lenguaje natural

Escribe como si hablaras. De manera correcta, eso sí, pero sin tecnicismos, ni frases enrevesadas.

Recuerda que los modelos de lenguaje necesitan entender lo que dices, pero también cómo lo dices, para poder dar respuestas lo más naturales posibles.

Por eso, funcionan mejor cuando el lenguaje es claro y directo, ya que les resulta más sencillo dividir las frases en tokens coherentes, asociar esos tokens a entidades y entender el significado global de todo el texto.

Te pongo un ejemplo para que entiendas mejor a lo que me refiero:

- “El PageRank constituye uno de los pilares fundamentales del ecosistema algorítmico de Google para la jerarquización de los resultados de búsqueda.”

- “El PageRank es uno de los sistemas que usa Google para decidir qué páginas muestra primero cuando buscas algo.”

En definitiva, cuando escribas algo, léelo dos o tres veces y, si hace falta, pásaselo a tu hermano a ver si lo entiende.

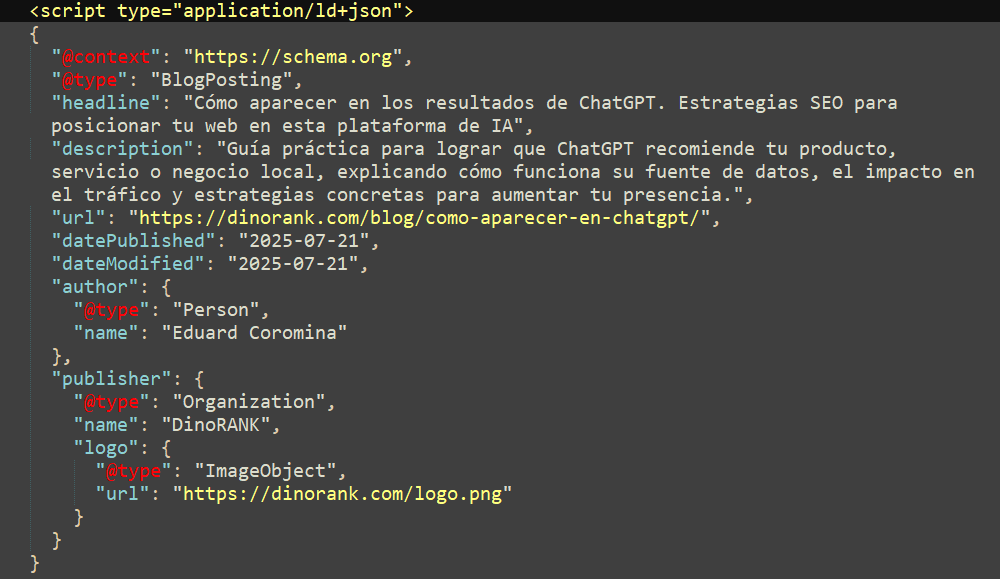

7. Utiliza datos estructurados

Si queremos que la IA interprete nuestro contenido sin lugar a errores podemos usar metadatos o datos estructurados tipo Schema.org para informarle sobre los puntos fundamentales. Echa un vistazo al siguiente ejemplo:

Le estamos diciendo al modelo, a través de un formato legible para máquinas, cosas como:

- “Esto es un artículo de blog.”

- “Se trata de una guía para aparecer en ChatGPT.”

- “Se ha publicado recientemente”

- “El autor es Eduard Coromina, que forma parte de DinoRANK”

De este modo, además de facilitar al modelo la interpretación del contenido, ya estás identificando entidades desde un primer momento, por lo que tus textos serán también más fáciles de reutilizar e integrar en las respuestas de la IA.

8. Refuerza tu EEAT

Para que los LLMs te tengan en cuenta, deben poder fiarse de ti y de tus contenidos. Y para ello, tienen muy presente lo que otros dicen de ti.

En el mundo SEO, Google lleva ya tiempo hablando y valorando el tema del EEAT. Ahora, con los modelos de lenguaje, este concepto cobra todavía más peso.

Por ejemplo, si ChatGPT ve que DinoRANK aparece en artículos de blogs de SEO, en comparativas de software, en podcasts de SEO local o en foros temáticos, seguramente asuma que es relevante cuando alguien pregunta por herramientas de SEO.

Por eso, necesitas tener presencia digital en aquellos lugares que el modelo considera contextualmente significativos para tu sector. De esa manera será más probable que te tome como fuente de autoridad, ya sea para usar tu contenido o para citarte en sus respuestas.

- Directorios especializados del sector.

- Foros o comunidades temáticas.

- Webs de nicho o blogs con autoridad.

- Entrevistas, podcasts, webinars.

- Redes sociales.

9. Actualiza tus contenidos con regularidad

A los LLMs les gusta la información fresca. Y más aún si están conectados a la web o utilizan sistemas de recuperación como RAG.

Piénsalo por un momento:

¿De qué le vale a un LLM un contenido que es igual que lo que ya tiene en su corpus? ¿O para qué quiere procesar un texto que ya está desfasado?

Por eso:

- Revisa al menos cada 6 meses los contenidos clave de tu web.

- Si haces un cambio relevante, actualiza la fecha de publicación o modificación.

- Añade nuevos ejemplos, estadísticas o capturas de pantalla actualizadas.

- Comprueba que los enlaces externos sigan funcionando.

De este modo es mucho más probable que un LLM confíe en ti como fuente para generar una respuesta.

10. Trabaja el SEO de tu sitio web

El LLMO no sustituye al SEO, sino que ambos se complementan.

Ya hemos visto que cuando el modelo no tiene datos actualizados sobre un tema utiliza el modo RAG para conectarse a Internet y consultar nuevas fuentes que le permitan complementar su información.

¿A qué sitios web crees que accederá en busca de esta nueva información?

Exacto, a los que estén mejor posicionados en los buscadores.

Debes tener en cuenta que la mayoría de los modelos de IA utilizan la API de Google o la de Bing para acceder a Internet, por lo que todas las estrategias SEO que conocíamos hasta ahora siguen estando vigentes.

Y por eso, si tu web no está optimizada para SEO es muy difícil (te diría que casi imposible) que consigas ser visible en las respuestas generadas por IA.

Preguntas frecuentes sobre el SEO en LLMs

¿Todavía hay aspectos sobre los LLMs y el concepto de LLMO que no te quedan demasiado claros?

No te preocupes, en este apartado vamos a intentar dar respuesta a las cuestiones más frecuentes que suelen hacerse los usuarios cuando se inician en este tema. Espero que despejen todas tus dudas.

¿Qué significa LLM en la IA?

LLM significa Large Language Model o, en español, Modelo de Lenguaje Grande (o de Gran Escala). Es el tipo de inteligencia artificial que hay detrás de herramientas como ChatGPT, Gemini, Copilot o Claude.

Todas ellas funcionan gracias a un LLM que ha sido entrenado con millones (o billones) de palabras para poder generar texto, responder preguntas o resumir contenido como si lo estuviera escribiendo una persona.

¿Cuáles son los principales modelos LLM?

Algunos de los LLMs más conocidos son:

- GPT-4, GPT-5 de OpenAI.

- Gemini 2.0, Gemini 2.5 de Google.

- Llama 3, Llama 4 de Meta.

- Claude Opus 4.1, Claude Sonnet 4 de Anthropic.

Quizá te extrañes de que no aparezca ChatGPT en esta lista. Te explico el porqué en la siguiente pregunta.

¿Qué es LLM en ChatGPT?

ChatGPT es un chatbot, es decir, la interfaz que permite a los usuarios interactuar con la IA de una manera sencilla. Por lo tanto, no es el modelo en sí, sino la aplicación para acceder a un modelo de lenguaje concreto. Por debajo, ChatGPT utiliza los LLMs de OpenAI para generar las respuestas, al igual que hace Copilot de Microsoft.

Por otro lado, la aplicación de Gemini usa los modelos de Google y Claude.ai utiliza los de Anthropic. En este caso, los responsables han decidido llamar a la herramienta de chat igual que a los modelos, pero no dejes que eso te confunda.

En cualquier caso, verás que en muchos artículos, por simplificar, no distinguen entre interfaz y modelo y hablan de ChatGPT como si fuera el LLM. Yo mismo lo he hecho así en algunos puntos de este artículo. Pero tú ya sabes diferenciarlos y eso te permitirá comprender mejor cómo utilizarlos.

¿Cómo se entrenan los LLMs?

El entrenamiento de un LLM es la etapa más compleja, larga y costosa de todo el proceso de aprendizaje.

Por simplificarlo bastante, podemos decir que este entrenamiento consta de dos fases:

- Una primera fase, llamada preentrenamiento, durante la que se alimenta al modelo con cantidades enormes de textos, para que aprendan patrones del lenguaje y sepan predecir qué palabras pueden venir después de otras.

- En la segunda fase hay un equipo humano que le enseña a responder mejor. Se le corrigen errores, se le premian buenas respuestas y, en definitiva, se va puliendo su comportamiento. Esta fase se llama RLHF (Reinforcement Learning from Human Feedback o Aprendizaje por Refuerzo con Retroalimentación Humana).

De este modo, al finalizar el entrenamiento, el modelo de lenguaje estará listo para empezar a responder las preguntas de los usuarios.

¿Por qué es importante el SEO para LLMs (o LLMO)?

Porque la manera de buscar en Internet está cambiando. Ya no es la misma que hace 5 años y ni siquiera igual que el año pasado.

Google, Bing o Yahoo ya no son los únicos protagonistas.

Ahora los usuarios formulan preguntas a sistemas basados en inteligencia artificial y obtienen respuestas directas mucho más ajustadas a su perfil e intereses.

Y si quieres que tus contenidos aparezcan en esas respuestas generadas por IA y seguir siendo relevante para esa masa de usuarios cada vez mayor que ya no se fía sólo de Google, te va a tocar optimizarlos, no solo para los algoritmos de búsqueda tradicionales, sino también para los modelos de lenguaje (LLMs) sobre los que operan todas estas herramienta de IA.

¿LLMO y GEO son lo mismo?

No, no lo son. Aunque es cierto que muchas veces se utilizan para referirse al mismo concepto, el SEO para IA, no se refieren exactamente a lo mismo.

GEO (Generative Engine Optimization) consiste en optimizar tu contenido para los motores generativos. Piensa en Perplexity, en las AI Overviews o en ChatGPT cuando se conecta a Internet. El objetivo es que tu web aparezca citada como fuente en las respuestas generadas por estas plataformas.

Sin embargo, el LLMO va más allá del motor de búsqueda. Aquí el objetivo es estar presente en cualquier respuesta generada por el modelo, aunque no haya una citación directa a tu web.

¿Cuál es la diferencia entre SEO tradicional y LLMO?

SEO y LLMO difieren tanto en su propósito como en la plataforma a la que se orientan.

El SEO tradicional se centra en los motores de búsqueda como Google o Bing. El objetivo es que tu web aparezca lo más arriba posible en el listado de resultados para conseguir el mayor número de clics.

En cambio, el LLMO trabaja la optimización de contenido para modelos de lenguaje. La idea es estar en la respuesta que da una IA cuando alguien pregunta algo, ya sea mediante una citación a la fuente, una mención a nuestra marca o una recomendación de nuestro producto, por ejemplo.

¿LLMO reemplaza al SEO?

No, a pesar de lo que muchas voces agoreras van pregonando.

LLMO y SEO son conceptos diferentes pero complementarios. Podríamos decir que LLMO es la evolución lógica del SEO, pero en ningún caso es una amenaza.

Porque, para que tus contenidos puedan formar parte de las respuestas de la IA, éstos deben ser relevantes, estar bien estructurados y responder a la intención de búsqueda de los usuarios.

¿No es eso lo que hemos trabajado desde siempre con el SEO?

Pues ahora todas esas técnicas siguen teniendo sentido, junto con otras como las que hemos visto en este post.

Además, Google sigue ahí, más vivo que nunca. Es cierto que la IA está ganando protagonismo, pero la realidad nos muestra que la cuota de mercado del buscador sigue siendo enorme.

Por lo tanto, haz SEO y haz LLMO. Si trabajas todas las vías que den visibilidad a tu negocio, éste tendrá muchas más posibilidades de éxito.

¿Qué es el archivo llms.txt? ¿Es importante utilizarlo?

El fichero llms.txt es una propuesta para poner, en la raíz de tu web, un documento que te permita guiar a los modelos de lenguaje sobre cómo deberían interpretar las secciones más relevantes de tu sitio.

Hoy por hoy es tan solo una convención práctica, con herramientas y guías apareciendo, pero todavía lejos de la adopción por gran parte de los proveedores de IA.

Es útil, sí, y no pierdes nada por utilizarlo. Sin embargo, aún no es un estándar universal ni mucho menos sustituye a otros ficheros clave como el robots.txt o el sitemap.xml.

¿Cómo puedo saber si mi web ya aparece en respuestas de IA?

Usa el módulo de SEO en LLMs de DinoRANK para ver el tráfico que recibes desde ChatGPT, Gemini, Copilot o Perplexity, entre otros, y activa su Tracking sobre LLMs para comprobar si tu marca aparece citada o mencionada en las respuestas a prompts concretos.

Te animo a probarlo con tu proyecto. Entra en DinoRANK, conecta tu cuenta de Google Analytics y configura los prompts que te interese controlar.

Así sabrás si ya estás saliendo en la IA y cómo evoluciona tu protagonismo en sus respuestas.

Checklist SEO para LLMs

Espero que ahora ya tengas bastante más claro qué es eso del LLMO y cómo puedes aplicarlo a tu proyecto.

En cualquier caso, para facilitarte todavía más las cosas, a continuación te dejo una recopilación de las mejores prácticas que hemos ido viendo para que las tengas más a mano.

- Organiza tus contenidos con títulos claros, usando <h2>, <h3>, etc.

- Pon en negrita las ideas importantes para que salten a la vista.

- Usa listas numeradas o con viñetas: facilitan muchísimo el escaneo.

- Explica las cosas con frases cortas, claras y sin rodeos.

- Evita los tecnicismos si no hacen falta.

- Organiza tus textos en preguntas y respuestas para dar un enfoque más conversacional.

- Responde justo debajo de la pregunta. Sin rodeos.

- Escribe como hablas: usa un lenguaje directo y natural.

- No te líes con párrafos eternos que no dicen nada.

- Menciona marcas, nombres conocidos o conceptos que cualquiera del sector reconozca.

- Emplea sinónimos, variantes, ejemplos. Dale contexto.

- Explica con ejemplos concretos, no con teorías.

- Añade experiencias reales, cosas que te hayan pasado a ti o a tu equipo.

- Cita fuentes fiables y menciona a personas que sepan de lo que hablan, para aumentar tu autoridad y confiabilidad.

- Si puedes, añade schema.org a tus contenidos.

- Asegúrate de que tu nombre (o tu marca) aparece en sitios donde debería estar: entrevistas, directorios, listados del sector, etc.

- Participa en podcasts, foros como Reddit y Quora o comunidades donde se hable de lo tuyo.

- Que hablen bien de ti en redes también ayuda.

- No dejes que tu contenido se quede desfasado: revísalo cada medio año como mínimo.

- No descuides el SEO.

- Y monitoriza siempre los resultados con una herramienta como DinoRANK.

Mi recomendación es que te imprimas esta lista y la tengas siempre a mano cuando trabajes la optimización de tu página web.

Si lo aplicas, poco a poco verás cómo tus contenidos no solo posicionarán en Google, sino que además tendrán muchas papeletas de aparecer en herramientas como ChatGPT, Gemini o Claude.

Y eso, en el momento actual, es un escaparate increíble que no deberías desatender.