Las visitas frecuentes que realizan los rastreadores de los motores de búsqueda a tu sitio web son una buena señal. Sin embargo, la forma en que éstos indexan tu web pueden generar algunos problemas.

Cuando un robot de Google, por ejemplo, empieza a analizar tu sitio web no sabe qué páginas son las que deseas posicionar, cuáles no, qué partes quieres mantener ocultas, etc.

Necesitas decirle cómo tratar las diferentes partes de tu sitio web a través de indicaciones llamadas meta-etiquetas; y para ello requieren de algo que hable su mismo idioma, como sucede con el archivo robots.txt.

¿Qué es robots.txt?

El archivo robots.txt es un documento de texto plano ubicado en el directorio raíz del servidor web que indica a los robots de los motores de búsqueda (también conocidos como “spiders” o “crawlers”) qué partes del sitio deben y no deben ser procesadas o indexadas.

Esto se hace especificando directivas que permiten o restringen el acceso a ciertas secciones del sitio.

Por ejemplo, es posible que quieras evitar que los motores de búsqueda indexen directorios específicos que contienen información sensible o irrelevante para los resultados de búsqueda, como paneles de administración, directorios de imágenes privadas, o versiones duplicadas de páginas.

Cómo funciona robots.txt

Los robots de los motores de búsqueda visitan este archivo antes de explorar el resto del sitio. Basándose en las instrucciones encontradas, deciden qué páginas rastrear y cuáles dejar de lado.

Las directivas fundamentales en un archivo robots.txt incluyen User-agent y Disallow.

- User-agent se refiere al robot de búsqueda específico al que se dirige la regla (por ejemplo, Googlebot para Google)

- Disallow indica qué páginas o directorios no deben ser rastreados.

- Allow, utilizada menos frecuentemente, permite el acceso a contenido en directorios que de otro modo estarían bloqueados.

User-agent: *

Disallow: /privado/

Disallow: /temp/

Allow: /publico/

En este ejemplo, todas las páginas bajo los directorios “/privado/” y “/temp/” están prohibidas para todos los robots, mientras que el acceso al directorio “/publico/” está permitido.

Es importante destacar que el archivo robots.txt es una solicitud de cortesía a los motores de búsqueda, no una barrera infalible.

Los motores de búsqueda respetuosos siguen las instrucciones, pero los robots malintencionados pueden ignorarlas. Además, aunque un archivo robots.txt puede restringir el rastreo, no garantiza la privacidad; las URL restringidas aún pueden ser indexadas si otros sitios web las enlazan.

¿Por qué debes tener un archivo Robots.txt?

Los archivos robots.txt controlan el acceso del rastreador a ciertas áreas de un sitio; aunque esto puede ser peligroso si por accidente no permites que Googlebot rastree toda la web.

Hay algunas situaciones en las que un archivo robots.txt puede ser muy útil, como por ejemplo:

- Evitar que aparezca contenido duplicado en las SERPs (ten en cuenta que los meta robots a menudo son una mejor opción para esto).

- Mantener en privado secciones enteras de un sitio web (por ejemplo, el sitio de preparación de tu equipo de ingeniería).

- Evitar que las páginas de resultados de búsquedas internas aparezcan en las SERPs.

- Especificar la ubicación de los sitemaps.

- Evitar que los motores de búsqueda indexen ciertos archivos en tu sitio web (imágenes, archivos PDF, etc.).

- Especificar un retraso de rastreo para evitar que tus servidores se sobrecarguen cuando los rastreadores cargan múltiples partes de contenido a la vez.

Si no tienes áreas en tu web a las que quieras controlar el acceso, es muy posible que no necesites un archivo robots.txt.

Parámetros que debes conocer

Antes de comenzar, debes saber que hay una serie de comandos que debes conocer para poder crear tu propio robots.txt. Son los siguientes:

- User-agent: Específica a qué robot afectarán todas las indicaciones que pongas debajo de éste.

- Disallow: Indica al bot que el contenido está bloqueado y no queremos que lo rastree.

- Allow: Permite el rastreo y se usa para hacer alguna excepción del caso anterior.

- Sitemap: le dice al bot dónde está el sitemap de tu página.

- Crawl-delay: indica unos segundos de retardo entre cada página escaneada.

Para crear un archivo robots.txt utiliza Notepad, Notepad++ o Bloc de notas. No necesitas nada complejo. También puedes editar o crearlo a través de tu plugin de SEO, como Yoast o All in One SEO Pack.

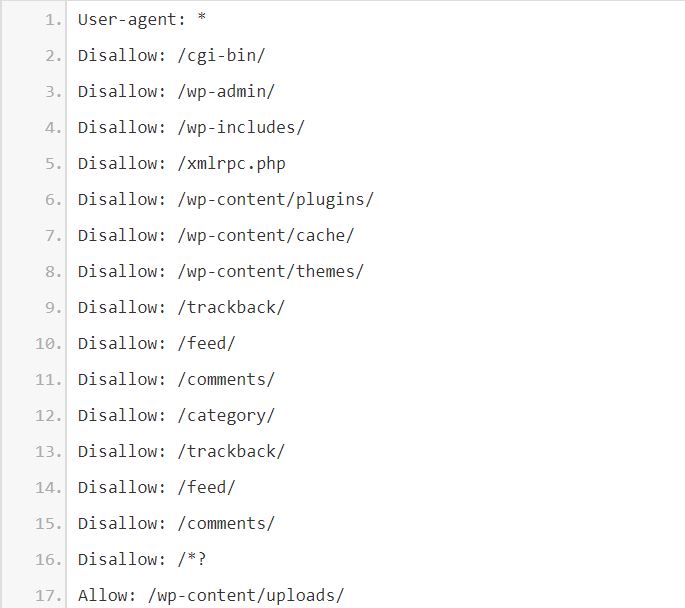

Cómo crear un robots.txt optimizado para el SEO (para WordPress)

Ahora que sabes qué es y lo importante que es un archivo robots.txt, vamos a crear un robots.txt optimizado para SEO, pero para el CMS WordPress, que es el que utilizamos casi todos.

Aquí no veremos en profundidad todo sobre un robots.txt, porque se necesita mucho espacio y tiempo. Simplemente nos centraremos en redactar una guía de cómo crear uno optimizado para SEO.

Una vez tengas abierto tu procesador de texto. Comenzamos.

#1 Cosas a bloquear en tu robots.txt

Lo primero es decirle a qué robot deseamos indicarle instrucciones y cuáles son.

Quedaría así:

Como las indicaciones son a cualquier agente, se coloca *. Si fuese a alguno concreto, se pondría el nombre, por ejemplo, Googlebot.

Abajo, la indicación de disallow está con una “/”, que indica a todo el sitio.

Existen algunos archivos y directorios en el sitio de WordPress que deberían estar bloqueados desde el inicio. Los directorios a los que se debe rechazar el acceso en el archivo robot.txt son el directorio “cgi-bin” y los directorios estándar de WP.

Las directivas utilizadas para lo anterior son estas:

#2 Bloqueos de acuerdo con tu configuración de WordPress

Debes saber cómo utiliza tu WordPress las etiquetas o categorías para estructurar el contenido.

Si estás utilizando categorías, debes bloquear los archivos de etiquetas de los motores de búsqueda y viceversa.

En primer lugar, comprueba la base, para ello accede al Panel de administración> Configuración> Permalinks.

De forma predeterminada, la base es una etiqueta si el campo está en blanco. Debes deshabilitar la etiqueta en el robot.txt como se indica a continuación:

- Disallow: /tag/

Si no estás utilizando la categoría, debes bloquearla en el robot.txt como se indica a continuación:

- Disallow: /category/

Si estás utilizando ambas, categorías y etiquetas, entonces no tienes que hacer nada en el archivo robot.txt.

Si no usas etiquetas ni categorías, bloquea ambas en robot.txt como se indica a continuación:

- Disallow: /category/

- Disallow: /tag/

#3 Bloquear archivos de WordPress

Se usan diferentes archivos en WordPress para mostrar el contenido, que no necesitan estar disponibles para los motores de búsqueda.

Así que también tienes que bloquearlos. Los diferentes archivos utilizados para mostrar el contenido son archivos PHP, archivos JS, archivos INC, archivos CSS, etc.

Tienes que bloquearlos en el robot.txt como se indica a continuación:

#4 Bloqueo de spam y otros

Hasta ahora ya has creado un robots.txt bueno para SEO, en el que has bloqueado todo lo que no sirve y has dejado solo artículos, páginas, categoría e imágenes disponibles para los buscadores.

Pero el archivo robots.txt sirve para mucho más que eso; pues te protege de bots que solo rastrean tu contenido, te roban tu estrategia o arquitectura y utilizan tus recursos sin aportar nada en absoluto.

Echa un vistazo a la lista completa de esos bots aquí.

#5 Guardar y subir el Archivo

Guarda el archivo robots.txt y súbelo al directorio raíz de tu sitio web (por ejemplo, www.tusitio.com/robots.txt) para que los motores de búsqueda puedan encontrarlo y aplicar tus directivas.

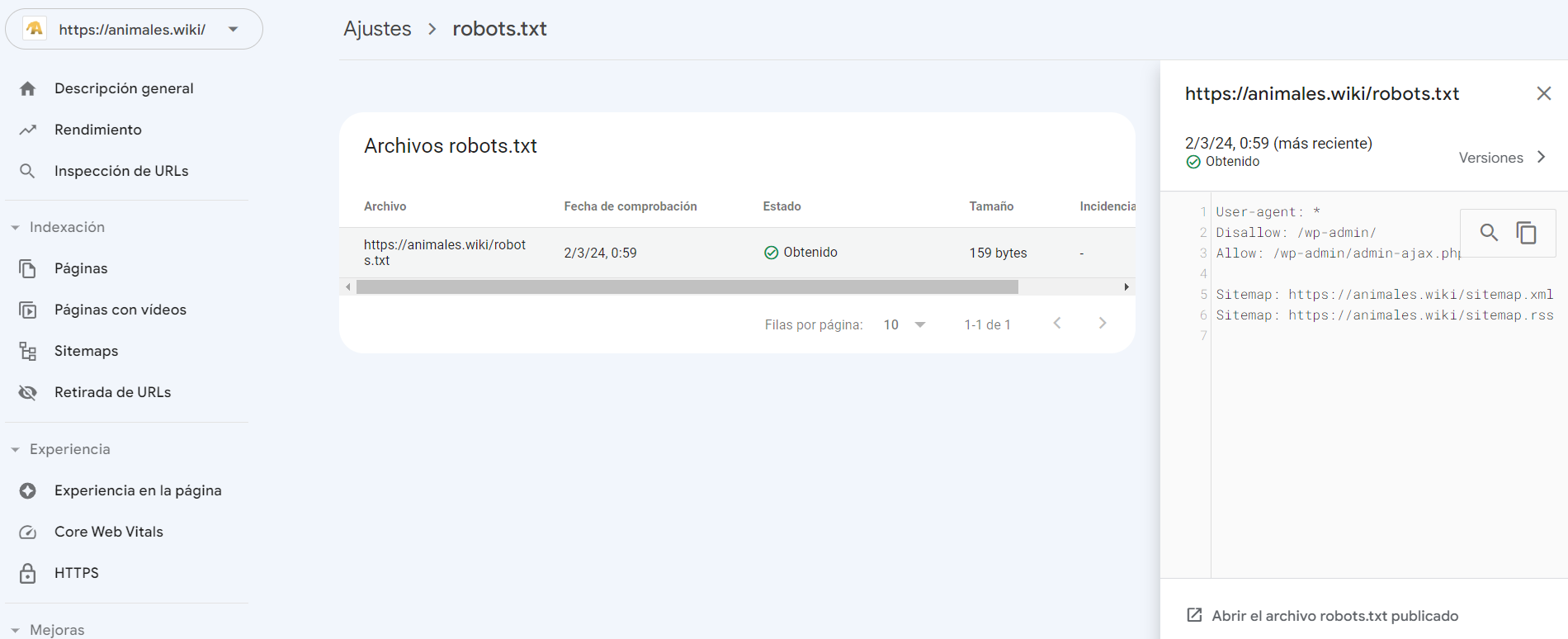

#6 Testea tu robots.txt

Una vez que hayas reunido todo lo anterior en un solo archivo y hayas añadido tus propias reglas, llega el momento de probar el archivo. No vaya a ser que bloquees lo que no debas.

Lo primero que debes hacer es dar de alta tu sitio en Google Search Console. Una vez que hayas seguido todos los pasos (si tienes dudas visita este enlace) utiliza el probador de robots.txt.

Para ello sube el archivo robots.txt que has creado y ejecútalo como si fueses Google.

Allí podrás ver los posibles errores; ahora, si todo está bien, súbelo a tu sitio web.

Este archivo debes mantenerlo actualizado e ir añadiendo, por ejemplo, los cambios que pueda haber en WordPress, nuevos sitios que te hagan spam de comentarios, en tus analíticas o en las mismas directrices de Google, etc.

Errores comunes en robots.txt y cómo evitarlos

Aunque el archivo robots.txt es una herramienta poderosa, un mal manejo puede llevar a errores que afecten negativamente tu SEO.

Aquí algunos errores comunes y cómo evitarlos:

- Bloquear contenido importante: Evita usar reglas Disallow en páginas que deseas que sean indexadas. Esto parece obvio, pero es fácil bloquear accidentalmente páginas importantes al hacer cambios en el archivo robots.txt.

- Sintaxis incorrecta: Errores de sintaxis como un espacio faltante después de “Disallow:” pueden hacer que la regla no funcione. Asegúrate de seguir la sintaxis correcta y revisa tu archivo cuidadosamente.

- Uso incorrecto del carácter comodín *: El carácter comodín * puede ser útil, pero su uso incorrecto puede llevar a bloquear más contenido del deseado. Entiende cómo funciona antes de implementarlo.

- Confundir Disallow con Noindex: Disallow previene el rastreo de una página, pero no necesariamente su indexación. Si un enlace externo apunta a una página restringida por Disallow, aún puede aparecer en los resultados de búsqueda. Para evitar la indexación, considera usar la etiqueta noindex en el HTML de la página.

- No actualizar el archivo robots.txt: El contenido del sitio y las estrategias SEO evolucionan, así que tu archivo robots.txt también debería hacerlo. Revisa y actualiza tu archivo regularmente para asegurarte de que sigue siendo relevante y efectivo.

Ejemplo de robots.txt

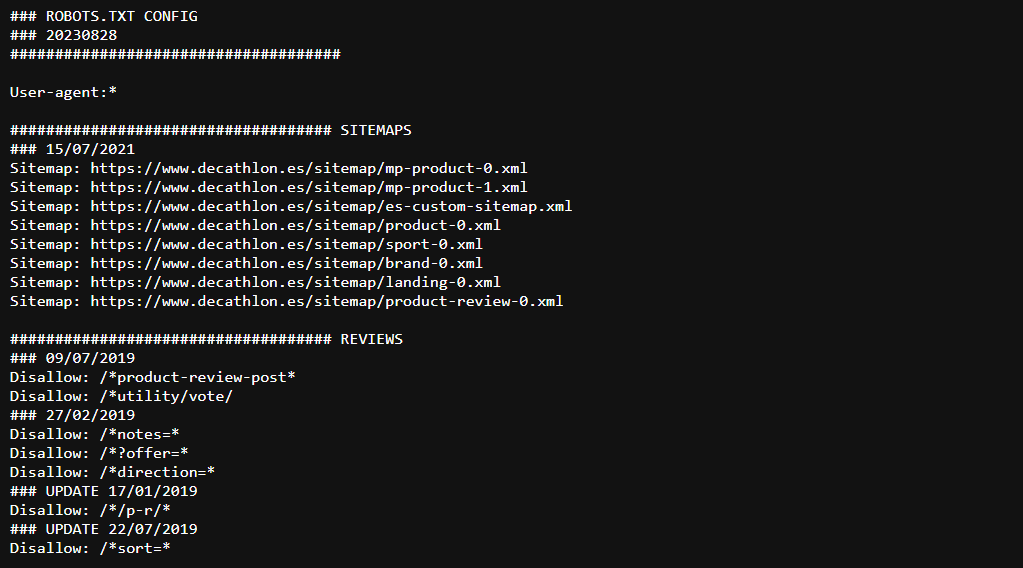

Para finalizar, y aunque ya has aprendido cómo hacer tú mismo un archivo robots.txt, te dejamos un ejemplo ya hecho, para que tan solo cambies determinados datos que aparecen por los tuyos.

Analiza y cuida bien qué hace este archivo, porque su rendimiento es diferente según las características de tu servidor y tu página web.

Aquí tienes el ejemplo de robots.txt listo para utilizar.

Recuerda que, tener un archivo robots.txt en tu sitio web ayudará a que los robots de rastreo sepan interpretar mejor las partes de la web y se centren en lo que de verdad tiene importancia.

Daniel Crespo Flórez

Excelente explicación para un tema delicado que hay que hacer bien. Veo que no añades Disallow: /wp-admin/ y Disallow: /wp-login.php. Cual es la razón? En nuestra página Search Console nos reporta error(5xx) a páginas con la extensión/wp-login.php? Un saludo.

Edu Coromina

Gracias por comentar Daniel.

Puedes incluir ambos en tu archivo de robots.txt sin problema, aunque no es que estés dejando de optimizar por no hacerlo. Un problema común de usar WordPress es que a veces puede generar páginas o extensiones a un gran número de URLs provocando thin content y/o contenido duplicado, es por ello que además de replicar el robots.txt que tienes de ejemplo, es necesario personalizarlo en algunos aspectos; especialmente para un ecommerce con por ejemplo filtros.

Un saludo.

Pedro

Hola Edu, muchas gracias por él artículo, está genial!!

Tengo una duda…. he analizado mi woocommerce con Dinorank y me sale que está indexando los filtros (color, talla…) y además se le esta derivando linkjuice a todas estas páginas, tengo instalado Rank Math pero no veo como arreglar esto.

Edu Coromina

Gracias Pedro 🙂

Para los filtros yo usaría el bloqueo por robots.txt, aquí te dejo con un ejemplo de algunos filtros a bloquear:

Disallow: /*?orderby=

Disallow: /*?min_price=

Disallow: /*?max_price=

*Ten en cuenta que según la naturaleza de tu ecommerce, puede haber unos filtros u otros pero el formato siempre es el mismo.

Un saludo!

leonardo

Hola Edu muchas gracias por el post, tengo una duda sobre robots que escuche en youtube y decia algo asi como que es mejor no tener nada porque google entra si o si a todo el sitio y al no darle los permisos en un robots era perjudicial porque era como negarle la entrada al bot de google y generaba malos resultados o posicion al sitio, que tiene esto de cierto para este año 2020? muchas gracias

Edu Coromina

Hola Leonardo!

Ciertamente el archivo robots.txt tiene que manejarse con cuidado, y aconsejo hacerlo especialmente en ecommerce mediano/grandes para bloquear filtros o URLs autogeneradas. Es un archivo delicado y a veces la gente utiliza una “plantilla” del robots.txt cuando siempre debe personalizarse a las necesidades de cada uno.

Otro factor importante es no bloquear por robots.txt URLs o secciones que sin embargo aparecen en el sitemaps, así como entender la pérdida de linkjuice de ciertas URLs que puedan apuntar a URLs bloqueadas por dicho archivo.

También sirve como una forma de bloquear bots de herramientas como Screaming Frog o Netpeak Spider de ojos curiosos.

Si las directrices se configuran bien, el archivo robots.txt no perjudica.

Un abrazo!