En este artículo te vamos a enseñar cómo configurar el robots.txt de WordPress para que el googlebot y otros bots de rastreo solo tengan acceso a las partes de tu sitio web que tú quieras.

Con todo, tienes que tener en cuenta que esto solo es válido para bots como el de Google que se atienen a las normas y solo rastrean lo que tienen permitido, ya que hay otras arañas; las más ‘rebeldes’, que no hacen ningún caso al robots.txt.

En cualquier caso, para lo que sí que es siempre eficiente es para dar permisos a googlebot para acceder a tu sitio web y de manera efectiva poder restringir las carpetas o URLs en la que el robot de Google tenga acceso.

👉 Pero sobre todo sirve para señalarle al agent googlebot que partes queremos que rastree y posicione en los motores de búsqueda y cuales no, con todo lo que esto implica a efectos de SEO.

Por este motivo, configurar y optimizar el robots.txt en tu sitio web resulta muy aconsejable, aunque algunos usuarios sin muchos conocimientos de programación puedan tener sus reservas por miedo a pifiarla.

Pero tranquilo, en este artículo te vamos a enseñar distintas alternativas para hacerlo de manera sencilla.

Además, te vamos a mostrar que el robots.txt no solo sirve para bloquear el acceso a determinados sitios, sino que también puede utilizarse para establecer qué bots o arañas pueden entrar (siempre dentro del segmento de los que hacen caso), así como para limitar la velocidad de navegación de este tipo de “intrusos”.

Aspectos clave a la hora de configurar el robots.txt de WordPress

La sintaxis del robots.txt es sencilla, tiene pocos parámetros y además se pueden configurar fácilmente a poco que se sepa cómo operan los bots y arañas.

Un parámetro esencial en el robots.txt es el sitemap, ya que permite indicar al googlebot como se estructura nuestro sitio web y las partes a las que puede acceder y a las que no, al tiempo que sirve asimismo para bloquear el acceso a otros bots y arañas maliciosas.

Junto, al sitemap (o sitemaps ya que pueden configurarse varios) otros parámetros clave en la configuración del robots.txt son:

- disallow: mediante el uso de una barra ‘/’ puede bloquearse el acceso a todo el sitio web, o bien una ruta específica utilizando comodines *

- allow: en vez de para restringir sirve para permitir, empleándose para añadir excepciones a un disallow

- user-agent: muy importante, ya que posibilita establecer a quienes afectan los allow y disallow. Así, cualquier configuración de robots. txt debe tener al menos el user agent de googlebot si no quieres condenar tu página al ostracismo cuando los usuarios hagan sus búsquedas en google search. En este enlace tienes todos los posibles user-agents con los que te puedes encontrar.

- Por último, el parámetro crawl-delay en teoría permite concretar el intervalo de tiempo entre página y página de las revisiones del user agent de googlebot y otros bots de rastreo, pero ni siquiera la araña de Google lo tiene en cuenta…

Tanto si ya tienes clientes como si quieres conseguirlos, en SEO no puedes quedarte atrás.

Apúntate a esta newsletter, donde recibirás un curso gratis para mejorar tus habilidades como consultor SEO, además de 2 clases Gratuitas de nuestro Máster de SEO.

Cómo modificar el archivo robots.txt con un plugin

Puedes crear o modificar el archivo.txt mediante FTP accediendo al servidor, o bien de forma más sencilla optar por configurar el robots.txt de WordPress directamente desde un plugin, como por ejemplo el Yoast SEO o el All in One SEO

Estos plugins cuentan con módulos especiales para hacer cambios de este archivo desde el mismo panel de administración. De modo que teniendo cualquiera de estos sería innecesario instalar otros.

Con todo, si te manejas con otro CMS o simplemente quieres probar, otras buenas opciones de plugins son txt rewrite, Virtual Robots y WordPress Robots.

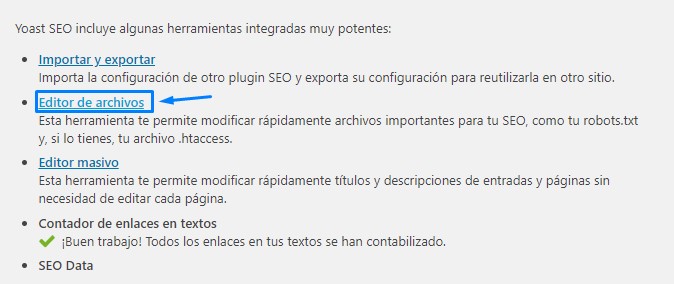

El modo más sencillo de modificar el archivo robots.txt es mediante Yoast SEO.

- Una vez que instales y actives el plugin, busca la opción ‘Editor de archivos’ en la pestaña ‘SEO > Herramientas‘ de tu escritorio.

- Al clicar en ese enlace te dirigirá a una nueva página, donde podrás editar tu archivo .htaccess sin salir del escritorio. Y para crear uno nuevo es tan sencillo como pinchar en el botón que te aparece de ‘Crear archivo robots.txt‘. En un nuevo editor podrás hacer las modificaciones que quieras directamente, aunque debes tener en cuenta que las reglas de funcionamiento de Yoast SEO anulan las del archivo robots.txt virtual anterior.

- Por último no olvides dar al botón de guardar cambios en robots.txt cada vez que añadas o suprimas una regla.

Cómo modificar robots.txt desde Search Console

Tienes la posibilidad tanto de modificar el robots.txt desde Search Console como de probar cómo funciona, para esto último debes entrar en tu cuenta de la herramienta ir a ‘Rastreo’ y una vez allí seleccionar la opción probador de robots.

Guía paso a paso para configurar mediante FTP el archivo robots.txt de WordPress en 2020

Para crear el archivo robots.txt en un sitio web usando el FTP en vez de un plugin tienes que tener en cuenta aspectos importantes como la necesidad de dominar los estándares de sintaxis:

- Un único disallow o allow por línea.

- Nombre del archivo siempre en minúsculas.

- Símbolos para crear patrones y comodines.

- Uso correcto de espacios.

Igualmente, aunque configures el robots.txt resulta recomendable utilizar los atributos de nofollow o noindex para bloquear las arañas o crawlers que no quieras que accedan.

¿Dónde está el archivo robots.txt en WordPress?

Al crear un sitio web en WordPress automáticamente se configura un archivo robots.txt en la carpeta principal del servidor. El código que te aparece por defecto es:

[php]user-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

[/php]Donde pone * habría que añadir tu sitemap, si pongamos por caso tu dominio es http://misitioweb.com, el sitemap sería : http://misitioweb.com/sitemap.xml

Siguientes pasos para configurar robots.txt desde FTP

Seguidamente, guardas el archivo en la computadora y te conectas a tu sitio web a través de FTP. Cuando ya estés conectado, en la carpeta public_html cargas tu archivo robots.txt.

Una vez que hayas generado y subido tu archivo robots.txt de WordPress, puedes utilizar Google Search Console para probarlo y ver si tiene errores, ya que es una de las funcionalidades que ofrece el menú de ‘rastreo’ es la pestaña de probador de robots.txt que mencionamos anteriormente.

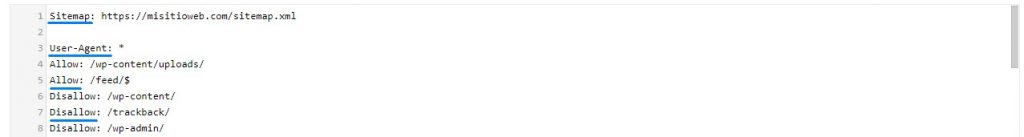

Ejemplo de un robots.txt en WordPress bien configurado

Si el dominio de tu web fuese https://misitioweb.com, este sería un robots. txt para WordPress bien configurado:

[php]Sitemap: https://misitioweb.com/sitemap.xml

User-Agent: *

Allow: /wp-content/uploads/

Allow: /feed/$

Disallow: /wp-content/

Disallow: /trackback/

Disallow: /wp-admin/

Disallow: /feed/

Disallow: /?s=

Disallow: /search

Disallow: /*?

Disallow: /*.php$

Disallow: /*.js$

Disallow: /*.inc$

Disallow: /*.css$

Disallow: */feed/

Disallow: */trackback/

Disallow: /page/

# No indexar copias de seguridad

Disallow: /*.sql$

Disallow: /*.tgz$

Disallow: /*.gz$

Disallow: /*.tar$

Disallow: /*.svn$

# Reglas para bots conocidos

User-agent: Googlebot

User-agent: Googlebot-Image

Disallow: /wp-includes/

Allow: /wp-content/uploads/

User-agent: Mediapartners-Google*

Disallow:

User-agent: ia_archiver

Disallow: /

User-agent: duggmirror

Disallow: /

User-agent: noxtrumbot

Crawl-delay: 50

User-agent: msnbot

Crawl-delay: 30

User-agent: Slurp

Crawl-delay: 10

User-agent: MSIECrawler

Disallow: /

User-agent: WebCopier

Disallow: /

User-agent: HTTrack

Disallow: /

User-agent: Microsoft.URL.Control

Disallow: /

User-agent: libwww

Disallow: /

[/php]