Si quieres posicionar tu página en los resultados de búsqueda, deberías conocer cuáles son los últimos cambios que ha realizado Google en su algoritmo y saber cómo ha evolucionado su motor de búsqueda con el paso del tiempo.

Así sabrás cómo plantear tu estrategia SEO, ya que en la información que nos da su algoritmo vas a encontrar las directrices sobre qué hacer para mejorar tus rankings en el buscador.

En este post te vamos a contar cuáles son los algoritmos de Google a los que debemos prestar atención actualmente para poder realizar una estrategia SEO segura y efectiva.

¿Qué es el algoritmo de Google?

El algoritmo de Google es un conjunto de fórmulas matemáticas según las cuales se calcula la posición de una URL en los resultados de búsqueda de Google para cada keyword, en base a unos determinados parámetros.

Podría parecer que conociendo el algoritmo es fácil seguir una especie de “hoja de ruta” para llevar a cabo acciones SEO, pero aquí viene lo complicado:

Un algoritmo puede cambiar más de 10 veces al año y ni siquiera por completo, sino en los pequeños algoritmos independientes que contiene dentro de sí mismo.

Por ello, no debemos perder la cabeza: procura adaptarte sobre todo a los grandes cambios de los algoritmos.

¿Cómo funcionan los algoritmos de Google?

Los algoritmos de Google comienzan a funcionar desde el momento en el que el usuario hace una búsqueda. Una vez que lo ha hecho, el funcionamiento es el siguiente:

Ahora es el momento en el que el algoritmo entra en acción, puesto que hará uso de sus fórmulas matemáticas y demás factores para confeccionar las páginas de resultados de búsqueda que va a mostrar al usuario.

De esta forma, posiciona las distintas páginas que pueden ofrecerle la respuesta que necesita, priorizando aquellas que mejor satisfacen la intención de búsqueda del usuario.

Recomendaciones básicas para hacer un SEO efectivo y seguro

Es difícil saber cómo afectan los cambios de algoritmo al posicionamiento en Google, ya que desconocemos con exactitud cuáles son esos datos relevantes que tiene en cuenta y cómo los calcula para determinar la posición de una URL en las SERP’s o páginas de resultados.

Por este motivo, no sirve de nada que te obsesiones tratando de averiguar cómo funcionan exactamente estas fórmulas matemáticas para que afecten de forma positiva a tu posicionamiento SEO.

- Ofrecer un buen contenido al usuario que responda a su intención de búsqueda.

- Conseguir enlaces de calidad.

Además, existen otros factores que siempre debes tener en cuenta como el tiempo de carga de la web, una buena estrategia de palabras clave y una adecuada arquitectura web, que ayude a Google a comprender tu página.

¿Qué hacer si el cambio de algoritmo te ha hecho bajar posiciones?

Es muy común que cuando llega una de estas actualizaciones del algoritmo de Google, varias de tus páginas experimenten caídas de posición y tráfico de forma repentina.

Lo mismo puede ocurrir al contrario, haciendo que te lleves una grata sorpresa.

¿Mi consejo ante esta situación? Que no cunda el pánico. Eso ante todo.

Si al analizarlas, ves que todo el SEO de dichas URL’s está correcto y siguen las directrices que marca el nuevo Update, lo más probable es que Google esté probando varias cosas, pero no haya nada definitivo aún.

Por lo tanto, mi consejo es que esperes unos días o semanas a que todo vuelva a su cauce.

Y en el caso de que se mantengan igual, realiza un análisis más en profundidad en busca de fallos técnicos o similares.

¿Cuánto se tarda en recuperar el posicionamiento perdido tras una actualización?

Google suelen implementar actualizaciones significativas de su algoritmo cada varios meses.

Si alguno de tus contenidos ha bajado posiciones en el ranking con respecto al posicionamiento que tenían antes del Update, puede que no mejores posiciones hasta la próxima actualización significativa, siempre que hayas mejorado y optimizado ese contenido para cuando se lance la siguiente actualización.

Eso sí, ten en cuenta que no todas las mejoras del algoritmo de Google son “Core Updates”, es decir, actualizaciones mayores.

A lo largo del año, el buscador también implementa actualizaciones a menor escala. Por tanto, como webmaster, SEO o creador de contenido, tienes la esperanza de que éstas te ayuden a mejorar ligeramente el posicionamiento que puedas haber perdido.

Google no te asegura que, aún realizando mejoras sustanciales a las URL’s que han bajado posiciones en tu sitio web, tus resultados obtengan una subida en su ranking de resultados de búsqueda.

Si existen contenidos que aportan más valor y son de mayor calidad que el tuyo, los posicionará por encima tuya.

Último Core Update de Google en 2024

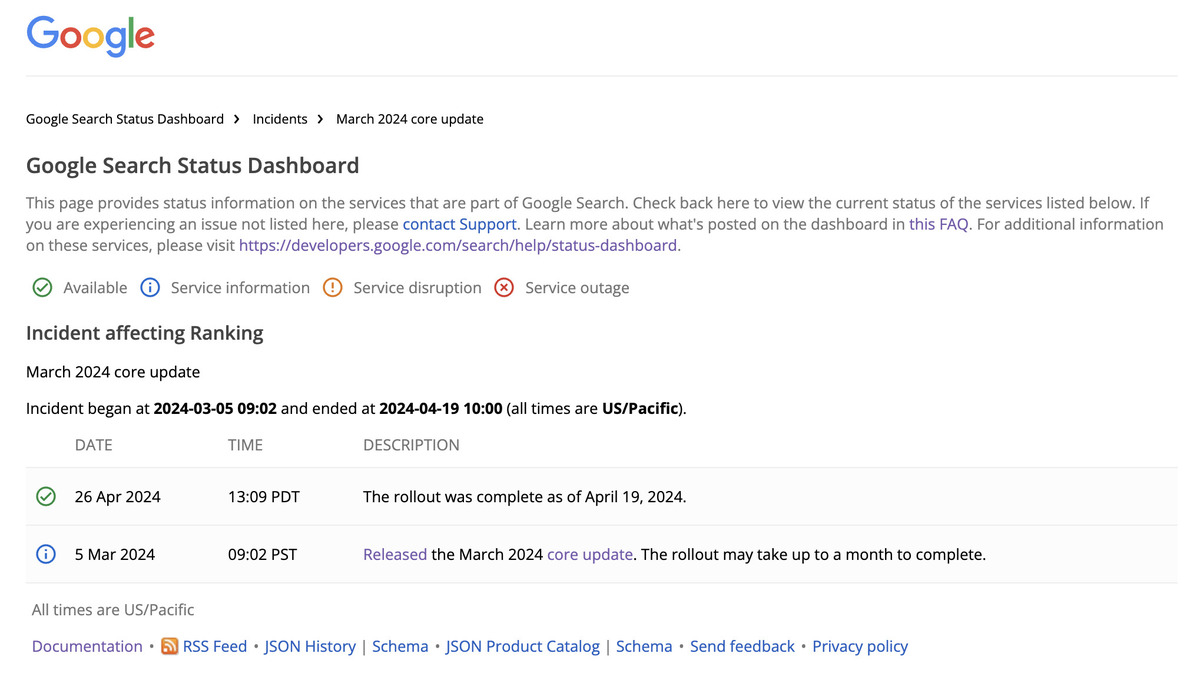

El pasado 5 de marzo de 2024, Google anunció una nueva actualización de su algoritmo a gran escala, con el fin (una vez más) de depurar y afinar aún más sus directrices para ofrecer los resultados más útiles posible para el usuario.

Y digo “a gran escala”, porque realmente el buscador está en continua renovación y en constante mejora.

Este Update tardó en desplegarse por completo más de un mes, concretamente hasta el 19 de abril, como indica su panel de control de estados oficial.

Y como de costumbre, Google no es demasiado explícito con sus indicaciones, aunque principalmente pretende priorizar aquellos sitios donde prevalezca la:

- Calidad

- Relevancia

- Originalidad

Estos tres factores ahora serán más importantes que nunca para tener un mejor posicionamiento orgánico con tu sitio web.

Yendo más al detalle, los puntos donde Google ha hecho más énfasis en esta actualización de su algoritmo son estos:

Reducción del contenido de baja calidad

El enfoque principal es disminuir el contenido de de poca o nula calidad (lo que en SEO llamamos Thin Content) y no original en los resultados de búsqueda.

Google ha desindexado en torno a un 45% de contenido de este tipo, ya sea poco útil, repetitivo o generado en masa, da igual si ha sido creado por humanos o mediante Inteligencia Artificial generativa.

Evolución en la identificación de contenidos útiles

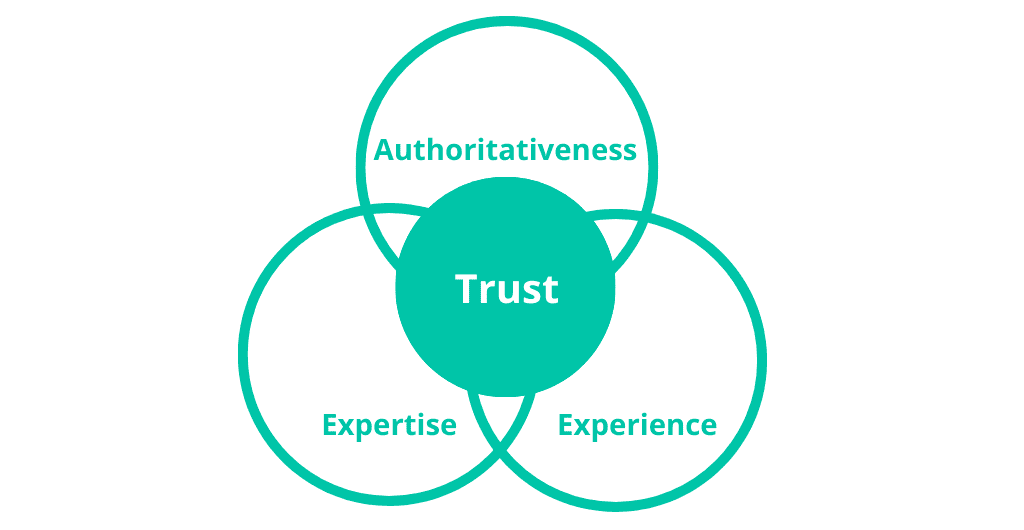

Este Core Update refina cómo Google identifica los contenidos útiles y mejora la clasificación de todas aquellas páginas web según su experiencia, conocimiento, autoridad y confianza.

Por tanto, tras esta actualización del algoritmo de Google, se hace más necesario que nunca trabajar y potenciar el EEAT de tu web.

Mejoras en la experiencia del usuario

Se han implementado cambios en varios componentes del sistema central, incluyendo una actualización en los Core Web Vitals, que ahora utilizan la métrica INP (Interaction to Next Paint) en lugar de FID (First Input Delay) para medir la interactividad de las páginas.

Spam Update de marzo de 2024

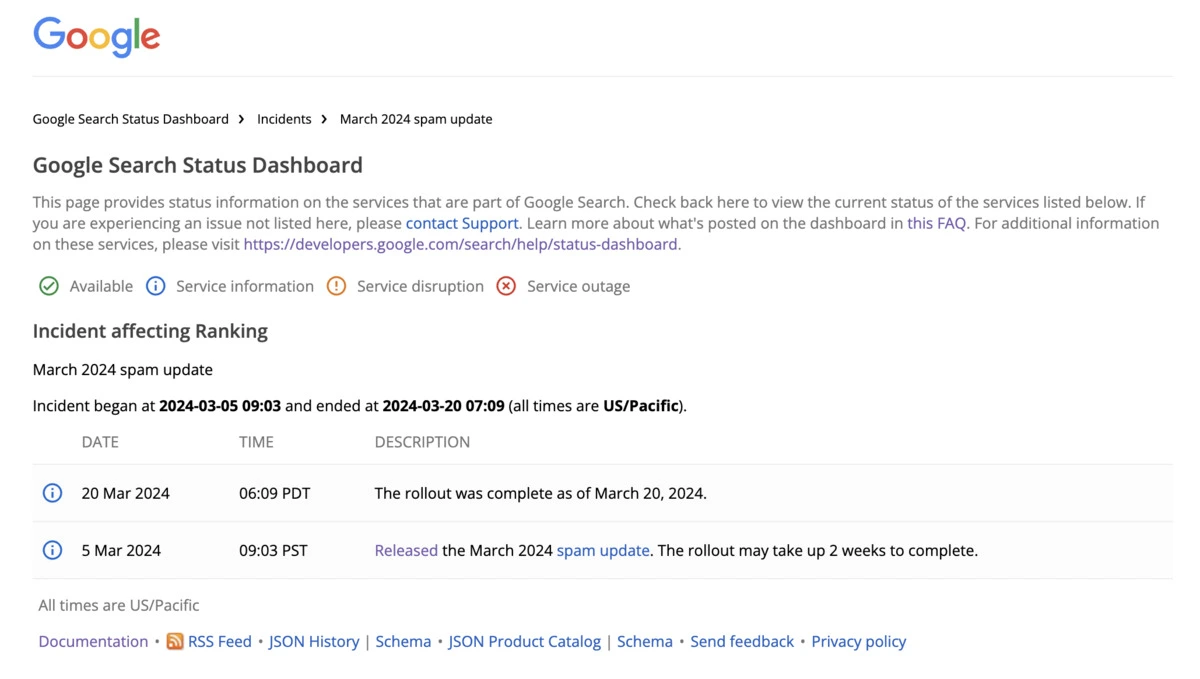

El mes de marzo vino cargado de novedades para los webmasters y SEO’s, ya que Google desplegó otra actualización de su algoritmo, pero esta vez diseñado para mejorar la calidad de los resultados de búsqueda al atacar prácticas engañosas y spam.

Los puntos que atacó fueron principalmente estos:

Abuso de dominios expirados

Google ha introducido políticas más estrictas contra el abuso de dominios expirados y la publicación de contenido de baja calidad en sitios de terceros.

Todo ello con el fin de evitar la manipulación de los rankings de búsqueda, al igual que te mencionaba en algunos de los factores anteriores.

Abusar de contenido mediocre a gran escala

La actualización también se dirige a sitios que crean contenido en masa, con el fin de manipular los rankings de búsqueda.

¿Y qué ha hecho Google en respuesta a esto? Penalizar tanto a los contenidos generados de forma automática como a aquellos creados por personas, si su objetivo principal es precisamente ese: manipular los rankings para mejorar su posicionamiento en buscadores.

Alojar contenido de baja calidad de terceros en una web reputada

El buscador afirma que no ve con malos ojos que una web aloje contenido de terceros.

Pero en ocasiones se aprovecha la alta autoridad del dominio para posicionar de forma orgánica para keywords competidas, sin que sea un contenido de calidad o del puño y letra de un experto en la temática.

Un ejemplo podría ser el de una marca que pagase a un periódico digital (sitio con alta autoridad) por tener una sección donde poder publicar contenidos de baja calidad, que no sigan las directrices del propio medio de comunicación.

Tanto si tu web no aparece en el buscador, como si quieres hacerla subir en sus rankings, no puedes quedarte atrás.

En DinoRANK tenemos una newsletter donde recibirás un curso gratis por email para mejorar tus habilidades como consultor SEO, junto a 2 clases Gratuitas de nuestro Máster de SEO.

Core update de Google en 2023

En marzo Google anunció una nueva actualización del núcleo centrada en el contenido y que no implica penalizaciones pero sí mejoras para las web que cumplan con las condiciones.

Afectó en especial a Google Discover y otras funciones del buscador como los fragmentos destacados, que han experimentado novedades y mejoras desde entonces.

Si tu estrategia depende del marketing de contenidos tienes que estar atento a este tipo de algoritmos.

Actualizaciones del algoritmo de Google en 2022

A lo largo del año 2022 hubo varios update de Google que tuvieron un notable impacto en varias webs.

- Febrero de 2022: se lanzó una actualización basada en la experiencia de navegación del usuario haciendo hincapié en factores como tener el protocolo https activado y la ausencia de elementos intrusivos en la web como, por ejemplo, demasiados anuncios emergentes.

- Marzo de 2022: se produjo otro update que permite a Google identificar los productos de calidad que hay a la venta para mostrárselos a los usuarios en los resultados de búsqueda, quitando visibilidad a los de baja calidad. Las reseñas adquirieron mucha importancia en este momento para los ecommerce.

- Mayo de 2022: se produjo una actualización del núcleo para optimizar los resultados de búsqueda y hacer que sean más relevantes para el usuario.

- Julio de 2022: se hicieron algunos ajustes a la actualización de productos de mayo, favoreciendo a las reseñas de calidad que muestran que el usuario realmente ha interactuado con el producto o servicio por encima de las que no aportan información o son falsas.

- Agosto de 2022: saltó la actualización de contenido útil para potenciar el contenido que se hace pensando en los usuarios y no solo en SEO y posicionamiento.

Actualizaciones de Google durante 2021

Durante el mes de mayo de 2021 llegó la actualización Google Page Experience que introdujo las Core Web Vitals, indicadores que sirven para medir la experiencia del usuario en base al tiempo de carga de la web, la estabilidad visual, la compatibilidad con dispositivos móviles o la accesibilidad.

En junio hubo otro update core que vino seguido en julio por una actualización que penalizaba las webs con enlaces spam y todo lo relacionado con el intercambio y compra-venta de links.

Por último, en agosto hubo otra actualización de contenido útil para optimizar los resultados de búsqueda.

Qué algoritmos SEO fueron relevantes en 2020-2021

Puedes hacer un seguimiento de los cambios y actualizaciones de los algoritmos de Google para estar al corriente y saber en qué momento necesitas realizar alguna acción en tu página web para seguir apareciendo en las páginas de resultados.

Nosotros deseamos ponértelo fácil y por ello queremos ofrecerte un listado de los algoritmos de Google más relevantes.

Core Updates en 2020

Los Core Updates no son exactamente algoritmos sino actualizaciones generales que suelen tener efectos muy visibles.

A lo largo del año 2020 se han lanzado dos de estos Core Updates en los meses de enero y mayo.

Han afectado a webs de temáticas relacionadas con animales, motor, viajes y salud entre otras que ha provocado cambios tanto en e-commerce y medios de prensa como en nichos específicos y blogs.

El objetivo de la actualización de mayo se fijó en ofrecer información relevante y de confianza a los usuarios, en especial tras la aparición del Covid-19 que disparó todo tipo de bulos y desinformación en Google.

En diciembre de ese mismo año muchas webs experimentaron una fuerte caída de tráfico que se recuperó poco después, lo que suele ser señal de otra actualización.

Google Neural Matching – 2019

El algoritmo Google Neural Matching, introducido en 2019, tuvo un impacto notable en el SEO local, transformando cómo Google entiende y clasifica las consultas de búsqueda relacionadas con servicios o negocios locales.

Antes de Neural Matching, la optimización para búsquedas locales dependía en gran medida de la coincidencia directa de palabras clave y la presencia de señales locales específicas, como menciones de la ciudad o la región, reseñas locales y entradas en directorios de negocios.

Con la implementación de Neural Matching, Google avanzó hacia una comprensión más profunda del significado y la intención detrás de las consultas de los usuarios, incluso cuando no incluye el nombre concreto de la ciudad o región.

Esto significa que Google puede ahora relacionar una consulta con un servicio local relevante basándose en el entendimiento semántico de la consulta, incluso si la consulta y el contenido del sitio web no coinciden exactamente en términos de palabras clave.

Google YMYL – 2018

Las webs de salud fueron las principales afectadas con la llegada de este algoritmo ya que provocó la caída en las SERPs de las páginas web de dietas, enfermedades, salud, etcétera… que no estuvieran respaldas por profesionales perjudicando así a los nichos relacionados con estos temas.

Además, también afectó a las páginas web que se dedicaban a los créditos y a diferentes formas de ganar dinero.

Sin duda fue un golpe que afectó a muchos usuarios que monetizaban nichos de estas temáticas y que no lograron adaptarse a las nuevas exigencias de Google al respecto.

Hoy día algunos usuarios consiguen levantar webs relacionadas pero reforzando mucho la autoridad.

Google Fred – 2017

Fred llegó sin avisar para encargarse de las webs dedicadas a ganar dinero a través de Internet (siempre que no fuera con Google Adsense) y que dejaran la experiencia de usuario y la calidad de los contenidos en un segundo plano.

De nuevo, si tu página tiene publicidad no tienes que temer a Fred siempre y cuando ofrezcas contenido de valor a tus lectores.

Google Mobile First Index – 2016

Como resultado del uso masivo de los teléfonos móviles a la hora de consultar páginas en Internet, Google lanzó este algoritmo que favorece el posicionamiento de aquellos sitios con un diseño web que se ve bien en la pantalla de un móvil: botones de tamaño correcto, enlaces que no se solapan, imágenes que no rompen el formato…

Debido a ello, aunque tu página se vea perfecta en el ordenador no va a indexar si no tiene una buena visualización en el móvil ya que ahora es más importante que el equipo de sobremesa.

Google Possum – 2016

Una vez más Google saca a la luz otro algoritmo enfocado al SEO local.

Se trata de una actualización en base al algoritmo Venice que afina aún más la localización de un negocio a la hora de buscar productos o servicios. Antes, el buscador localizaba tu IP para mostrarte resultados situados en tu ciudad.

Gracias a Possum, ahora Google tiene en cuenta negocios de otras localidades o municipios que geográficamente puedan estar más cerca que los locales de tu propia ciudad.

En sitios grandes como Madrid o Barcelona supuso un cambio muy relevante tanto para los usuarios como para los negocios locales no solo en SEO sino en marketing digital.

Google RankBrain – 2015

Este algoritmo es como una actualización de Penguin y Panda ya que interpreta las respuestas que aparecen en las SERPs ante determinadas búsquedas mediante el uso de la Inteligencia Artificial en lo que respecta a los vectores y las matemáticas.

Cuando haces una búsqueda y no te satisfacen los resultados y decides modificar esa búsqueda añadiendo o quitando palabras, Google registra ese movimiento y se encarga de actualizar sus resultados en base a la búsqueda que sí te ha dejado satisfecho.

De esta forma, mejora aún más las SERPs conforme a las experiencias de los propios usuarios en ellas.

Google Mobilegeddon – 2015

La llegada de Mobilegeddon supuso el ascenso de webs “mobile-friendly”, es decir, que se adaptan a las pantallas de los móviles, es decir, a aquellas que tenían un theme responsive que mejoraba la experiencia del usuario desde cualquier dispositivo.

Aunque en la actualidad prácticamente todos los themes son responsive y se adaptan a cualquier pantalla, en el momento en el que apareció este algoritmo los diseños de páginas web se planificaban para ser vistos en la pantalla de un ordenador.

Esto hacía que al abrir una web en el móvil, ésta pudiera aparecer con los elementos descolocados, demasiado grandes o demasiado pequeños, etc.

Hoy día en el que una gran mayoría de los usuarios consulta páginas webs desde el teléfono móvil ya resulta impensable utilizar un desarrollo web con un theme no responsive.

Google Pirate 2.0 – 2014

Este algoritmo en realidad es una actualización del que había salido dos años atrás, Pirate 1.0, y que afectaba a las páginas de descargas ilegales: películas, música, libros, juegos…

No solo penalizaba los sitios webs piratas sino que beneficiaba a aquellas que ofrecen descargas de forma legal.

Aunque no parece haber habido demasiados movimientos al respecto sí se ha observado que es muy difícil poner anuncios de Google Adsense en las páginas de descargas por lo que siguen siendo penalizadas de alguna manera.

Por ese motivo, ese tipo de webs pensadas para monetizar hace tiempo que dejaron de ser rentables en la mayor parte de los casos.

Google y el HTTPS – 2014

En el año 2014 Google anunció el cambio de http a https. No fue un cambio demasiado polémico ni comentado en su momento pero desde el principio quedó claro que ese factor iba a ser importante a la hora de posicionar una web.

La importancia del certificado SSL es que se encarga de codificar los datos del usuario en la página web, lo que le ofrece una mayor seguridad acerca del uso de los mismos y posibles robos.

Pronto se comprobó que las páginas que no lo implantaron perdieron visibilidad frente a aquellas que sí lo hicieron. Además, el aviso de falta de seguridad que aparece en el navegador cuando el usuario accede a una web que no cuenta con el protocolo https puede provocar que abandone la página.

Google Pigeon – 2014

La misión de Google Pigeon fue depurar las búsquedas locales y por desgracia para quienes se enfocan al SEO local es uno de los algoritmos de los que menos se sabe.

Esta nueva fórmula matemática solicitada por el buscador YELP concede más importancia a los contenidos y a los enlaces entrantes locales por encima de los globales siempre que estemos hablando de un negocio local, por supuesto.

Si te dedicas al SEO local, permanece atento a los movimientos de Google Pigeon.

Google Hummingbird – 2013

Este algoritmo de búsqueda se dedicó a buscar la naturalidad tanto en las búsquedas como en los contenidos y su implantación afectó a un 90% de estas búsquedas.

Es decir, Hummingbird apareció para mejorar la respuesta a la intención de búsqueda del usuario añadiendo sencillez y naturalidad a los resultados.

Google Penguin – 2012

Este algoritmo se dedica a detectar aquellos sitios web que han crecido a base de enlaces de mala calidad.

Como quizá sabrás, hace bastantes años era muy fácil ganar posiciones con enlaces poco cuidados y que ni siquiera tenían que tener afinidad temática.

Abundaban las granjas de enlaces y todo tipo de prácticas Black Hat para poder escalar rápidamente en las SERPs.

Es en este contexto en el que aparece Penguin penalizando este tipo de acciones y premiando a las páginas web que consiguen enlaces entrantes de forma natural.

La calidad tomó relevancia por encima de la cantidad a partir de ese momento y por ello siempre recomendamos que, a la hora de comprar enlaces, procures que tengan relación con la temática de tu web y que no sean demasiados.

Google Venice – 2012

Venice llegó con la intención de mejorar las búsquedas locales y tras su aparición se vieron afectadas muchas páginas web aunque mejoró notablemente la experiencia del usuario.

El mayor cambio que introdujo fue que, cuando el usuario buscaba productos o servicios en su ciudad, ya no le hacía falta agregar en la búsqueda el nombre de la misma sino que Google, automáticamente, le ofrecía los mejores resultados más cercanos.

Aquellas webs más globales acabaron perjudicadas pero, por el contrario, para el usuario este tipo de búsquedas se hicieron más cómodas y los negocios locales con página web se vieron beneficiados.

Fue en este momento cuando se empezó a valorar la presencia de un mapa en el sitio web con la localización avalada por la ficha de Google My Business.

Google Panda – 2011

Este algoritmo lleva más de diez años entre nosotros y es el que se encarga de aplicar filtros para distinguir el contenido de buena calidad de las páginas web que hay en Internet, siempre en base a la intención de búsqueda del usuario.

El Panda, como se lo conoce habitualmente, penaliza el contenido de poco valor o thin content, el contenido duplicado y, en definitiva, todo aquello que no aporte nada al usuario. Por eso y como te decíamos antes, si tu contenido es original y ofrece valor y respuestas a tus lectores, no tendrás que preocuparte por este algoritmo.

***

Como ves, los algoritmos de Google siempre se enfocan hacia la satisfacción del usuario así que todo lo que tienes que hacer para no verte perjudicado es ofrecerle valor y buenas experiencias a las personas que lleguen a tu página web.

La naturalidad y las ganas de aportar, al final, resultan ser el mejor secreto para que no te afecten los cambios en el algoritmo.